Стремительное и неожиданное развитие ChatGPT — чат-бота на основе искусственного интеллекта (ИИ) с передовыми функциями — в определённой степени изменило жизнь людей, особенно в плане работы. Однако риски, связанные с этой технологией, вызвали серьёзную обеспокоенность у властей многих стран, особенно в отношении пользовательских данных.

В условиях, когда в мире по-прежнему отсутствует надежная новая правовая база для эффективного управления ИИ и обеспечения высокой надежности для пользователей, многие страны начали принимать меры по регулированию использования ChatGPT и ИИ в целом, чтобы минимизировать риски, которые несет эта технология.

Многие страны «принимают меры» с помощью ИИ

Италия находится в авангарде принятия решения о запрете ChatGPT.

31 марта итальянские власти временно запретили приложение ChatGPT из-за проблем с конфиденциальностью и отсутствия в нём верификации пользователей в возрасте 13 лет и старше, как того требует итальянское законодательство. В то же время Италия заявила о намерении начать расследование использования OpenAI пользовательских данных.

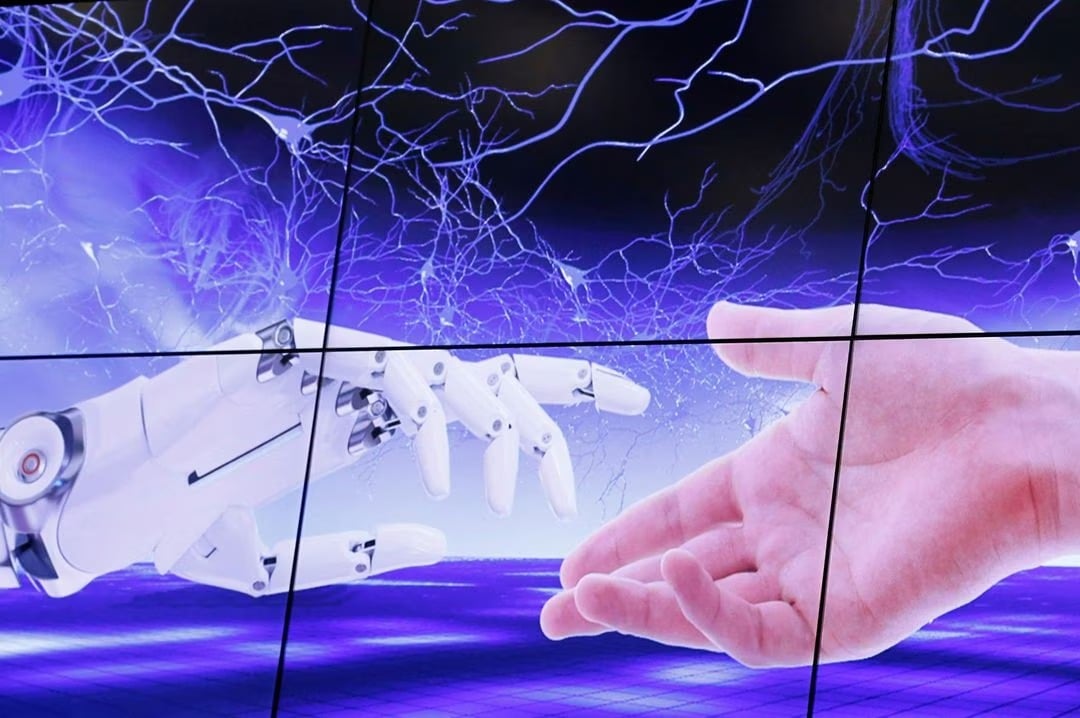

После запрета ChatGPT в Италии многие страны приняли меры против этого приложения. (Фото: Reuters).

Итальянский орган по защите данных установил для OpenAI — компании, создавшей ChatGPT, — крайний срок — конец апреля, чтобы выполнить требования по защите данных и конфиденциальности, прежде чем возобновить нормальную работу в стране.

Сразу после решения Италии многие страны начали «последовать» ее примеру и заблокировали ChatGPT из-за опасений, связанных с вопросами безопасности и конфиденциальности данных.

Французские и ирландские органы по защите конфиденциальности и безопасности обратились к своим итальянским коллегам, чтобы узнать об основаниях для запрета. 11 апреля французский надзорный орган по защите конфиденциальности (CNIL) заявил, что расследует несколько жалоб на ChatGPT.

Уполномоченный Германии по защите данных заявил, что Берлин, вероятно, «последует примеру Италии» и заблокирует ChatGPT.

В частности, 13 апреля Европейский орган по защите данных (EDPB) создал целевую группу по ChatGPT, заявив: «Государства-члены EDPB обсудили недавние меры принудительного характера, принятые итальянским органом по защите данных против OpenAI в отношении сервиса ChatGPT. EDPB принял решение о создании целевой группы для развития сотрудничества и обмена информацией о возможных мерах принудительного характера».

Кроме того, законодатели Европейского союза (ЕС) обсуждают Закон ЕС об искусственном интеллекте (ИИ), который будет регулировать деятельность всех, кто предоставляет продукты или услуги с использованием ИИ, включая системы, генерирующие контент, прогнозы, рекомендации или решения, влияющие на окружающую среду. ЕС также предложил классифицировать различные инструменты ИИ по уровню риска — от низкого до неприемлемого.

Испанское агентство по защите данных AEPD объявило о проведении предварительного расследования утечек данных ChatGPT.

В Австралии Министерство науки и технологий объявило 12 апреля, что правительство обратилось к своему научному консультативному органу за советом о том, как реагировать на ИИ, и рассматривает дальнейшие шаги.

Этот шаг поднимает вопросы о безопасности ИИ и о том, что могут сделать правительства для снижения связанных с ним рисков. Согласно мартовскому отчёту консалтинговой компании KPMG и Австралийской ассоциации информационной индустрии, две трети австралийцев заявили о недостаточности законов и нормативных актов, препятствующих неправомерному использованию ИИ, в то время как менее половины респондентов считают, что ИИ безопасно используется на рабочем месте.

Многие страны начали принимать меры по регулированию технологий искусственного интеллекта. (Фото: Reuters).

В Великобритании правительство заявило, что намерено разделить ответственность за регулирование ИИ между органами по правам человека, охране труда и технике безопасности и защите конкуренции вместо создания нового регулирующего органа.

Недавно лидер демократического большинства в Сенате США Чак Шумер разработал и опубликовал новую нормативную базу в области ИИ, которая может предотвратить катастрофический ущерб для страны. Предложение г-на Шумера обязывает компании предоставлять независимым экспертам возможность изучать и тестировать технологии ИИ перед их выпуском или обновлением.

Ранее 11 апреля Министерство торговли США заявило, что ищет публичные комментарии относительно мер по обеспечению ответственности ИИ.

Тем временем Центр искусственного интеллекта и цифровой политики США обратился в Комиссию по торговле с просьбой запретить OpenAI выпускать новые коммерческие версии GPT-4, утверждая, что эта технология «предвзята, обманчива и представляет угрозу конфиденциальности и общественной безопасности».

Тем временем в Японии министр цифровой трансформации Таро Коно заявил, что хочет, чтобы на предстоящей встрече министров цифровых технологий G7, которая должна состояться в конце апреля, были обсуждены технологии искусственного интеллекта, включая ChatGPT, и было принято единое послание G7.

Недавно Китай объявил о планируемых мерах по регулированию услуг ИИ, заявив, что компании, поставляющие технологии ИИ, должны представить властям оценку безопасности, прежде чем выводить услуги на рынок.

Эксперты предупреждают об опасностях, исходящих от ИИ

Некоторые эксперты утверждают, что ИИ может привести к «катастрофе ядерного уровня». (Фото: Reuters).

Опрос, опубликованный Институтом искусственного интеллекта Стэнфордского университета в начале апреля, показал, что 36% исследователей считают, что ИИ может привести к «ядерной катастрофе», что еще больше подчеркивает существующие опасения по поводу быстрого развития этой технологии.

Между тем, 73% ИИ приведут к «революционным социальным изменениям».

В отчете говорится, что, хотя эти технологии предлагают возможности, немыслимые еще десять лет назад, они также подвержены иллюзиям, предвзятости и злоупотреблениям в неблаговидных целях, что создает этические проблемы для пользователей этих услуг.

В отчете также отмечается, что количество «инцидентов и противоречий», связанных с ИИ, за последнее десятилетие увеличилось в 26 раз.

В прошлом месяце миллиардер Илон Маск и соучредитель Apple Стив Возняк были среди тысяч технических экспертов, подписавших письмо с призывом приостановить обучение систем ИИ, более мощных, чем чат-бот GPT-4 от Open AI, заявив, что «мощные системы ИИ следует разрабатывать только после того, как мы будем уверены, что их влияние будет положительным, а их риски будут управляемыми».

Юнкан (Reuters, AL Jazeera, ABC)

Источник

![[Фото] Закрытие I съезда делегатов центральных партийных органов](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/9/24/b419f67738854f85bad6dbefa40f3040)

![[Фото] Главный редактор газеты Nhan Dan Ле Куок Минь принял рабочую делегацию газеты Pasaxon](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/9/23/da79369d8d2849318c3fe8e792f4ce16)

![[Фото] Торжественное открытие I съезда делегатов центральных партийных органов](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/9/24/82a89e250d4d43cbb6fcb312f21c5dd4)

Комментарий (0)