Forskare på DeepSeek har tillkännagivit en ny experimentell modell som heter V3.2-exp, utformad för att avsevärt minska kostnaden för inferens när den används i långa kontextoperationer.

DeepSeek tillkännagav modellen i ett inlägg på Hugging Face, och publicerade även en länkad akademisk artikel på GitHub.

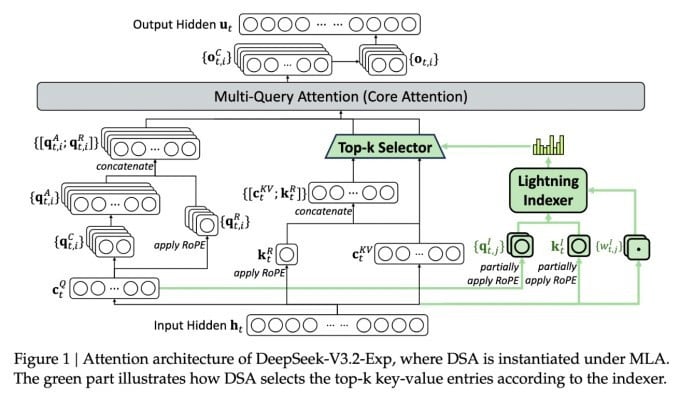

Den viktigaste funktionen i den komplexa nya modellen kallas DeepSeek Sparse Attention. I huvudsak använder systemet en modul som kallas en "lightning indexer" för att prioritera specifika utdrag från kontextfönstret.

DeepSeek tillkännager kostnadseffektiv inferensmodell.

Ett separat system som kallas "finkornigt tokenvalssystem" väljer sedan specifika tokens från dessa kodavsnitt för att laddas in i modulens begränsade uppmärksamhetsfönster. Tillsammans tillåter de Sparse Attention-modeller att fungera på långa kontextavsnitt med relativt liten serverbelastning.

För långkontextoperationer är systemets fördelar betydande. DeepSeeks preliminära tester visar att kostnaden för ett enkelt API-anrop (inference function) kan minskas med upp till hälften i långkontextscenarier.

Ytterligare tester behövs för att bygga en mer robust bedömning, men eftersom modellen är öppen och fritt tillgänglig på Hugging Face, borde det inte dröja länge innan tredjepartstester kan utvärdera påståendena i artikeln.

Till skillnad från andra AI-chatbotmodeller som förbrukar mycket energi, går DeepSeek i riktning mot att spara kostnader från utbildning till drift.

DeepSeeks nya modell är ett i en serie genombrott som nyligen tagit itu med problemet med inferenskostnader – i huvudsak serverkostnaden för att köra en förtränad AI-modell, i motsats till kostnaden för att träna den.

I DeepSeeks fall letade forskarna efter sätt att effektivisera den grundläggande transformatorarkitekturen – och fann att betydande förbättringar behövde göras.

DeepSeek, baserat i Kina, är en ovanlig figur inom AI-trenden, särskilt för de som ser AI-forskning som en konkurrens mellan USA och Kina. Företaget gjorde stor succé tidigare i år med sin R1-modell, som främst tränades med hjälp av förstärkningsinlärning till en mycket lägre kostnad än sina amerikanska konkurrenter.

Modellen misslyckades dock med att utlösa den fullskaliga revolution inom AI-utbildning som vissa förutspådde, och företaget drog sig långsamt tillbaka från rampljuset under de följande månaderna.

Den nya metoden med ”gles uppmärksamhet” kommer sannolikt inte att orsaka lika mycket upprördhet som R1 – men den skulle fortfarande kunna lära amerikanska tjänsteleverantörer några välbehövliga knep för att hålla inferenskostnaderna nere.

https://techcrunch.com/2025/09/29/deepseek-releases-sparse-attention-model-that-cuts-api-costs-in-half/

Källa: https://khoahocdoisong.vn/deepseek-dao-tao-da-re-nay-con-co-ban-suy-luan-re-hon-post2149057353.html

![[Foto] Elever på Binh Minh Primary School njuter av fullmånefestivalen och får ta del av barndomens glädjeämnen.](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/3/8cf8abef22fe4471be400a818912cb85)

![[Foto] Premiärminister Pham Minh Chinh leder möte för att utplacera för att hantera konsekvenserna av storm nr 10](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/3/544f420dcc844463898fcbef46247d16)

![[INFOGRAFIK] En tillbakablick på de tider då den amerikanska regeringen stängde ner](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/10/3/c467276604584d2889c0d2d84fecd986)

Kommentar (0)