นักวิจัยที่ DeepSeek ได้ประกาศเปิดตัวโมเดลทดลองใหม่ที่เรียกว่า V3.2-exp ซึ่งออกแบบมาเพื่อลดต้นทุนการอนุมานอย่างมากเมื่อใช้ในการดำเนินการบริบทระยะยาว

DeepSeek ได้ประกาศเปิดตัวโมเดลดังกล่าวในโพสต์บน Hugging Face และยังโพสต์เอกสารวิชาการที่เชื่อมโยงบน GitHub อีกด้วย

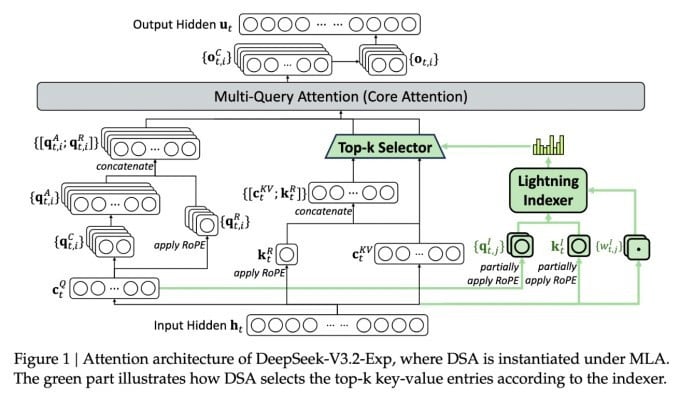

คุณสมบัติที่สำคัญที่สุดของโมเดลใหม่ที่ซับซ้อนนี้เรียกว่า DeepSeek Sparse Attention โดยพื้นฐานแล้ว ระบบจะใช้โมดูลที่เรียกว่า “lightning indexer” เพื่อจัดลำดับความสำคัญของข้อความคัดย่อเฉพาะจากหน้าต่างบริบท

DeepSeek ประกาศเปิดตัวโมเดลอนุมานที่คุ้มต้นทุน

ระบบแยกต่างหากที่เรียกว่า "ระบบการเลือกโทเค็นแบบละเอียด" จะเลือกโทเค็นเฉพาะจากสไนปเป็ตเหล่านั้นเพื่อโหลดเข้าสู่หน้าต่างความสนใจที่จำกัดของโมดูล เมื่อรวมกันแล้ว ระบบเหล่านี้จะช่วยให้โมเดล Sparse Attention สามารถทำงานกับบริบทยาวๆ ได้ โดยมีภาระงานของเซิร์ฟเวอร์ค่อนข้างน้อย

สำหรับการดำเนินการในบริบทยาว ประโยชน์ของระบบมีนัยสำคัญ การทดสอบเบื้องต้นของ DeepSeek แสดงให้เห็นว่าค่าใช้จ่ายในการเรียกใช้ฟังก์ชันอนุมานแบบง่าย (API) สามารถลดลงได้ถึงครึ่งหนึ่งในสถานการณ์บริบทยาว

จำเป็นต้องมีการทดสอบเพิ่มเติมเพื่อสร้างการประเมินที่แข็งแกร่งยิ่งขึ้น แต่เนื่องจากโมเดลดังกล่าวเปิดและใช้งานได้ฟรีบน Hugging Face จึงไม่น่าจะใช้เวลานานก่อนที่การทดสอบของบุคคลที่สามจะสามารถประเมินข้อเรียกร้องในเอกสารได้

แตกต่างจากโมเดล AI Chatbot อื่นๆ ที่ใช้พลังงานจำนวนมาก DeepSeek มุ่งเน้นไปที่การประหยัดต้นทุนตั้งแต่การฝึกอบรมไปจนถึงการดำเนินการ

โมเดลใหม่ของ DeepSeek เป็นหนึ่งในชุดความก้าวหน้าล่าสุดที่ช่วยแก้ปัญหาต้นทุนการอนุมาน ซึ่งก็คือต้นทุนของเซิร์ฟเวอร์ในการรันโมเดล AI ที่ได้รับการฝึกอบรมไว้ล่วงหน้า เมื่อเทียบกับต้นทุนในการฝึกอบรมโมเดลดังกล่าว

ในกรณีของ DeepSeek นักวิจัยกำลังมองหาวิธีที่จะทำให้สถาปัตยกรรมหม้อแปลงพื้นฐานมีประสิทธิภาพมากขึ้น และพบว่าจำเป็นต้องมีการปรับปรุงที่สำคัญ

DeepSeek ซึ่งมีสำนักงานใหญ่อยู่ในประเทศจีน เป็นบุคคลที่ไม่ธรรมดาในวงการ AI โดยเฉพาะอย่างยิ่งสำหรับผู้ที่มีมุมมองว่าการวิจัย AI เป็นการแข่งขันระหว่างสหรัฐอเมริกาและจีน บริษัทได้สร้างปรากฏการณ์ครั้งสำคัญในช่วงต้นปีที่ผ่านมาด้วยโมเดล R1 ซึ่งฝึกฝนโดยใช้การเรียนรู้แบบเสริมแรงเป็นหลัก โดยมีต้นทุนต่ำกว่าคู่แข่งในสหรัฐอเมริกามาก

อย่างไรก็ตาม โมเดลดังกล่าวไม่สามารถจุดประกายการปฏิวัติเต็มรูปแบบในการฝึกอบรม AI อย่างที่บางคนคาดการณ์ไว้ได้ และบริษัทก็ค่อยๆ ถอยห่างจากจุดสนใจในช่วงหลายเดือนต่อมา

แนวทางใหม่ "การใส่ใจแบบเบาบาง" นั้นไม่น่าจะก่อให้เกิดความไม่พอใจมากเท่ากับ R1 แต่ก็ยังคงสามารถสอนเทคนิคที่จำเป็นอย่างยิ่งบางอย่างให้กับผู้ให้บริการในสหรัฐฯ เพื่อช่วยให้ต้นทุนการอนุมานต่ำลงได้

https://techcrunch.com/2025/09/29/deepseek-releases-sparse-attention-model-that-cuts-api-costs-in-half/

ที่มา: https://khoahocdoisong.vn/deepseek-dao-tao-da-re-nay-con-co-ban-suy-luan-re-hon-post2149057353.html

![[ภาพ] นักเรียนโรงเรียนประถมศึกษาบิ่ญมิญสนุกสนานกับเทศกาลไหว้พระจันทร์ พร้อมรับความสุขในวัยเด็ก](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/3/8cf8abef22fe4471be400a818912cb85)

![[ภาพ] นายกรัฐมนตรีฝ่ามมินห์จิ่ง เป็นประธานการประชุมเพื่อเตรียมรับมือกับผลกระทบจากพายุหมายเลข 10](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/3/544f420dcc844463898fcbef46247d16)

การแสดงความคิดเห็น (0)