DeepSeek araştırmacıları, uzun bağlamlı işlemlerde kullanıldığında çıkarım maliyetini önemli ölçüde azaltmak üzere tasarlanmış V3.2-exp adı verilen yeni bir deneysel model duyurdu.

DeepSeek, modeli Hugging Face'te yayınladığı bir gönderiyle duyurdu ve ayrıca GitHub'da bağlantılı bir akademik makale yayınladı.

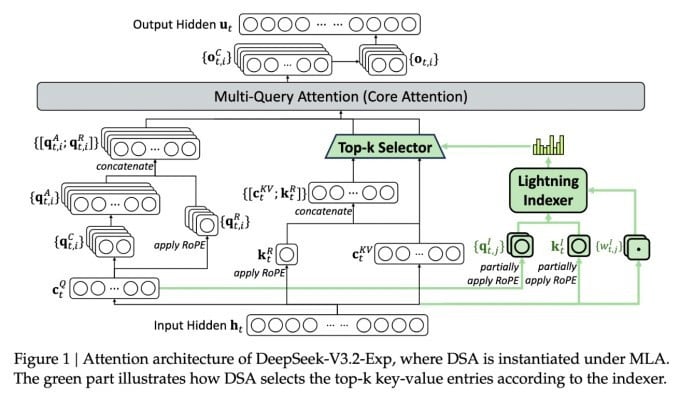

Karmaşık yeni modelin en önemli özelliği DeepSeek Sparse Attention. Sistem, esasen bağlam penceresinden belirli alıntıları önceliklendirmek için "yıldırım indeksleyici" adı verilen bir modül kullanıyor.

DeepSeek maliyet etkin çıkarım modelini duyurdu.

"İnce ayrıntılı belirteç seçim sistemi" adı verilen ayrı bir sistem, modülün sınırlı dikkat penceresine yüklenmek üzere bu kod parçacıklarından belirli belirteçleri seçer. Birlikte, Seyrek Dikkat modellerinin nispeten küçük sunucu yüküne sahip uzun bağlam parçalarında çalışmasına olanak tanırlar.

Uzun bağlamlı işlemler için sistemin faydaları önemlidir. DeepSeek'in ön testleri, basit bir çıkarım fonksiyonu (API) çağrısının maliyetinin uzun bağlamlı senaryolarda yarı yarıya azaltılabileceğini göstermektedir.

Daha sağlam bir değerlendirme oluşturmak için daha fazla teste ihtiyaç var, ancak model Hugging Face'te açık ve ücretsiz olarak mevcut olduğundan, üçüncü taraf testlerinin makaledeki iddiaları değerlendirmesi uzun sürmeyecektir.

Diğer yapay zeka chatbot modellerinin çok fazla enerji tüketmesinin aksine DeepSeek, eğitimden operasyona kadar maliyetleri düşürme yönünde ilerliyor.

DeepSeek'in yeni modeli, çıkarım maliyeti sorununu ele alan bir dizi yeni buluştan biri. Bu sorun, önceden eğitilmiş bir yapay zeka modelini çalıştırmanın sunucu maliyeti ile onu eğitmenin maliyeti arasındaki farktan oluşuyor.

DeepSeek örneğinde, araştırmacılar temel transformatör mimarisini daha verimli hale getirmenin yollarını arıyorlardı ve önemli iyileştirmeler yapılması gerektiğini buldular.

Çin merkezli DeepSeek, özellikle yapay zeka araştırmalarını ABD ile Çin arasında bir rekabet olarak görenler için yapay zeka çılgınlığında alışılmadık bir isim. Şirket, bu yılın başlarında, ABD'li rakiplerine göre çok daha düşük maliyetli, ağırlıklı olarak takviyeli öğrenme kullanılarak eğitilen R1 modeliyle büyük bir yankı uyandırdı.

Ancak bu model, bazı kesimlerin öngördüğü yapay zeka eğitiminde tam ölçekli devrimi başlatmayı başaramadı ve şirket, takip eden aylarda yavaş yavaş ilgi odağı olmaktan çıktı.

Yeni "seyrek dikkat" yaklaşımının R1 kadar büyük bir tepkiye yol açması pek olası değil; ancak yine de ABD'li hizmet sağlayıcılarına çıkarım maliyetlerini düşük tutmalarına yardımcı olacak bazı çok ihtiyaç duyulan püf noktaları öğretebilir.

https://techcrunch.com/2025/09/29/deepseek-releases-sparse-attention-model-that-cuts-api-costs-in-half/

Kaynak: https://khoahocdoisong.vn/deepseek-dao-tao-da-re-nay-con-co-ban-suy-luan-re-hon-post2149057353.html

![[Fotoğraf] Binh Minh İlkokulu öğrencileri dolunay festivalinin tadını çıkarıyor, çocukluk sevinçlerini yeniden yaşıyorlar](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/3/8cf8abef22fe4471be400a818912cb85)

![[Fotoğraf] Başbakan Pham Minh Chinh, 10 numaralı fırtınanın sonuçlarının üstesinden gelmek için toplantıya başkanlık ediyor](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/3/544f420dcc844463898fcbef46247d16)

Yorum (0)