Складна картина використання роботів-вбивць на базі штучного інтелекту.

Дозвіл штучному інтелекту керувати системами озброєння може означати, що цілі будуть ідентифіковані, атаковані та знищені без втручання людини. Це викликає серйозні правові та етичні питання.

Підкреслюючи серйозність ситуації, міністр закордонних справ Австрії Александер Шалленберг заявив: «Це момент Оппенгаймера для нашого покоління».

Роботи та зброя на базі штучного інтелекту починають широко використовуватися у військах багатьох країн. Фото: Forbes

Дійсно, питання про те, наскільки «джин вирвався з банки», стало нагальним, враховуючи широке використання дронів та штучного інтелекту (ШІ) військовими по всьому світу .

Аналітик з питань оборони GlobalData Вілсон Джонс поділився: «Використання безпілотників Росією та Україною в сучасних конфліктах, використання США безпілотників у цілеспрямованих ударних операціях в Афганістані та Пакистані, а також, як нещодавно було виявлено минулого місяця, в рамках ізраїльської програми «Лаванда», демонструє, як можливості штучного інтелекту з обробки інформації активно використовуються світовими військовими для посилення своєї наступальної потужності».

Розслідування, проведене лондонським Управлінням воєнних розслідувань, показало, що система штучного інтелекту «Лаванда» ізраїльських військових мала 90% точність у виявленні осіб, пов’язаних з ХАМАС, тобто 10% не мали такої можливості. Це призвело до жертв серед цивільного населення через можливості штучного інтелекту щодо ідентифікації та прийняття рішень.

Загроза глобальній безпеці.

Використання штучного інтелекту таким чином підкреслює необхідність управління технологіями в системах озброєння.

Д-р Александр Бланшар, старший науковий співробітник програми управління штучним інтелектом у Стокгольмському міжнародному інституті дослідження проблем миру (SIPRI), незалежній дослідницькій групі, що спеціалізується на глобальній безпеці, пояснив виданню Army Technology: «Використання штучного інтелекту в системах озброєння, особливо для цільового призначення, порушує фундаментальні питання про те, хто ми є – люди – і про наші стосунки з війною, а точніше, про наші припущення щодо того, як ми можемо застосовувати насильство у збройних конфліктах».

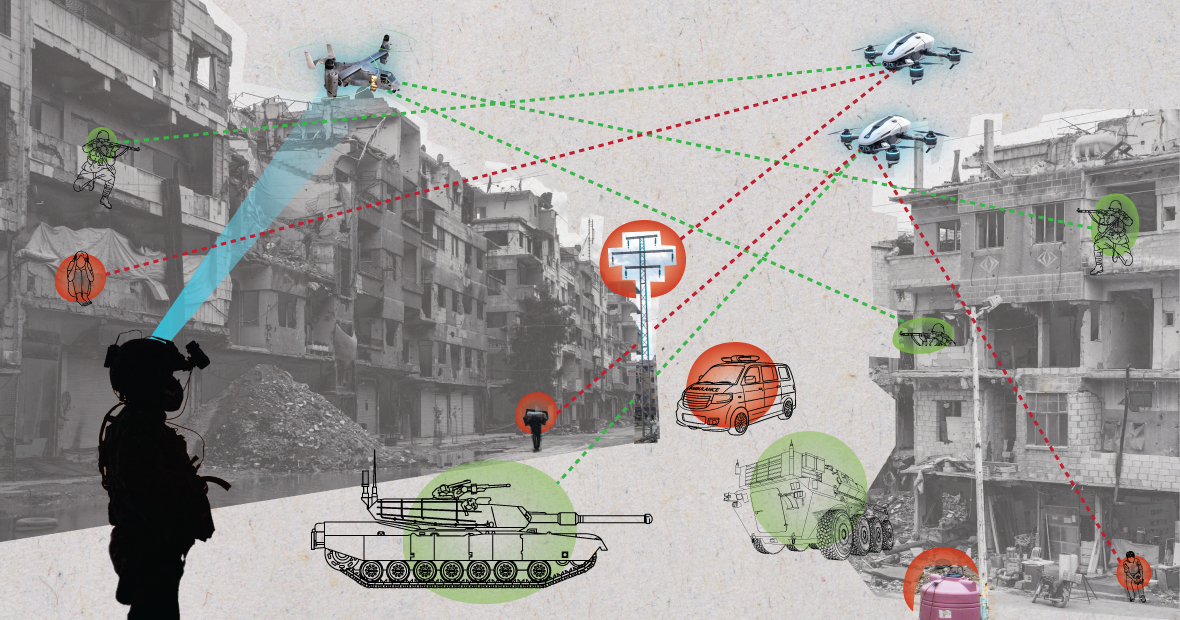

Під час використання в хаотичному середовищі системи штучного інтелекту можуть працювати непередбачувано та неточно ідентифікувати цілі. (Зображення: MES)

«Чи змінить штучний інтелект спосіб, у який військові обирають цілі та застосовують до них силу? Ці зміни, своєю чергою, викликають низку правових, етичних та оперативних питань. Найбільше занепокоєння викликає гуманітарний характер», – додав доктор Бланшар.

Експерт SIPRI пояснив: «Багато людей хвилюються, що залежно від того, як розроблені та використовуються автоматизовані системи, вони можуть наражати цивільних осіб та інших осіб, захищених міжнародним правом, на більший ризик. Це пояснюється тим, що системи штучного інтелекту, особливо коли вони використовуються в хаотичних умовах, можуть працювати непередбачувано та можуть неточно ідентифікувати цілі та атакувати цивільних осіб, або не ідентифікувати комбатантів, які знаходяться поза межами лінії вогню».

Розглядаючи це питання, аналітик з питань оборони GlobalData Вілсон Джонс зазначає, що питання про визначення провини може бути поставлене під сумнів.

«Згідно з чинними законами війни, існує поняття відповідальності командування», – сказав Джонс. «Це означає, що офіцер, генерал чи інший керівник несе юридичну відповідальність за дії військ під його командуванням. Якщо війська вчиняють воєнні злочини, офіцер несе відповідальність, навіть якщо він не віддавав наказу; тягар доказування лежить на них, демонструючи, що вони зробили все можливе, щоб запобігти воєнним злочинам».

«З системами штучного інтелекту це ускладнює ситуацію. Чи відповідає ІТ-технік? Системний розробник? Це незрозуміло. Якщо це незрозуміло, то це створює моральний ризик, якщо суб’єкти вважають, що їхні дії не захищені чинними законами», – наголосив Джонс.

Американський солдат патрулює з роботом-собакою. Фото: Forbes

Конвенції про контроль над озброєннями: Кілька основних міжнародних угод обмежують та регулюють певні види використання зброї. До них належать заборона хімічної зброї, договори про нерозповсюдження ядерної зброї та Конвенція про певні види звичайної зброї, які забороняють або обмежують використання конкретної зброї, що вважається такою, що завдає непотрібних або невиправданих страждань комбатантам або невибірково впливає на цивільне населення.

«Для забезпечення виконання контролю над ядерними озброєннями потрібні десятиліття міжнародної співпраці та подальших договорів», – пояснює аналітик з питань оборони Вілсон Джонс. «Навіть тоді ми продовжували атмосферні випробування до 1990-х років. Головною причиною успіху ядерного нерозповсюдження була співпраця між Сполученими Штатами та Радянським Союзом у біполярному світовому порядку. Цього більше не існує, і технології штучного інтелекту стали доступнішими для більшої кількості країн, ніж атомна енергія».

«Зобов’язувальний договір мав би зібрати всі залучені сторони за стіл переговорів, щоб домовитися не використовувати інструмент, який посилює їхню військову міць. Це навряд чи буде ефективним, оскільки штучний інтелект може підвищити військову ефективність з мінімальними фінансовими та матеріальними витратами».

Сучасна геополітична перспектива

Хоча країни-члени Організації Об'єднаних Націй визнали необхідність відповідального використання штучного інтелекту військовими, ще багато роботи попереду.

Лаура Петроне, головний аналітик GlobalData, розповіла Army Technology: «Через відсутність чіткої керівної бази ці заяви залишаються значною мірою амбітними. Не дивно, що деякі країни хочуть зберегти власний суверенітет під час вирішення питань внутрішньої оборони та національної безпеки, особливо в контексті поточної геополітичної напруженості».

Пані Петроне додала, що, хоча Закон ЄС про штучний інтелект встановлює деякі вимоги до систем штучного інтелекту, він не стосується систем штучного інтелекту для військових цілей.

«Я вважаю, що, незважаючи на це виключення, Закон про штучний інтелект є важливою спробою створити давно назрілу систему для застосування штучного інтелекту, що може призвести до певного ступеня гармонізації відповідних стандартів у майбутньому», – прокоментувала вона. «Ця гармонізація також матиме вирішальне значення для штучного інтелекту у військових».

Нгуєн Кхань

Джерело: https://www.congluan.vn/moi-nguy-robot-sat-thu-ai-dang-de-doa-an-ninh-toan-cau-post304170.html

![[Фото] Прем'єр-міністр Фам Мінь Чінь взяв участь у Конференції з питань виконання завдань на 2026 рік у секторі промисловості та торгівлі](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F19%2F1766159500458_ndo_br_shared31-jpg.webp&w=3840&q=75)

Коментар (0)