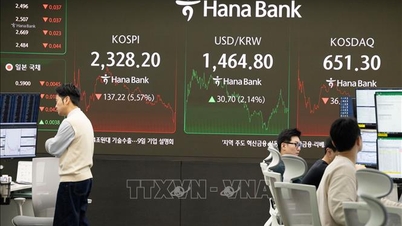

৩ ডিসেম্বর এনভিডিয়া নতুন তথ্য প্রকাশ করেছে যা দেখায় যে তাদের নতুন কৃত্রিম বুদ্ধিমত্তা (এআই) সার্ভারটি চীনের জনপ্রিয় মডেলগুলি সহ উন্নত এআই মডেলগুলির কর্মক্ষমতা পূর্ববর্তী প্রজন্মের সার্ভারের তুলনায় ১০ গুণ পর্যন্ত উন্নত করতে সক্ষম।

এই তথ্যটি এসেছে যখন AI শিল্প মডেল প্রশিক্ষণ থেকে তার মনোযোগ সরিয়ে নিচ্ছে, যে ক্ষেত্রটিতে Nvidia বর্তমানে নেতৃত্ব দিচ্ছে, লক্ষ লক্ষ ব্যবহারকারীর কাছে মডেল স্থাপনের দিকে, যেখানে অ্যাডভান্সড মাইক্রো ডিভাইস (AMD) এবং সেরিব্রাসের মতো প্রতিদ্বন্দ্বীদের কাছ থেকে প্রতিযোগিতা বাড়ছে।

এনভিডিয়া বলছে যে এই উন্নতিগুলি মূলত একটি একক সার্ভারে বিপুল সংখ্যক চিপ প্যাক করার ক্ষমতা এবং তাদের মধ্যে উচ্চ-গতির সংযোগের কারণে এসেছে, এমন একটি ক্ষেত্র যেখানে এটি এখনও তার প্রতিদ্বন্দ্বীদের উপর নেতৃত্ব দেয় এবং স্পষ্ট সুবিধা বজায় রাখে। এনভিডিয়ার সর্বশেষ এআই সার্ভারটি তার ৭২টি শীর্ষ-অফ-দ্য-লাইন চিপ দিয়ে সজ্জিত।

এনভিডিয়া যে তথ্য প্রকাশ করেছে তা মূলত এআই মডেলগুলির উপর দৃষ্টি নিবদ্ধ করে যা মিক্সচার-অফ-এক্সপার্টস (MoE) আর্কিটেকচার ব্যবহার করে, এমন একটি পদ্ধতি যা এআই মডেলগুলির কর্মক্ষমতাকে অপ্টিমাইজ করে কাজগুলিকে পৃথক অংশে ভাগ করে এবং প্রক্রিয়াকরণের জন্য মডেলের মধ্যে বিভিন্ন "বিশেষজ্ঞদের" কাছে বরাদ্দ করে।

২০২৫ সালে MoE আর্কিটেকচার জনপ্রিয়তা অর্জন করে, বিশেষ করে যখন DeepSeek, একটি চীনা AI কোম্পানি, একটি উচ্চ-কার্যক্ষমতাসম্পন্ন ওপেন-সোর্স মডেল চালু করে যার জন্য অন্যান্য প্রতিযোগীদের তুলনায় Nvidia চিপগুলিতে কম প্রশিক্ষণের সময় প্রয়োজন হয়।

তারপর থেকে, OpenAI (ChatGPT-এর নির্মাতা), ফ্রান্সের Mistral এবং চীনের Moonshot AI-এর মতো বড় কোম্পানিগুলি তাদের মডেলগুলিতে MoE পদ্ধতি প্রয়োগ করা শুরু করেছে। Moonshot AI গত জুলাইয়ে একটি অত্যন্ত সম্মানিত ওপেন-সোর্স মডেল প্রকাশ করেছে যা এই কৌশলটি ব্যবহার করে।

এনভিডিয়া যদিও এআই মডেল স্থাপনের ক্ষেত্রে একটি অগ্রণী ভূমিকা বজায় রেখেছে, এএমডির মতো প্রতিদ্বন্দ্বীরাও প্রতিযোগী পণ্য তৈরির জন্য কঠোর পরিশ্রম করছে।

AMD আগামী বছর একই ধরণের একটি AI সার্ভার চালু করবে বলে আশা করা হচ্ছে, যা অনেক শক্তিশালী চিপকে একীভূত করবে এবং ইনফারেন্স (মডেল প্রক্রিয়াকরণ এবং স্থাপনা) ক্ষেত্রে Nvidia এর সার্ভারের সাথে সরাসরি প্রতিযোগিতা করবে।

সূত্র: https://www.vietnamplus.vn/nvidia-cong-bo-may-chu-ai-moi-co-hieu-suat-cao-gap-10-lan-post1080980.vnp

![[ছবি] ক্যাট বা - সবুজ দ্বীপের স্বর্গ](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F04%2F1764821844074_ndo_br_1-dcbthienduongxanh638-jpg.webp&w=3840&q=75)

![[VIMC ৪০ দিনের বিদ্যুৎ গতি] দা নাং বন্দর: ঐক্য - বিদ্যুৎ গতি - শেষ রেখায় সাফল্য](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/12/04/1764833540882_cdn_4-12-25.jpeg)

মন্তব্য (0)