Die Generalstaatsanwaltschaft von New Hampshire gab am Montag bekannt, dass sie mögliche Wählermanipulationen untersucht, nachdem Beschwerden über eine gefälschte Stimme eingegangen waren, die genau wie die von US-Präsident Joe Biden klang und die Wähler aufforderte, nicht an den Vorwahlen des Bundesstaates teilzunehmen.

Forscher warnten auch vor dem Einsatz von Deepfake-Audio, um Politiker und Führungskräfte zu imitieren. Prominente Fälle ereigneten sich 2023 in Großbritannien, Indien, Nigeria, Sudan, Äthiopien und der Slowakei.

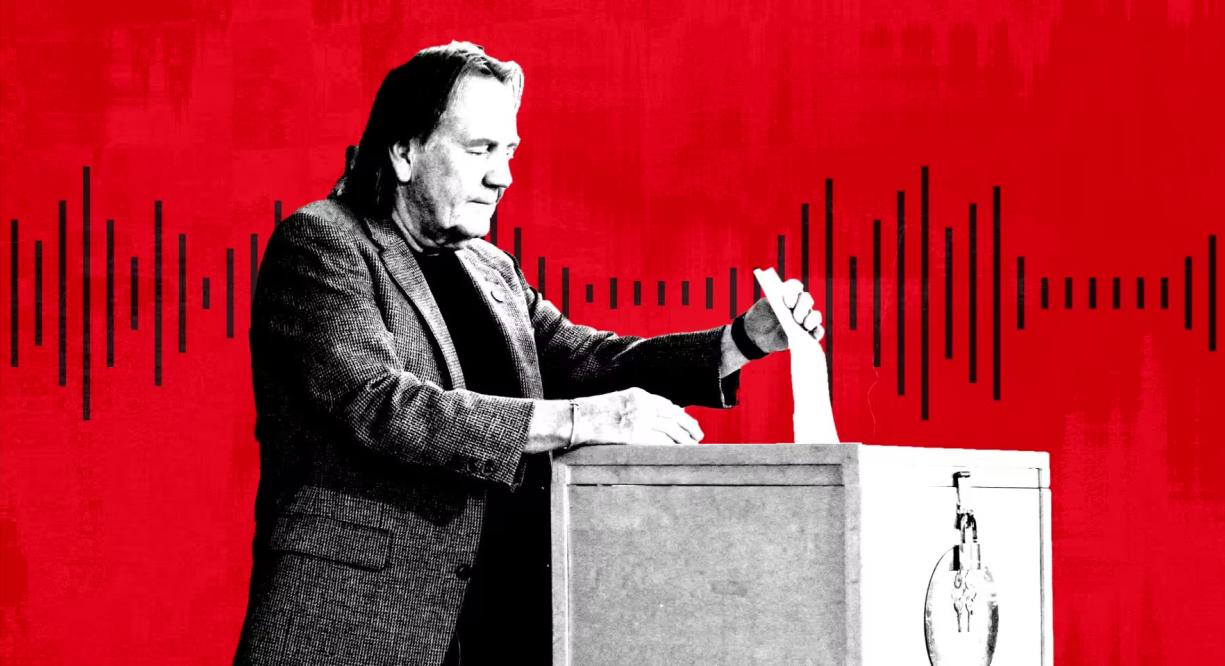

Eine Person gibt bei den Vorwahlen in New Hampshire, USA, ihre Stimme ab. Foto: Getty

Laut Experten hat sich Deepfake-Audio aufgrund einer Reihe kostengünstiger und effektiver KI-Tools von Startups zu einer beliebten Form der Desinformation entwickelt. Auch Microsoft hat ein neues KI-Modell entwickelt, das Stimmen anhand von nur drei Sekunden Aufnahmematerial kopieren kann.

„Wenn es um Bildmanipulation geht, kennt jeder Photoshop oder weiß zumindest, dass es existiert“, sagte Henry Ajder, KI- und Deepfake-Experte und Berater für Adobe, Meta und EY. „Es herrscht jedoch kaum Bewusstsein dafür, wie Audio manipuliert werden kann, und das macht uns meiner Meinung nach sehr angreifbar.“

Im September entdeckte NewsGuard, ein System zur Bewertung der Qualität und Vertrauenswürdigkeit von Nachrichtenseiten, ein Netzwerk von TikTok-Konten, die sich als seriöse Nachrichtenseiten ausgaben und mithilfe KI-generierter Inhalte Verschwörungstheorien und politische Falschinformationen verbreiteten. Deepfake-Aufnahmen, darunter die Stimme des ehemaligen US-Präsidenten Barack Obama, erzielten Hunderte Millionen Aufrufe.

Die gefälschten Sprachaufnahmen scheinen mit einem Tool des von Andreessen Horowitz unterstützten Unternehmens ElevenLabs erstellt worden zu sein, während die Clips Hunderte von Millionen Aufrufe erzielt haben, berichtete NewsGuard.

„Über 99 % der Nutzer unserer Plattform erstellen interessante, kreative und nützliche Inhalte. Wir sind uns jedoch bewusst, dass es Fälle von Missbrauch gibt und haben daher kontinuierlich Schutzmaßnahmen entwickelt und eingeführt, um diesen einzuschränken“, so ElevenLabs.

ElevenLabs, vor zwei Jahren von den ehemaligen Google- und Palantir-Mitarbeitern Piotr Dabkowski und Mati Staniszewski gegründet, bietet mit nur einem Klick kostenlose, einfache KI-gestützte Audiogenerierungstools an. Die Abonnements reichen von 1 US-Dollar pro Monat bis zu 330 US-Dollar pro Monat und mehr für Nutzer, die komplexere Funktionen benötigen.

Im vergangenen Jahr warnten US-Geheimdienste in einem Bericht, dass „personalisierte KI-Betrügereien aufgrund der Veröffentlichung hochentwickelter und gut trainierter KI-Stimmenklonmodelle deutlich zugenommen haben“.

Neben finanziell motivierten Betrugsmaschen warnen Politikexperten nun auch vor viralen Deepfake-Audioaufnahmen sowie deren Einsatz für automatisierte Anrufe oder Wahlkampagnen. „Durch gezieltes Angreifen auf Mobiltelefone lässt sich eine wirkungsvolle und weitreichende Desinformationskampagne aufbauen“, so AJ Nash, Vizepräsident und Experte für Cybersicherheit bei ZeroFox.

Einige dieser Unternehmen haben proaktiv nach alternativen Wegen gesucht, um Desinformation zu bekämpfen. Microsoft hat eine Ethikerklärung veröffentlicht und Nutzer darin aufgefordert, jeden Missbrauch seines KI-Audiotools zu melden. ElevenLabs hat eigene Erkennungstools entwickelt, um vom System erstellte Audioaufnahmen zu identifizieren.

Während der Wahlen in Nigeria im Jahr 2023 ging in den sozialen Medien ein KI-manipulierter Clip viral, der laut der Menschenrechtsorganisation Freedom House „den Eindruck erweckte, ein Oppositionskandidat plane, die Wahl zu manipulieren“.

In der Slowakei verbreitete sich wenige Tage vor der Präsidentschaftswahl im September eine gefälschte Tonaufnahme, in der Oppositionskandidat Michal Šimečka angeblich plante, die Wahl zu manipulieren.

„Der Deepfake-Vorfall in New Hampshire erinnert uns daran, wie vielfältig Deepfakes täuschen und betrügen können“, sagte Robert Weissman, Präsident der Verbraucherschutzorganisation Public Citizen. „Die politische Gefahr von Deepfakes ist nun gekommen. Die Politik muss dringend Schutzmaßnahmen ergreifen, sonst droht uns ein Wahlchaos.“

Mai Anh (laut FT)

Quelle

![[Foto] Parade zur Feier des 50. Jahrestages des Nationalfeiertags von Laos](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F02%2F1764691918289_ndo_br_0-jpg.webp&w=3840&q=75)

![[Foto] Verehrung der Tuyet-Son-Statue – ein fast 400 Jahre alter Schatz in der Keo-Pagode](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F02%2F1764679323086_ndo_br_tempimageomw0hi-4884-jpg.webp&w=3840&q=75)

Kommentar (0)