Ήρθε η ώρα κάθε χρήστης να γίνει μια «ψηφιακή ασπίδα», να είναι σε εγρήγορση, σε εγρήγορση και υπεύθυνος με κάθε κλικ και κοινοποίηση.

Τα οφέλη και η λεπτή γραμμή της Τεχνητής Νοημοσύνης

Ποτέ πριν η τεχνητή νοημοσύνη δεν ήταν τόσο κοντά στην καθημερινή ζωή. Με λίγα μόνο κλικ και μια σύντομη εντολή, μπορούμε να δημιουργήσουμε φωνές, εικόνες, ακόμη και βίντεο με εκπληκτικό ρεαλισμό. Η τεχνητή νοημοσύνη εξοικονομεί χρόνο, μειώνει το κόστος παραγωγής περιεχομένου και εγκαινιάζει μια εποχή ευέλικτων ψηφιακών μέσων.

Ωστόσο, αυτή η ίδια η ικανότητα «προσομοίωσης της πραγματικότητας με ρεαλιστικό τρόπο» έχει γίνει δίκοπο μαχαίρι. Πρόσφατα, τα μέσα κοινωνικής δικτύωσης έχουν κατακλυστεί από βίντεο που δημιουργήθηκαν με τεχνολογία deepfake, στα οποία τα πρόσωπα των ηγετών της αστυνομίας και οι εικόνες των αστυνομικών σε ευαίσθητες υποθέσεις χειραγωγούνται και παραμορφώνονται με φωνητικές εντολές για να παραπλανήσουν και να διχάσουν το κοινό.

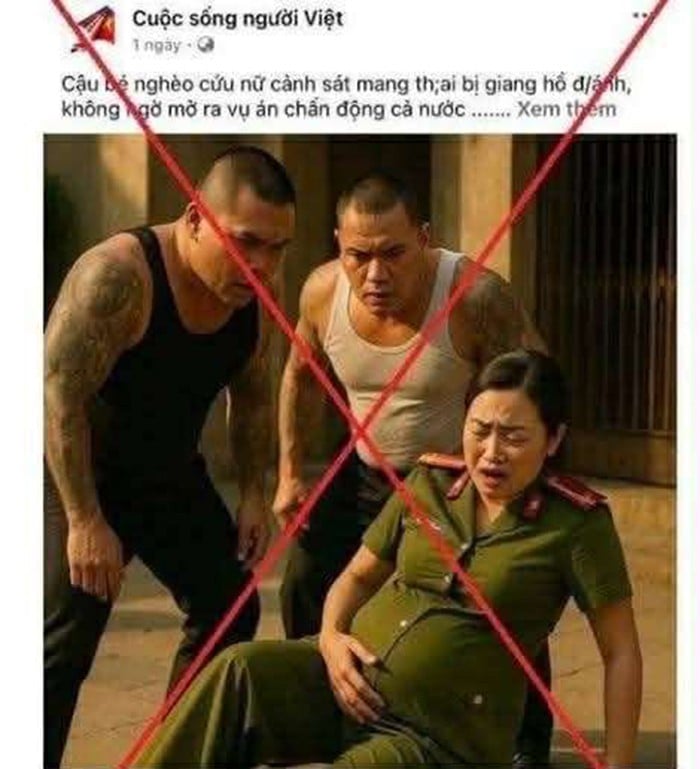

Στημένες εικόνες σαν κι αυτές γίνονται ολοένα και πιο συχνές στα μέσα κοινωνικής δικτύωσης.

Σε ένα viral βίντεο στο TikTok, εικόνες ενός αστυνομικού της τροχαίας εν ώρα υπηρεσίας αντιπαρατέθηκαν με προσβλητικό διάλογο, συνοδευόμενο από το hashtag «πρόστιμα μόνο για επίδειξη», υπονοώντας ότι ο αστυνομικός καταχράστηκε την εξουσία του για προσωπικό όφελος. Πολλοί χρήστες, ειδικά νέοι, πίστεψαν εύκολα αυτό το περιεχόμενο επειδή τα γραφικά ήταν τόσο ρεαλιστικά και η φωνή ταίριαζε πολύ με τις κινήσεις των χειλιών, καθιστώντας εξαιρετικά δύσκολη τη διάκριση μεταξύ του πραγματικού και του ψεύτικου.

Απλώς επειδή ήθελε να «επιδείξει» τις δεξιότητές του στην τεχνολογία τεχνητής νοημοσύνης, ένας νεαρός YouTuber στο Ντιέν Μπιέν πλήρωσε το τίμημα με διοικητικό πρόστιμο και μια αναγκαστική δημόσια συγγνώμη. Το απόγευμα της 24ης Ιανουαρίου, η επαρχιακή αστυνομία του Ντιέν Μπιέν ανακοίνωσε ότι το Τμήμα Κυβερνοασφάλειας και Πρόληψης Εγκλημάτων Υψηλής Τεχνολογίας επέβαλε διοικητικό πρόστιμο 7,5 εκατομμυρίων dong στον Tong Van T. (γεννημένος το 2001, κάτοικος της περιοχής Muong Ang) για χρήση τεχνητής νοημοσύνης για τη δημιουργία ενός κατασκευασμένου βίντεο που περιείχε παραμορφωμένο και προσβλητικό περιεχόμενο για τους τροχονόμους.

Συγκεκριμένα, στις 7 Ιανουαρίου, η Τ. ανέβασε ένα βίντεο διάρκειας άνω των 3 λεπτών στον λογαριασμό της στο YouTube "Tuyen Vlog" με τον σοκαριστικό τίτλο: "Ενώ ήμουν έξω, με κυνηγούσε η τροχαία". Στο κλιπ, οι εικόνες και οι καταστάσεις σκηνοθετήθηκαν με τεχνολογία τεχνητής νοημοσύνης, προσομοιώνοντας την τροχαία να κυνηγάει πολίτες, και συνδυάστηκαν με εφέ και σχόλια που ήταν προσβλητικά και δυσφημιστικά προς τις αρχές επιβολής του νόμου.

Σε συνεργασία με την αστυνομία, ο Τ. παραδέχτηκε ότι ολόκληρο το περιεχόμενο του βίντεο ήταν ένα κατασκευασμένο προϊόν που δημιουργήθηκε για «ψυχαγωγικούς» σκοπούς και για να αποδείξει την ικανότητά του να χρησιμοποιεί τεχνολογία τεχνητής νοημοσύνης. Εκτός από το πρόστιμο, οι αρχές διέταξαν τον Τ. να αφαιρέσει το ψευδές βίντεο και να ζητήσει δημόσια συγγνώμη από την τροχαία στο προσωπικό του κανάλι στο YouTube.

Στην εποχή της ψηφιακής επανάστασης , και ιδιαίτερα της ραγδαίας ανάπτυξης της τεχνητής νοημοσύνης, εχθρικές και αντιδραστικές δυνάμεις δεν δίστασαν να εκμεταλλευτούν αυτό το εργαλείο για να δημιουργήσουν κατασκευασμένες εικόνες και ιστορίες που στοχεύουν στη διαστρέβλωση και την αμαύρωση της εικόνας της Λαϊκής Αστυνομίας του Βιετνάμ. Μια φωτογραφία που κυκλοφόρησε πρόσφατα στα μέσα κοινωνικής δικτύωσης, η οποία δείχνει μια έγκυο γυναίκα με αστυνομική στολή να απειλείται από δύο άνδρες με εμφάνιση «γκάνγκστερ», αποτελεί σαφή απόδειξη αυτής της τακτικής.

Η εικόνα, που δημιουργήθηκε με τεχνητή νοημοσύνη, έχει γίνει πρόσφατα viral στα μέσα κοινωνικής δικτύωσης.

Με την πρώτη ματιά, οι θεατές μπορεί εύκολα να μπερδέψουν αυτή τη σκηνή με μια πραγματική σκηνή, συνοδευόμενη από εντυπωσιακούς τίτλους όπως: «Ένα καημένο αγόρι σώζει μια έγκυο αστυνομικό που δέχεται επίθεση από γκάνγκστερ, αποκαλύπτοντας εν αγνοία του μια υπόθεση που σοκάρει ολόκληρο το έθνος...». Ωστόσο, πρόκειται στην πραγματικότητα για μια σκηνοθετημένη σκηνή, πιθανώς από μια ταινία ή ένα ψυχαγωγικό προϊόν, ή, ακόμα χειρότερα, για μια εικόνα που δημιουργήθηκε από την Τεχνητή Νοημοσύνη για να εξαπατήσει τα συναισθήματα του αναγνώστη, οδηγώντας τον να νιώσει οίκτο και να αμφιβάλει για την αυθεντικότητα των αρχών επιβολής του νόμου.

Ακόμα πιο ανησυχητικό είναι ότι η διάδοση τέτοιου περιεχομένου όχι μόνο βλάπτει τη φήμη και την εικόνα της Λαϊκής Αστυνομίας, η οποία εργάζεται μέρα νύχτα για να προστατεύσει την ασφάλεια και την τάξη της κοινωνίας, αλλά αποτελεί επίσης μια εξελιγμένη μορφή ψυχολογικού πολέμου. Όταν η εμπιστοσύνη του λαού στις αρχές διαβρωθεί από παραπλανητικές εικόνες, τα απώτερα κίνητρα των εχθρικών δυνάμεων να διασπάσουν την εθνική ενότητα θα γίνουν σταδιακά πραγματικότητα.

Συνεπώς, κάθε πολίτης πρέπει να αυξήσει την επαγρύπνησή του, να αναπτύξει δεξιότητες κριτικής σκέψης και την ικανότητα να αναγνωρίζει ψευδείς πληροφορίες, καθώς και να καταγγέλλει και να αντικρούει αποφασιστικά το ψευδές περιεχόμενο, συμβάλλοντας στην προστασία του ιδεολογικού θεμελίου και στη διατήρηση της κοινωνικής σταθερότητας απέναντι στο τρέχον κύμα επιβλαβών πληροφοριών στο διαδίκτυο.

Στην πόλη Χο Τσι Μινχ, ένα βίντεο κλιπ διάρκειας σχεδόν ενός λεπτού έγινε απροσδόκητα viral στα μέσα κοινωνικής δικτύωσης, το οποίο έδειχνε ένα άτομο με αστυνομική στολή να «εξαναγκάζει» έναν ύποπτο να ομολογήσει μια παράβαση του Κώδικα Οδικής Κυκλοφορίας σε ένα γραφείο. Στο βίντεο, το άτομο που πιστεύεται ότι είναι αστυνομικός επιδεικνύει επιθετική στάση, φωνάζοντας συνεχώς και χρησιμοποιώντας ακόμη και αγενή γλώσσα, προκαλώντας δημόσια αγανάκτηση.

Ωστόσο, λίγο μετά τη διάδοση του βίντεο, η αστυνομία της πόλης Χο Τσι Μινχ διερεύνησε γρήγορα και επιβεβαίωσε ότι επρόκειτο για ένα εξελιγμένο deepfake. Σύμφωνα με τα ευρήματά τους, τα πρόσωπα στο βίντεο εξήχθησαν από μια ηχογράφηση μιας εσωτερικής αστυνομικής διάσκεψης και στη συνέχεια χειραγωγήθηκαν από κακόβουλα άτομα χρησιμοποιώντας τεχνολογία τεχνητής νοημοσύνης για να τα τοποθετήσουν σε μια σκηνοθετημένη σκηνή, οδηγώντας τους θεατές να πιστέψουν ότι επρόκειτο για ένα πραγματικό γεγονός.

Συγκεκριμένα, ο συνοδευτικός ήχος περιλαμβάνει απειλητικές και προσβλητικές φωνές που δεν είναι στην πραγματικότητα τα πραγματικά λόγια κανενός αξιωματούχου, αλλά μάλλον συνθετικές φωνές τεχνητής νοημοσύνης, προγραμματισμένες και επεξεργασμένες για να παραπλανούν τα συναισθήματα του θεατή.

Αυτό το περιστατικό αποτελεί χαρακτηριστικό παράδειγμα της χρήσης τεχνολογίας deepfake για τη διαστρέβλωση και δυσφήμιση της Λαϊκής Αστυνομίας, μια τακτική που αξιοποιείται ολοένα και περισσότερο από αντιδραστικές και ανατρεπτικές δυνάμεις στον κυβερνοχώρο. Είναι σημαντικό ότι, εάν δεν αποκαλυφθούν άμεσα, τέτοια ψεύτικα προϊόντα μπορούν να οδηγήσουν σε σοβαρές συνέπειες: υπονόμευση της εμπιστοσύνης του κοινού στις αρχές επιβολής του νόμου, υποκίνηση αντίστασης εντός της κοινότητας και διευκόλυνση της διάδοσης ψευδών αφηγημάτων. Αυτό χρησιμεύει ως σαφής προειδοποίηση για την επείγουσα ανάγκη ενίσχυσης των επικοινωνιακών δυνατοτήτων για την αντίκρουση, τον εντοπισμό και την καταπολέμηση των ψευδών ειδήσεων, και καλεί κάθε πολίτη να είναι σε εγρήγορση και να απέχει από την βιαστική κοινοποίηση ή σχολιασμό μη επαληθευμένου περιεχομένου από επίσημες πηγές.

Σε μια άλλη πρόσφατη υπόθεση, που αφορούσε τον χειρισμό παρατυπιών σε κέντρο τεχνικού ελέγχου οχημάτων στο Νότο, εχθρικά στοιχεία διέδωσαν ένα ψεύτικο βίντεο ενός αρχηγού της επαρχιακής αστυνομίας να μιλάει υπερασπιζόμενος τους διεφθαρμένους αξιωματούχους. Αυτό το κλιπ, που διαδόθηκε στο Telegram και στα μέσα κοινωνικής δικτύωσης με τον τίτλο «υποστηριζόμενο από ισχυρές δυνάμεις», ήταν στην πραγματικότητα προϊόν τεχνητής νοημοσύνης και δεν εμφανίστηκε σε καμία συνέντευξη Τύπου ή επίσημο έγγραφο.

Μια επικίνδυνη τάση εξαπλώνεται σιωπηλά στο διαδίκτυο: κακόβουλοι δράστες χρησιμοποιούν τεχνολογία τεχνητής νοημοσύνης για να δημιουργήσουν ψεύτικα βίντεο με σκοπό την απάτη και τον εκβιασμό. Πρόσφατα, πολλοί άνθρωποι έχουν πέσει θύματα όταν οι εικόνες τους, ειδικά αυτές των κοινωνικά σεβαστών ατόμων, όπως δικηγόροι, γιατροί και επιχειρηματίες, επικαλύπτονται από βίντεο που διαφημίζουν την «ανάκτηση χρημάτων που χάθηκαν σε διαδικτυακές απάτες».

Σε αυτά τα κλιπ, η Τεχνητή Νοημοσύνη χρησιμοποιείται για να μιμηθεί τη φωνή και το πρόσωπο δικηγόρων, κάνοντας τους θεατές να πιστέψουν τους απατεώνες και να τους παρέχουν εύκολα προσωπικές πληροφορίες ή να τους μεταφέρουν χρήματα. Ακόμα πιο επικίνδυνα, ορισμένοι δράστες χρησιμοποιούν τεχνολογία deepfake για να επικαλύψουν τα πρόσωπα των θυμάτων σε βίντεο σεξ και στη συνέχεια να τα στείλουν σε συζύγους ή συναδέλφους με σκοπό να τους απειλήσουν ή να τους εξαναγκάσουν να μεταφέρουν χρήματα για να «σιωπήσουν».

Ένα σοκαριστικό περιστατικό συνέβη τον Μάρτιο του 2025, όταν ένα θύμα στο Ανόι κλήθηκε να μεταφέρει δεκάδες εκατομμύρια ντονγκ αφού έλαβε ένα ψεύτικο σεξουαλικό βίντεο στο οποίο το παρουσίαζε. Εν τω μεταξύ, στην πόλη Χο Τσι Μινχ, ένα άλλο άτομο εκβιάστηκε για 2 δισεκατομμύρια ντονγκ αν δεν ήθελε να διαδοθεί το ευαίσθητο βίντεο. Το Υπουργείο Δημόσιας Ασφάλειας ξεκίνησε έρευνα, εντοπίζοντας αρκετές διεθνικές εγκληματικές ομάδες, κυρίως από την Κίνα και τη Νοτιοανατολική Ασία, πίσω από αυτά τα δίκτυα, χρησιμοποιώντας κάρτες SIM μιας χρήσης, ηλεκτρονικά πορτοφόλια και πλατφόρμες κοινωνικής δικτύωσης για να αποκρύψουν την ταυτότητά τους.

Δεν πρόκειται πλέον για μια μικροαπάτη, αλλά για μια μορφή «ψυχολογικού πολέμου υψηλής τεχνολογίας», που εκμεταλλεύεται σε μεγάλο βαθμό τους φόβους για την τιμή και τις κοινωνικές σχέσεις για να ασκήσει πίεση στα θύματα. Χωρίς αυξημένη επαγρύπνηση και δεξιότητες στον εντοπισμό ασυνήθιστων πληροφοριών και συμπεριφορών, ο καθένας μπορεί να γίνει θύμα αυτών των εγκληματιών υψηλής τεχνολογίας. Ενόψει αυτού του εξελιγμένου κύματος πλαστοπροσωπίας, κάθε πολίτης πρέπει να είναι σε εγρήγορση, να απέχει απολύτως από την αδιακρίτως κοινοποίηση προσωπικών πληροφοριών και να είναι έτοιμος να μιλήσει κατά των παράνομων δραστηριοτήτων, συμβάλλοντας στην προστασία της δικής του ασφάλειας και της κοινότητας.

Απαιτείται μια «ψηφιακή ασπίδα» από την κοινότητα για την καταπολέμηση της απειλής των deepfakes.

Σύμφωνα με το Υπουργείο Ραδιοτηλεόρασης, Τηλεόρασης και Ηλεκτρονικών Πληροφοριών (Υπουργείο Πολιτισμού, Αθλητισμού και Τουρισμού), το 2024, οι ψηφιακές πλατφόρμες στο Βιετνάμ έπρεπε να αφαιρέσουν περισσότερα από 4.000 βίντεο που περιείχαν ψευδείς και παραμορφωμένες πληροφορίες, η πλειονότητα των οποίων ήταν προϊόντα που δημιουργήθηκαν με τεχνολογία τεχνητής νοημοσύνης, όπως deepfakes και κλώνοι φωνής. Μόνο το TikTok - μια πλατφόρμα δημοφιλής στους νέους - κλήθηκε να διαγράψει περισσότερα από 1.300 κλιπ deepfake, που σχετίζονταν κυρίως με την αστυνομική δύναμη, την κυβέρνηση και τις κοινωνικές πολιτικές.

Στην εποχή της τεχνολογικής άνθησης, η τεχνητή νοημοσύνη ξεκλειδώνει πρωτοποριακές δυνατότητες, αλλά φέρνει επίσης πρωτοφανείς κινδύνους, ειδικά προϊόντα deepfake που περιέχουν παραμορφωμένο περιεχόμενο που προσβάλλει τη φήμη των κυβερνητικών υπηρεσιών. Μια έρευνα του Ινστιτούτου Έρευνας Μέσων MICRI δείχνει ότι το 62% των χρηστών των μέσων κοινωνικής δικτύωσης στο Βιετνάμ δεν μπορεί να διακρίνει μεταξύ πραγματικών και ψεύτικων πληροφοριών χωρίς προειδοποιήσεις από τα κυρίαρχα μέσα ενημέρωσης ή τις αρχές. Αυτό είναι ένα «γνωστικό κενό» που κακόβουλες δυνάμεις εκμεταλλεύονται πλήρως για να διαδώσουν παραπληροφόρηση και να διαταράξουν την κοινωνική ψυχολογία.

Ο Τονγκ Βαν Τ. στο αστυνομικό τμήμα.

Σύμφωνα με τον Υποστράτηγο, Αναπληρωτή Καθηγητή και Δρ. Do Canh Thin, ειδικό στην εγκληματολογία, η χρήση τεχνητής νοημοσύνης για τη δημιουργία ψεύτικων βίντεο που μιμούνται ηγέτες, επεξεργάζονται ψευδείς δηλώσεις ή διαστρεβλώνουν τις επαγγελματικές ενέργειες της αστυνομικής δύναμης είναι μια νέα αλλά ιδιαίτερα επικίνδυνη τακτική. «Το Deepfake δεν είναι απλώς ένα προϊόν ψυχαγωγίας, αλλά μια μορφή σύγχρονου πληροφοριακού πολέμου, ικανό να υπονομεύσει την εμπιστοσύνη, να προκαλέσει κοινωνική αστάθεια και είναι πολύ δύσκολο να ελεγχθεί», δήλωσε ο Υποστράτηγος Do Canh Thin.

Στην πραγματικότητα, τα βίντεο που χειραγωγούνται από την Τεχνητή Νοημοσύνη δεν είναι καθόλου ακίνδυνα. Συχνά στοχεύουν σε ευαίσθητα θέματα, όπως η αντιμετώπιση παραβάσεων, η διερεύνηση εγκλημάτων και η καταπολέμηση της διαφθοράς, προκαλώντας δημόσια σύγχυση και δυσπιστία στις αρχές επιβολής του νόμου. Ακόμα πιο ανησυχητικό είναι ότι πολλά βίντεο κοινοποιούνται σε μεγάλες πλατφόρμες όπως το YouTube και το TikTok, συγκεντρώνοντας εκατοντάδες χιλιάδες προβολές πριν αφαιρεθούν, δημιουργώντας ένα αρνητικό κυματιστικό αποτέλεσμα.

Ο ειδικός στα ψηφιακά μέσα, Χοάνγκ Μινχ, προειδοποιεί: «Μόνο ένα απρόσεκτο share ή like μπορεί να σας μετατρέψει σε συνεργό σε ψευδείς ειδήσεις. Κάθε χρήστης του διαδικτύου πρέπει να καταλάβει ότι οι ενέργειες στον ψηφιακό χώρο έχουν και πραγματικές συνέπειες».

Σε αυτό το πλαίσιο, αυτό που χρειάζεται περισσότερο από ποτέ είναι η οικοδόμηση μιας «ψηφιακής ασπίδας» μέσα από την ίδια την κοινότητα: δηλαδή, επαγρύπνηση, ανοσία στην πληροφορία και αίσθημα ευθύνης απέναντι στο διαδικτυακό περιβάλλον. Η τεχνολογία μπορεί να είναι ουδέτερη, αλλά ο τρόπος με τον οποίο οι άνθρωποι τη χρησιμοποιούν θα καθορίσει εάν η Τεχνητή Νοημοσύνη θα γίνει κινητήρια δύναμη για την ανάπτυξη ή μια καταστροφική δύναμη κατά της κοινωνικής εμπιστοσύνης. Η διατήρηση της ιδεολογικής σταθερότητας και η προστασία της εικόνας του αστυνομικού προστατεύουν τα θεμέλια της εθνικής ασφάλειας - ένα καθήκον όχι μόνο για τις αρμόδιες αρχές αλλά και για κάθε πολίτη στην ψηφιακή εποχή.

Πηγή: https://baolangson.vn/tinh-hai-mat-cua-ai-5050403.html

![[Φωτογραφία] Το μέλος της Μόνιμης Επιτροπής της Κεντρικής Επιτροπής του Κόμματος, Tran Cam Tu, παρουσιάζει την Απόφαση διορισμού του Γραμματέα της Κομματικής Επιτροπής της Εθνικής Ακαδημίας Πολιτικής του Χο Τσι Μινχ.](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2026%2F02%2F02%2F1770039902160_le-cong-bo-bt-hvctqg-11-7880-jpg.webp&w=3840&q=75)

![OCOP κατά την περίοδο Tet: [Μέρος 3] Το εξαιρετικά λεπτό χαρτί ρυζιού απογειώνεται.](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F402x226%2Fvietnam%2Fresource%2FIMAGE%2F2026%2F01%2F28%2F1769562783429_004-194121_651-081010.jpeg&w=3840&q=75)

Σχόλιο (0)