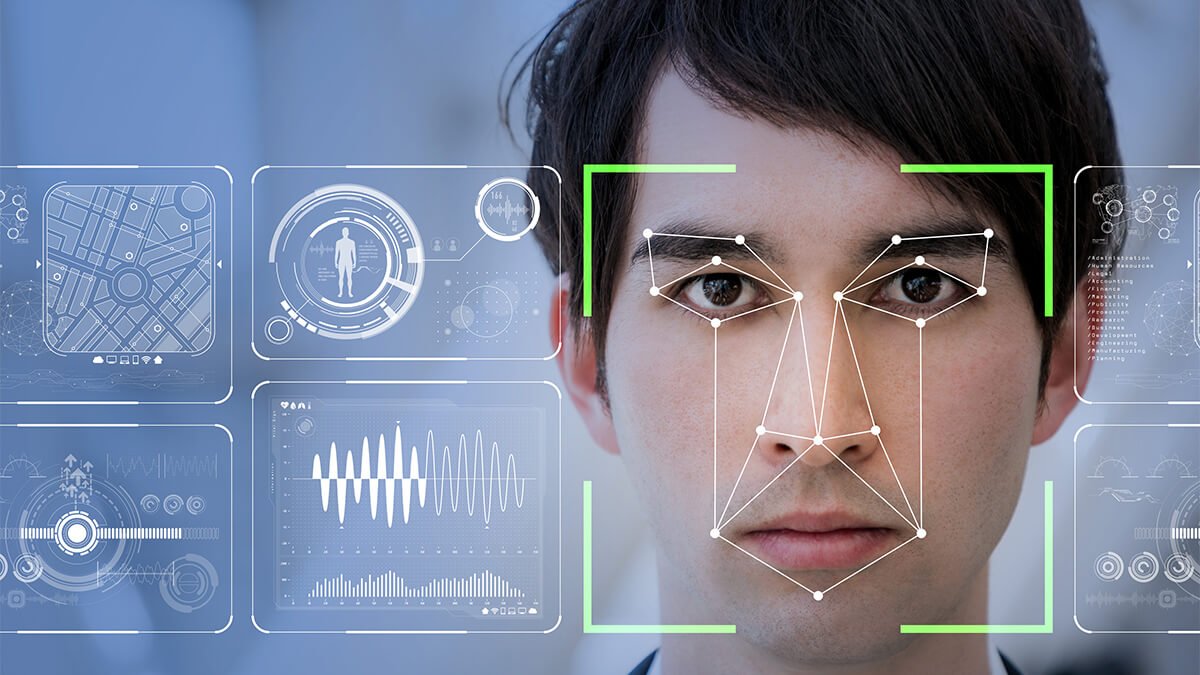

A medida que los avances tecnológicos continúan dando forma a las redes sociales y los medios de comunicación masivos, las falsificaciones profundas se están convirtiendo en una preocupación importante a medida que el número de estafas de falsificaciones profundas continúa aumentando.

Los deepfakes pueden usarse con malos fines

Después de investigar foros de la darknet, donde suelen operar los cibercriminales, Kaspersky determinó que hay muchos delincuentes que utilizan deepfakes para cometer fraudes, hasta el punto de que la demanda supera con creces la oferta de software deepfake actualmente en el mercado.

A medida que la demanda supera la oferta, los expertos de Kaspersky predicen que las estafas deepfake aumentarán en variedad y sofisticación, desde ofrecer un video de suplantación de identidad de alta calidad con servicios de producción completos hasta usar imágenes de celebridades en transmisiones en vivo falsas en las redes sociales y prometer duplicar la cantidad que la víctima les envió.

Los deepfakes se han convertido en una pesadilla para las mujeres y la sociedad. Los ciberdelincuentes ahora explotan la inteligencia artificial (IA) para insertar los rostros de las víctimas en fotos y vídeos pornográficos, así como en campañas de propaganda. Estos formatos buscan manipular la opinión pública difundiendo información falsa o incluso dañando la reputación de organizaciones o personas. Hacemos un llamamiento a la ciudadanía para que esté más alerta ante esta amenaza», declaró la Sra. Vo Duong Tu Diem, directora nacional de Kaspersky Vietnam.

Según Regula, un sistema de referencia de información, hasta el 37 % de las empresas a nivel mundial se han visto afectadas por estafas de deepfakes de voz y el 29 % han sido víctimas de vídeos deepfakes. Los deepfakes se han convertido en una amenaza para la ciberseguridad en Vietnam, donde los ciberdelincuentes suelen utilizar videollamadas deepfakes para hacerse pasar por una persona y pedir prestado grandes sumas de dinero a sus familiares y amigos para casos urgentes. Además, una videollamada deepfake puede realizarse en tan solo un minuto, lo que dificulta que las víctimas distingan entre llamadas reales y falsas.

Si bien los delincuentes están abusando de la IA con fines maliciosos, las personas y las empresas aún pueden aprovecharla para identificar deepfakes y reducir la probabilidad de que las estafas tengan éxito.

Kaspersky comparte soluciones para que los usuarios se protejan de las estafas deepfake:

Herramientas de detección de contenido con IA : El software de detección de contenido generado por IA utiliza algoritmos avanzados de IA para analizar y determinar el grado de manipulación de archivos de imagen, vídeo y audio. En el caso de los vídeos deepfake, algunas herramientas ayudan a identificar movimientos bucales y habla discordantes. Otras herramientas detectan el flujo sanguíneo anormal bajo la piel analizando la resolución del vídeo, ya que, cuando el corazón bombea sangre, las venas humanas cambian de color.

Contenido de IA con marca de agua : Las marcas de agua funcionan como marcas de identificación en imágenes, vídeos, etc., para ayudar a los autores a proteger los derechos de autor de sus obras de IA. Sin embargo, esta herramienta puede convertirse en un arma contra los deepfakes, ya que permite rastrear el origen de la plataforma que creó la IA.

Procedencia del contenido : dado que la IA recopila grandes cantidades de datos de diversas fuentes para crear contenido nuevo, este enfoque apunta a rastrear el origen de ese contenido.

Autenticación de video : es el proceso que verifica que el contenido del video no haya sido alterado desde su creación. Este es el proceso que más preocupa a los creadores de videos. Algunas tecnologías emergentes utilizan algoritmos criptográficos para insertar valores hash en el video a intervalos establecidos. Si el video ha sido editado, el valor hash cambiará.

[anuncio_2]

Enlace de origen

Kommentar (0)