ट्रूपिक के सीईओ जेफरी मैकग्रेगर का मानना है कि यह घटना तो बस शुरुआत है। उनका कहना है कि सोशल मीडिया पर एआई द्वारा निर्मित और भी सामग्री सामने आएगी, और हम अभी इसके लिए तैयार नहीं हैं।

सीएनएन के अनुसार, ट्रूपिक का उद्देश्य ट्रूपिक लेंस के माध्यम से मीडिया की प्रामाणिकता को निर्माण के समय ही सत्यापित करने वाली तकनीक प्रदान करके इस समस्या का समाधान करना है। डेटा एकत्र करने वाला यह एप्लिकेशन उपयोगकर्ताओं को छवि बनाने की तिथि, समय, स्थान और उपयोग किए गए उपकरण की जानकारी देगा, और यह सत्यापित करने के लिए एक डिजिटल हस्ताक्षर लागू करेगा कि छवि प्राकृतिक है या एआई द्वारा निर्मित।

पेंटागन में हुए विस्फोट की एक फर्जी तस्वीर ट्विटर पर वायरल हो गई है।

माइक्रोसॉफ्ट समर्थित कंपनी ट्रूपिक, जिसकी स्थापना 2015 में हुई थी, को गैर-सरकारी संगठनों और मीडिया कंपनियों के साथ-साथ बीमा कंपनियों से भी रुचि मिल रही है, जो दावों को वैध साबित करने के तरीके ढूंढ रही हैं।

मैकग्रेगर ने कहा कि जब हर चीज को नकली बनाया जा सकता है, जब कृत्रिम बुद्धिमत्ता गुणवत्ता और पहुंच के मामले में अपने चरम पर पहुंच गई है, तो ऑनलाइन होने पर हमें यह नहीं पता होता कि वास्तविकता क्या है।

ट्रूपिक जैसी तकनीकी कंपनियां वर्षों से ऑनलाइन गलत सूचनाओं से निपटने के लिए काम कर रही हैं। लेकिन उपयोगकर्ता के आदेश पर चित्र और लिखित सामग्री तैयार करने में सक्षम कई नए एआई उपकरणों के उदय ने इस मामले में और भी गंभीरता ला दी है। इस साल की शुरुआत में, पोप फ्रांसिस की बैलेन्सियागा लाइफ जैकेट पहने हुए और पूर्व अमेरिकी राष्ट्रपति डोनाल्ड ट्रम्प की गिरफ्तारी की फर्जी तस्वीरें बड़े पैमाने पर साझा की गईं। इन दोनों घटनाओं ने लाखों लोगों को एआई के संभावित खतरों के बारे में चिंतित कर दिया।

कुछ सांसद अब प्रौद्योगिकी कंपनियों से कृत्रिम बुद्धिमत्ता से निर्मित सामग्री को लेबल करके इस मुद्दे को संबोधित करने का आह्वान कर रहे हैं। यूरोपीय आयोग की उपाध्यक्ष वेरा जौरोवा ने कहा कि गूगल, मेटा, माइक्रोसॉफ्ट और टिकटॉक सहित कई कंपनियों ने गलत सूचना से निपटने के लिए यूरोपीय संघ की स्वैच्छिक आचार संहिता में शामिल हो गई हैं।

स्टार्टअप और तकनीकी दिग्गज कंपनियां, जिनमें से कुछ अपने उत्पादों में एआई जनरेशन को लागू कर रही हैं, तेजी से ऐसे मानक और समाधान तैनात करने की कोशिश कर रही हैं जो लोगों को यह निर्धारित करने में मदद करें कि कोई छवि या वीडियो एआई का उपयोग करके बनाया गया था या नहीं।

लेकिन जैसे-जैसे एआई तकनीक मनुष्यों की तुलना में तेज़ी से आगे बढ़ रही है, यह स्पष्ट नहीं है कि ये समाधान समस्या का पूरी तरह से हल कर पाएंगे या नहीं। यहां तक कि Dal-E और ChatGPT बनाने वाली कंपनी OpenAI ने भी स्वीकार किया है कि एआई द्वारा उत्पन्न लेखन का पता लगाने के उसके अपने प्रयास अपूर्ण हैं।

समस्या के समाधान विकसित करने वाली कंपनियां इस समस्या से निपटने के लिए दो दृष्टिकोण अपना रही हैं। पहला दृष्टिकोण ऑनलाइन साझा किए जाने के बाद कृत्रिम बुद्धिमत्ता से निर्मित छवियों की पहचान करने के लिए प्रोग्राम विकसित करने पर आधारित है। दूसरा दृष्टिकोण किसी प्रकार के डिजिटल हस्ताक्षर का उपयोग करके छवि को वास्तविक या कृत्रिम रूप से निर्मित के रूप में चिह्नित करने पर केंद्रित है।

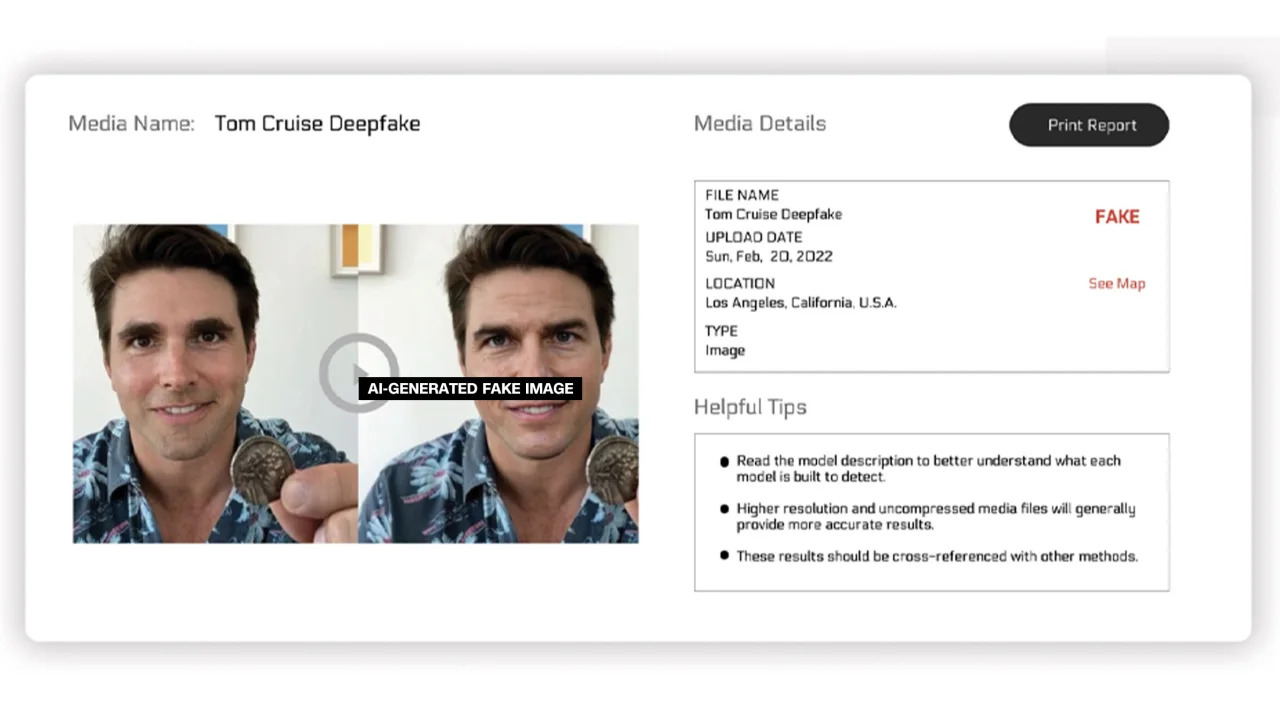

रियलिटी डिफेंडर और हाइव मॉडरेशन पहले दृष्टिकोण पर शोध कर रहे हैं। उनके प्लेटफॉर्म के माध्यम से, उपयोगकर्ता स्कैनिंग के लिए छवियां अपलोड कर सकते हैं और फिर एक विश्लेषण प्राप्त कर सकते हैं जो यह दर्शाता है कि छवि वास्तविक है या एआई द्वारा निर्मित है।

रियलिटी डिफेंडर का कहना है कि कंपनी कृत्रिम बुद्धिमत्ता से निर्मित वीडियो, ऑडियो और छवियों का पता लगाने के लिए अपनी विशेष कंटेंट फिंगरप्रिंटिंग और डीपफेक तकनीक का उपयोग करती है। कंपनी द्वारा दिए गए एक उदाहरण में, रियलिटी डिफेंडर ने टॉम क्रूज़ की एक डीपफेक छवि दिखाई है, जिसे 53% "संदिग्ध" रेटिंग मिली है क्योंकि छवि में व्यक्ति का चेहरा विकृत है, जो छेड़छाड़ की गई तस्वीरों में आम बात है।

कृत्रिम बुद्धिमत्ता द्वारा उत्पन्न टैग से चिह्नित छवियां।

ये सेवाएं मुफ्त और सशुल्क दोनों विकल्प प्रदान करती हैं। Hive Moderation का कहना है कि वह प्रति 1,000 छवियों के लिए 1.50 डॉलर का शुल्क लेती है। Realty Defender का कहना है कि उसकी कीमत कई कारकों पर निर्भर करती है, जिसमें यह भी शामिल है कि ग्राहक को विशेषज्ञता और कंपनी के समर्थन की आवश्यकता है या नहीं। Reality Defender के सीईओ बेन कोलमैन का कहना है कि जोखिम हर महीने दोगुना हो रहा है क्योंकि कोई भी AI उपकरणों का उपयोग करके नकली छवियां बना सकता है।

कई अन्य कंपनियां छवियों में एक प्रकार का स्टिकर लगाने पर काम कर रही हैं ताकि यह प्रमाणित किया जा सके कि वे वास्तविक हैं या कृत्रिम बुद्धिमत्ता से बनाई गई हैं। अब तक, इस प्रयास को मुख्य रूप से प्रामाणिकता और सामग्री स्रोत गठबंधन (C2PA) द्वारा संचालित किया गया है।

डिजिटल मीडिया के स्रोत और इतिहास को प्रमाणित करने के लिए एक तकनीकी मानक बनाने हेतु C2PA की स्थापना 2021 में की गई थी। इसमें एडोब की कंटेंट ऑथेंटिसिटी इनिशिएटिव (CAI) और माइक्रोसॉफ्ट एवं बीबीसी के नेतृत्व में प्रोजेक्ट ओरिजिन को मिलाकर डिजिटल समाचारों में गलत सूचनाओं से निपटने पर ध्यान केंद्रित किया गया है। C2PA में भाग लेने वाली अन्य कंपनियों में ट्रू पिक, इंटेल और सोनी शामिल हैं।

C2PA के सिद्धांतों पर आधारित, CAI कंपनियों को छवियों के बारे में जानकारी रखने वाले कंटेंट क्रेडेंशियल या मेटाडेटा बनाने के लिए ओपन-सोर्स टूल उपलब्ध कराएगा। CAI की वेबसाइट के अनुसार, इससे रचनाकारों को यह पारदर्शी रूप से साझा करने की सुविधा मिलती है कि उन्होंने छवि कैसे बनाई। इस तरह, अंतिम उपयोगकर्ता यह जान सकते हैं कि छवि को किसने, किस उद्देश्य से और कैसे रूपांतरित किया है - और फिर वे स्वयं उस छवि की प्रामाणिकता का आकलन कर सकते हैं।

कई कंपनियों ने C2PA मानक और CAI टूल्स को अपने एप्लिकेशन में एकीकृत कर लिया है। एडोब का फायरफ्लाई—फोटोशॉप में जोड़ा गया एक नया AI इमेज क्रिएशन टूल—अपने कंटेंट क्रेडेंशियल्स फीचर के माध्यम से C2PA मानक का अनुपालन करता है। माइक्रोसॉफ्ट ने यह भी घोषणा की है कि बिंग इमेज क्रिएटर और माइक्रोसॉफ्ट डिज़ाइनर का उपयोग करके बनाई गई छवियों और वीडियो में आने वाले महीनों में एन्क्रिप्टेड हस्ताक्षर होंगे।

मई में, Google ने "इस छवि के बारे में" सुविधा की घोषणा की, जिससे उपयोगकर्ता यह देख सकते हैं कि कोई छवि Google पर पहली बार कब दिखाई दी और वह कहाँ-कहाँ दिखाई दे सकती है। सर्च इंजन कंपनी ने यह भी घोषणा की कि Google की सभी AI-जनरेटेड छवियों की मूल फ़ाइल में एक मार्कअप होगा, ताकि यदि छवि किसी अन्य वेबसाइट या प्लेटफ़ॉर्म पर पाई जाती है, तो उसे "संदर्भित" किया जा सके।

तकनीकी कंपनियां कृत्रिम बुद्धिमत्ता से उत्पन्न छवियों और डिजिटल मीडिया की विश्वसनीयता से संबंधित चिंताओं को दूर करने का प्रयास कर रही हैं, वहीं इस क्षेत्र के विशेषज्ञ इस बात पर जोर देते हैं कि इस समस्या के समाधान के लिए व्यवसायों को आपस में और सरकारों के साथ सहयोग करना होगा। इसके बावजूद, तकनीकी कंपनियां जोखिमों के बावजूद कृत्रिम बुद्धिमत्ता विकसित करने की होड़ में लगी हुई हैं।

[विज्ञापन_2]

स्रोत लिंक

![[फोटो] प्रधानमंत्री फाम मिन्ह चिन्ह निजी क्षेत्र के आर्थिक विकास पर एक बैठक की अध्यक्षता कर रहे हैं।](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F20%2F1766237501876_thiet-ke-chua-co-ten-40-png.webp&w=3840&q=75)

टिप्पणी (0)