Android Authorityによると、Appleの研究論文には、RAM容量が限られたデバイスで大規模言語モデル(LLM)を実行するためのソリューションが詳述されている。論文では、モデル全体をRAMにロードするのではなく、「モデルパラメータ」を保存し、必要に応じてその一部をデバイスのRAMにロードする方法が明らかにされている。

AppleはRAMが少ない古いiPhoneでも汎用AIを実行できるようにしようとしている

論文では、この方法により、iPhone の 2 倍の RAM を必要とするモデルを実行できると同時に、CPU と GPU での単純なロード方法と比較してそれぞれ 4 ~ 5 倍と 20 ~ 25 倍の推論速度が保証されると主張しています。

より多くのRAMを搭載したデバイスに合成AIを導入すれば、読み書き速度が高速化するため、大きなメリットが得られます。デバイス内AIにとって速度は重要であり、ユーザーが応答や最終結果を得るまで数十秒(あるいはそれ以上)待つ必要がなくなるため、推論時間が大幅に短縮されます。つまり、デバイス内AIアシスタントは会話並みの速度で動作し、画像やテキストの生成速度を大幅に向上させ、記事の要約も高速化できる可能性があるということです。しかし、Appleのソリューションは、デバイス内AIタスクの応答速度を向上させるために、ユーザーが必ずしも大量のRAMを必要としないことを意味します。

Appleのアプローチにより、新旧のiPhoneはいずれも、デバイス上で合成AI機能を提供できるようになる可能性があります。これは重要な点です。なぜなら、AppleのiPhoneは一般的にハイエンドのAndroidスマートフォンよりもRAMが少ないからです。例えば、iPhone 11シリーズはRAMが4GBしかなく、通常のiPhone 15でさえ6GBしかありません。

LLMの小型化に取り組んでいるモバイル企業はAppleだけではありません。QualcommとMediaTekの最近の主力チップはどちらも、これらのモデルを小型化するためにINT4精度をサポートしています。いずれにせよ、各社はデバイス内AIのシステム要件を削減し、低価格帯のスマートフォンでもこの機能を提供できるようにするための新たな方法を模索しています。

[広告2]

ソースリンク

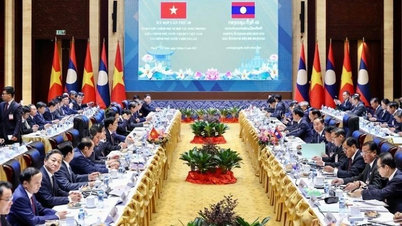

![[写真] ラオス建国記念日50周年を祝うパレード](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F02%2F1764691918289_ndo_br_0-jpg.webp&w=3840&q=75)

コメント (0)