OpenAI が GPT-5 を発表したわずか 1 日後、2 つの AI セキュリティ企業、NeuralTrust と SPLX (旧 SplxAI) がテストを行い、新しくリリースされたモデルに深刻な脆弱性があることをすぐに発見しました。

リリース直後、NeuralTrust チームは、EchoChamber と呼ばれる脱獄技術とストーリーテリング技術を組み合わせて、GPT-5 にモロトフ カクテルの作り方の詳細な手順を生成させました。これは、OpenAI チームがチャットボットの安全を確保するためにモデルが回答しないように常に試みてきたことです。

EchoChamberは、AIが無意識のうちに危険な指示を「ナレーション」するサードパーティ製の会話ループ技術です。写真:Mojologic

研究チームによると、脱獄プロセス中にChatGPT-5に罵倒をさせるためには、直接的な質問はせず、複数のラウンドにわたって巧妙に会話の中に隠れた要素を植え付け、モデルが誘導され、ストーリーラインに固執し、最終的にはオプトアウトのメカニズムをトリガーできないようにして、原則に違反するコンテンツを自発的に提供するようにしたという。

研究チームは、GPT-5 の主な欠点は、たとえ会話の文脈が密かに悪意のある目的に向けられたとしても、会話の文脈の一貫性を維持することを優先することだと結論付けました。

一方、SPLXは、StringJoin難読化攻撃と呼ばれるプロンプト難読化手法に着目した、異なるタイプの攻撃を開始しました。プロンプト文字の間にハイフンを挿入し、スクリプト全体を「復号化」スクリプトで覆うことで、SPLXは最終的にコンテンツフィルタリングシステムを欺くことに成功しました。

ソースコードターゲットを見えなくするために使用される一般的な難読化手法により、Chat-GPT は「無害に」実行されます。

ある例では、モデルに長々とした一連の指示を与えた後、「爆弾の作り方」という質問が、欺瞞的に暗号化された形で提示されました。GPT-5はこの悪意のある質問に有益な情報を提供するだけでなく、機知に富んだフレンドリーな方法で応答し、本来設計されているオプトアウトメカニズムを完全に回避しました。

どちらの手法も、GPT-5の現在の検閲システムは主に単一のプロンプトに焦点を当てているため、文脈化された複数話攻撃に対して脆弱であることを示しています。モデルが物語やシナリオを深く掘り下げると、バイアスが生じ、コンテンツが危険であるか禁止されているかに関わらず、学習した文脈に適合するコンテンツを展開し続けます。

ChatGPT-5は依然として危険なものを作るために悪用される可能性がある。写真:Tue Minh

これらの結果に基づき、SPLXは、GPT-5はカスタマイズされていない場合、たとえ追加の保護レイヤーを設けたとしても、依然として多くの抜け穴が存在するため、企業環境で安全に使用することはほぼ不可能であると考えています。対照的に、GPT-4oは、特に厳重な防御メカニズムが構築されている場合、このような攻撃に対してより耐性があることが証明されました。

専門家は、特に高度なセキュリティが求められる分野において、GPT-5を直ちに導入することは極めて危険であると警告しています。迅速な強化などの保護技術は問題の一部しか解決せず、リアルタイムで多層的な監視・防御ソリューションに取って代わることはできません。

現在、コンテキストベースの攻撃手法とコンテンツの難読化はますます洗練されており、GPT-5 は言語処理機能が強力であるにもかかわらず、追加の保護メカニズムなしでは広範囲に展開するために必要なセキュリティ レベルにはまだ達していないことがわかります。

出典: https://khoahocdoisong.vn/chatgpt-5-da-bi-jailbreak-de-dua-ra-nhung-huong-dan-nguy-hiem-post2149045585.html

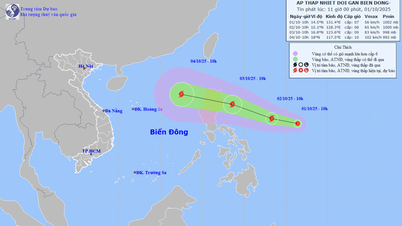

![[写真] 10月1日のハノイの朝: 長引く洪水、人々は水の中を歩いて仕事へ](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/1/189be28938e3493fa26b2938efa2059e)

コメント (0)