តាមពិតទៅ នេះមិនមែនជាលើកទីមួយទេ ដែលអ្នកវិទ្យាសាស្ត្របានព្រមានអំពីការរំពឹងទុកថា បញ្ញាសិប្បនិមិត្តក្លាយជាគ្រោះថ្នាក់ដល់មនុស្ស។ ក្នុងឆ្នាំ 2014 រូបវិទូទ្រឹស្តីដ៏ល្បីល្បាញរបស់ចក្រភពអង់គ្លេស Stephen Hawking បាននិយាយថា "ការអភិវឌ្ឍន៍ដ៏ទូលំទូលាយនៃបញ្ញាសិប្បនិម្មិតអាចបំផ្លាញមនុស្សជាតិ" ។ គាត់ក៏បាននិយាយផងដែរថា មនុស្សនឹងត្រូវបានជំនួសទាំងស្រុងដោយបញ្ញាសិប្បនិមិត្តក្នុងរយៈពេល 500 ឆ្នាំខាងមុខ ប្រសិនបើពួកគេមិនប្រុងប្រយ័ត្នក្នុងដំណើរការស្រាវជ្រាវ និងអភិវឌ្ឍបច្ចេកវិទ្យាដ៏គ្រោះថ្នាក់នេះ។ កាលពីប្រាំបីឆ្នាំមុន ក្នុងខែកក្កដា ឆ្នាំ 2015 អ្នកជំនាញជាង 1,000 នាក់នៅក្នុងបច្ចេកវិទ្យាបញ្ញាសិប្បនិមិត្ត រួមទាំង Stephen Hawking, Elon Musk, Noam Chomsky... បានចុះហត្ថលេខាលើញត្តិព្រមានអំពីហានិភ័យនៃការប្រណាំងអាវុធក្នុងវិស័យ យោធា AI និងអំពាវនាវឱ្យមានការហាមឃាត់យ៉ាងទូលំទូលាយលើអាវុធស្វយ័ត។ ការបើកដំណើរការ Chat GPT របស់ OpenAI ក្នុងខែវិច្ឆិកា ឆ្នាំ 2022 បានបន្ថែមកណ្តឹងព្រមានមួយទៀតចំពោះគ្រោះថ្នាក់ដែលមានស្រាប់នៃបញ្ញាសិប្បនិម្មិត។ តាមពិតទៅ អ្វីដែល Chat GPT កំពុងធ្វើបង្ហាញថា AI គឺមានគ្រោះថ្នាក់ជាងមនុស្សធ្លាប់គិតទៅទៀត។

ហានិភ័យដែលអាចកើតមាននៃបញ្ញាសិប្បនិមិត្តអាស្រ័យលើរបៀបដែលវាត្រូវបានប្រើ។ AI ត្រូវបានបង្កើតឡើងដំបូងដើម្បីជួយមនុស្សក្នុងការងាររបស់ពួកគេ ជាពិសេសជាមួយនឹងកិច្ចការដែលគួរឱ្យធុញ និងច្រំដែលដូចជា ចំណាត់ថ្នាក់រូបភាព ការពិនិត្យមើលព័ត៌មានជាដើម។ ប៉ុន្តែជាមួយនឹងការអភិវឌ្ឍន៍យ៉ាងឆាប់រហ័សនៃ AI នាពេលថ្មីៗនេះ អ្នកវិទ្យាសាស្ត្រ និងអ្នកជំនាញបច្ចេកវិទ្យាមានការព្រួយបារម្ភថា ប្រសិនបើការអភិវឌ្ឍដោយមិនបានគ្រប់គ្រង ឬរៀបចំឡើងក្នុងគោលបំណងខុស បញ្ញាសិប្បនិម្មិតអាចបណ្តាលឱ្យមានផលវិបាកធ្ងន់ធ្ងរដល់មនុស្ស និងសង្គម។

ហានិភ័យនៃអសន្តិសុខ

បញ្ញាសិប្បនិម្មិតអាចគំរាមកំហែងដល់សន្តិសុខជាតិ និងសុវត្ថិភាពផ្ទាល់ខ្លួន។ Elon Musk បានព្រមានថា AI អាចក្លាយជាឧបករណ៍ដ៏គួរឱ្យភ័យខ្លាចក្នុងសង្គ្រាម។ ប្រសិនបើប្រទេសមួយអាចអភិវឌ្ឍប្រព័ន្ធបញ្ញាសិប្បនិម្មិតដ៏ល្អមួយនោះ វាអាចប្រើវាដើម្បីវាយប្រហារប្រទេសផ្សេងទៀត។ លោក Stuart Russell សាស្ត្រាចារ្យផ្នែកវិទ្យាសាស្ត្រកុំព្យូទ័រនៅសាកលវិទ្យាល័យកាលីហ្វ័រញ៉ា បានចំណាយពេលជាច្រើនទស្សវត្សរ៍ស្រាវជ្រាវអំពីបញ្ញាសិប្បនិម្មិត។ ដោយព្រមានអំពីការគំរាមកំហែងផ្នែកសន្តិសុខដែលបង្កឡើងដោយ AI លោកបាននិយាយថាឥឡូវនេះយើងអាចផលិតអាវុធវាយប្រហារដោយស្វ័យភាពដោយការរួមបញ្ចូល និងបង្រួមបច្ចេកវិទ្យាដែលមានស្រាប់។

ការពិសោធន៍នេះធ្វើឡើងដោយសាស្ត្រាចារ្យ Stuart Russell និងវិទ្យាស្ថានអនាគតនៃជីវិត (FLI) ដោយប្រើមនុស្សយន្តឃាតករ (slaughterbot) ដែលជាឧបករណ៍ហោះហើរមីក្រូទស្សន៍ដែលបំពាក់ដោយកាមេរ៉ា ឧបករណ៍ចាប់សញ្ញា កម្មវិធីកែច្នៃរូបភាព ការសម្គាល់មុខ សារធាតុផ្ទុះ 3 ក្រាម និងមីក្រូដំណើរការល្បឿនលឿន ដែលអនុញ្ញាតឱ្យការវិភាគទិន្នន័យ និងការឆ្លើយតបរបស់ខួរក្បាលមនុស្សលឿនជាង 100 ដង។ យោងតាមប៉ារ៉ាម៉ែត្រនៃការសរសេរកម្មវិធី មនុស្សយន្តឃាតករបន្តចូលប្រើទិន្នន័យពពក ដើម្បីស្វែងរកព័ត៌មានអំពីគោលដៅ និងស្វែងរកវិធីដើម្បីចូលទៅជិតវា។ ពេលរកឃើញហើយនឹងជិះសំដៅទៅគោលដៅក្នុងល្បឿនលឿនបាញ់គ្រាប់បែកទម្ងន់៣ក្រាមបាញ់ចូលលលាដ៍ក្បាលបណ្តាលឱ្យជនរងគ្រោះស្លាប់ក្នុងមួយប៉ព្រិចភ្នែក ។

វាគ្រាន់តែជាការពិសោធន៍ជាមួយ AI នៅកម្រិតមូលដ្ឋានបំផុតរបស់វា។ ប្រសិនបើ AI ត្រូវបានប្រើដើម្បីបង្កើតវិធីសាស្ត្រវាយប្រហារថ្មី និងទំនើបជាងនេះ វាក៏អាចបង្កើនសមត្ថភាពវាយប្រហាររបស់អ្នកវាយប្រហារ និងនាំទៅរកផលវិបាកធ្ងន់ធ្ងរជាងការវាយប្រហារធម្មតាទៅទៀត។ នៅពេលដែល AI ត្រូវបានបង្កើតឡើងរហូតដល់ចំណុចដែលវាអាចធ្វើការសម្រេចចិត្តដោយខ្លួនឯងដើម្បីដោះស្រាយជាមួយនឹងការផ្លាស់ប្តូរនៅក្នុងបរិយាកាសជុំវិញ ឬស្វែងរកគោលដៅជំនួស ឬពង្រីកជួរគោលដៅនោះ ប្រហែលជាមនុស្សជាតិនឹងមិនមានសុវត្ថិភាពទៀតទេ។ សហសេវិកជាច្រើននៅក្នុងវិស័យនេះយល់ស្របជាមួយសាស្រ្តាចារ្យ Stuart Russell ហើយជឿថានៅតែមានឱកាសដើម្បីការពារអនាគតដ៏អាក្រក់បែបនេះ ប៉ុន្តែយើងពិតជាមិនមានពេលច្រើនទេ។

ហានិភ័យនៃ AI ក្លាយជាការរៀបចំ ស្វ័យភាព និងការគ្រប់គ្រងប្រព័ន្ធ

AI អាចត្រូវបានរចនាឡើងដោយមិនត្រឹមត្រូវ ឬមិនត្រឹមត្រូវតាមរយៈការសិក្សាដោយម៉ាស៊ីន ហើយអាចធ្វើសកម្មភាពដែលមិនចង់បានដែលបង្កឱ្យខូចខាតដល់មនុស្ស និងបរិស្ថាន។ ឧទាហរណ៍ជាក់លាក់មានដូចខាងក្រោម៖ ជាមួយនឹងការរៀនម៉ាស៊ីន AI កាន់តែឆ្លាតវៃ។ នៅពេលដែលបញ្ញាសិប្បនិមិត្តឈានដល់កម្រិតនៃភាពវៃឆ្លាតដែលចេញពីការគាំទ្រដល់ប្រព័ន្ធសំខាន់ៗដូចជា អគ្គិសនី ការដឹកជញ្ជូន ការថែទាំសុខភាព ហិរញ្ញវត្ថុ ជាដើម វាអាចគ្រប់គ្រង និងគ្រប់គ្រងប្រព័ន្ធទាំងអស់នេះ ហើយធ្វើការសម្រេចចិត្តក្នុងស្ថានភាពអាសន្ន។ នៅពេលដែល AI ត្រូវបាន "បំពាក់" ជាមួយនឹងគោលបំណង "មហិច្ឆតា" បន្ថែម (ការរចនាខុស) វាអាចបណ្តាលឱ្យមានផលវិបាកធ្ងន់ធ្ងរជាច្រើន ដូចជាការរំខានដល់ប្រព័ន្ធចរាចរណ៍ ដោយបិទប្រព័ន្ធភ្លើងចរាចរណ៍ ឬកាត់ផ្តាច់ចរន្តអគ្គិសនីទៅកាន់ប្រព័ន្ធប្រតិបត្តិការរថភ្លើងក្នុងទីក្រុង បង្កឱ្យមានគ្រោះថ្នាក់ជាបន្តបន្ទាប់ បណ្តាលឱ្យដាច់ចរន្តអគ្គិសនី។ល។

មានភាពយន្តហូលីវូដជាច្រើន និងប្រទេសជាច្រើនទៀតដែលផ្អែកលើសេណារីយ៉ូនេះ។ ទោះបីជាយ៉ាងណាក៏ដោយ ជាមួយនឹងបច្ចេកវិទ្យា AI បច្ចុប្បន្ន នេះមិនមែនជាការរំពឹងទុកឆ្ងាយទៀតទេ ប៉ុន្តែអាចក្លាយជាការពិតទាំងស្រុង។ Elon Musk ជឿជាក់ថា ប្រសិនបើ AI ត្រូវបានអនុញ្ញាតឱ្យអភិវឌ្ឍដោយមិនអាចគ្រប់គ្រងបាន ដល់ចំណុចដែលវាអាចធ្វើការសម្រេចចិត្តដោយស្វ័យប្រវត្តិដោយគ្មានការអន្តរាគមន៍ពីមនុស្សនោះ វាអាចជាការគំរាមកំហែងដល់ការរស់រានមានជីវិតរបស់មនុស្ស។ នោះហើយជាមូលហេតុដែលគាត់ និងអ្នកជំនាញបច្ចេកវិទ្យារាប់ពាន់នាក់បានចុះហត្ថលេខាលើលិខិតស្នើសុំឱ្យបញ្ឈប់ជាបណ្តោះអាសន្ន និងការត្រួតពិនិត្យយ៉ាងតឹងរ៉ឹងនៃដំណើរការអភិវឌ្ឍ AI ក្នុងលក្ខណៈតម្លាភាព។ យោងតាមលោក Elon Musk ប្រព័ន្ធបញ្ញាសិប្បនិមិត្តគឺស្មុគស្មាញណាស់ ពិបាកយល់ និងគ្រប់គ្រងវាពិបាកណាស់។ បើគ្មានតម្លាភាព ការប្រើប្រាស់បញ្ញាសិប្បនិមិត្តក្នុងគោលបំណងគ្មានសីលធម៌ បង្កការខូចខាតដល់មនុស្ស ប្រាកដជានឹងកើតឡើង។

ហានិភ័យនៃការបាត់បង់ការងារ ការបំពានឯកជនភាព

នៅពេលប្រើដើម្បីប្រមូលព័ត៌មានផ្ទាល់ខ្លួន បច្ចេកវិទ្យាបញ្ញាសិប្បនិមិត្តអាចត្រូវបានប្រើដើម្បីរំលោភលើឯកជនភាព ធ្វើសកម្មភាពផ្សព្វផ្សាយព័ត៌មានមិនពិត និងផ្សព្វផ្សាយព័ត៌មានមិនពិតដែលប៉ះពាល់ដល់ស្ថិរភាពសង្គម និងនយោបាយ។ ឧប្បត្តិហេតុដែលប្រព័ន្ធបណ្តាញការិយាល័យគ្រប់គ្រងបុគ្គលិក (OPM) របស់រដ្ឋាភិបាលសហរដ្ឋអាមេរិកត្រូវបានវាយប្រហារដោយពួក Hacker គឺគួរឱ្យកត់សម្គាល់សម្រាប់ប្រទេស ឬអង្គការណាមួយ នៅពេលដែលទិន្នន័យផ្ទាល់ខ្លួនលម្អិត និងរសើបខ្លាំងនៃមន្ត្រីអាមេរិកបច្ចុប្បន្ន និងចូលនិវត្តន៍ចំនួន 21.5 លាននាក់ ព័ត៌មានអំពីប្តីប្រពន្ធរបស់ពួកគេ ទិន្នន័យអំពីអ្នកដែលបានដាក់ពាក្យសម្រាប់ការងាររដ្ឋាភិបាលដូចជាស្ថានភាពសុខភាព លំនៅដ្ឋាន ការងារ ស្នាមម្រាមដៃ និងព័ត៌មានហិរញ្ញវត្ថុរបស់ពួក Hacker បានធ្លាក់ចូលទៅក្នុងដៃ។ ទោះបីជាយ៉ាងណាក៏ដោយ មានការពិតដ៏គួរឱ្យភ័យខ្លាចជាងនេះទៅទៀត នៅពេលដែល CIA បានរកឃើញថា ចោរទិន្នន័យ OPM បានប្រើប្រាស់បច្ចេកវិទ្យាបញ្ញាសិប្បនិម្មិត ដើម្បីស្កេន ព័ត៌មានផ្ទាល់ខ្លួនក្លែងក្លាយ និងបង្កើតចារកម្មនិម្មិតដើម្បីលួចទិន្នន័យ។ ព័ត៌មានដែលត្រូវបានលួចនឹងត្រូវបានវិភាគ ចាត់ថ្នាក់ និងកេងប្រវ័ញ្ចដោយបច្ចេកវិទ្យា Bigdata សម្រាប់គោលបំណងជាក់លាក់។ បច្ចេកវិទ្យាបញ្ញាសិប្បនិមិត្តជួយឱ្យចោរព័ត៌មានកាត់បន្ថយពេលវេលាក្នុងការទាញយកព័ត៌មាន ដោយសារមនុស្សមិនមានលទ្ធភាពដំណើរការព័ត៌មានដ៏ច្រើនបែបនេះក្នុងរយៈពេលដ៏ខ្លីបែបនេះ។

បន្ថែមពីលើគ្រោះថ្នាក់ដែលមានស្រាប់ខាងលើ បច្ចេកវិទ្យា AI ក៏បង្កើតហានិភ័យផ្សេងទៀតដូចជា៖ ការពឹងផ្អែកលើវាហួសហេតុ ដែលនាំឱ្យមនុស្សបាត់បង់ការគ្រប់គ្រងលើស្ថានភាព និងកាត់បន្ថយសមត្ថភាពក្នុងការធ្វើការសម្រេចចិត្ត។ បញ្ញាសិប្បនិម្មិតក៏នឹងធ្វើឱ្យមនុស្សរាប់លាននាក់ សូម្បីតែរាប់រយលាននាក់បាត់បង់ការងាររបស់ពួកគេ ជាពិសេសសម្រាប់ការងារធ្វើដោយដៃសុទ្ធសាធ ដែលមានខ្លឹមសារចំណេះដឹងតិចតួច។ ជាលទ្ធផល បញ្ហាសង្គមធ្ងន់ធ្ងរដូចជា ភាពអត់ការងារធ្វើ ឧក្រិដ្ឋកម្ម គម្លាតរវាងអ្នកមាន និងអ្នកក្រ... នឹងកាន់តែស៊ីជម្រៅ។ លើសពីនេះ ភាពជឿជាក់ក៏ជាបញ្ហាដែលត្រូវលើកឡើងផងដែរ។ ភាពជឿជាក់នៃការសម្រេចចិត្តក្នុងវិស័យឯកទេសខ្ពស់ ដូចជាឱសថ ច្បាប់ព្រហ្មទណ្ឌ... មានសារៈសំខាន់ខ្លាំងណាស់។ នៅពេលប្រើ AI ដើម្បីជួយធ្វើការសម្រេចចិត្តក្នុងវិស័យទាំងនោះដែលបច្ចេកវិទ្យាមិនគួរឱ្យទុកចិត្តគ្រប់គ្រាន់ ដំណើរការដោយផ្អែកលើទិន្នន័យដែលមានទំនោរទៅរកមនុស្សមួយក្រុម ឬមួយក្រុម ឬត្រូវបានបង្ខូចទ្រង់ទ្រាយដោយចេតនា ការសម្រេចចិត្តទាំងនោះទំនងជាបណ្តាលឱ្យមានផលវិបាកធ្ងន់ធ្ងរ។

តើត្រូវការពារដោយរបៀបណា?

ហានិភ័យខាងលើគឺជាហេតុផលដែលលោក Elon Musk និងអ្នកជំនាញផ្នែកបច្ចេកវិទ្យាព្រួយបារម្ភអំពីការអភិវឌ្ឍន៍ដែលមិនអាចគ្រប់គ្រងបាននៃ AI និងបានសរសេរលិខិតអំពាវនាវឱ្យអង្គការសហប្រជាជាតិ និងអង្គការអន្តរជាតិគ្រប់គ្រងយ៉ាងតឹងរ៉ឹង ធានាសុវត្ថិភាព និងក្រមសីលធម៌ក្នុងការអភិវឌ្ឍន៍ AI ។ ពង្រឹងកិច្ចសហប្រតិបត្តិការអន្តរជាតិ ដើម្បីធានាថាបច្ចេកវិទ្យា AI ត្រូវបានប្រើប្រាស់ជាប្រយោជន៍សម្រាប់មនុស្ស និងសង្គម។ វិធានការជាក់លាក់មួយចំនួនអាចត្រូវបានកំណត់ថា:

- ការគ្រប់គ្រងភាពជឿជាក់នៃប្រព័ន្ធ៖ AI ចាំបាច់ត្រូវរចនា និងអភិវឌ្ឍដើម្បីធានាសុវត្ថិភាព និងភាពជឿជាក់ តាមរយៈការធ្វើតេស្តគុណភាព ការត្រួតពិនិត្យ និងតាមដានយ៉ាងម៉ត់ចត់ ទៀងទាត់ និងបន្ត ដើម្បីធានាថាប្រព័ន្ធ AI ដំណើរការតាមការរំពឹងទុករបស់មនុស្ស និងជៀសវាងផលប៉ះពាល់ដែលមិនចង់បានពីការខ្វះភាពជឿជាក់របស់វា។

- បច្ចេកវិទ្យាបញ្ញាសិប្បនិមិត្តត្រូវរៀបចំកម្មវិធីដើម្បីដំណើរការស្របតាមតម្លៃសីលធម៌ និងបទដ្ឋានសង្គម។ ច្បាប់ និងបទដ្ឋានទាំងនោះត្រូវតែបង្កើតឱ្យច្បាស់លាស់ ហើយត្រូវតែត្រួតពិនិត្យដើម្បីធានាថា ពួកគេមិនធ្វើអ្វីអាក្រក់ ឬបង្កគ្រោះថ្នាក់ដល់មនុស្ស ឬអង្គការ។ ដំណើរការនៃការវិភាគ វាយតម្លៃផលប៉ះពាល់ និងការត្រួតពិនិត្យប្រតិបត្តិការនៃប្រព័ន្ធ AI ក៏ត្រូវតែអនុវត្តជាប្រចាំផងដែរ ដើម្បីធានាថាដំណើរការបានត្រឹមត្រូវ មិនបំពាន និងបំផ្លាញតម្លៃរួមរបស់សង្គមទាំងមូល មិនបង្កផលប៉ះពាល់អវិជ្ជមាន និងធានាការបញ្ជូនចំណេះដឹង និងតម្លៃត្រឹមត្រូវ។

- ការផ្អាកនៅក្នុង "ការបណ្តុះបណ្តាល" នៃប្រព័ន្ធ AI យ៉ាងហោចណាស់ប្រាំមួយខែ ដើម្បីអនុញ្ញាតឱ្យមានការវាយតម្លៃឡើងវិញពេញលេញ។ ការផ្អាកនេះត្រូវតែជាសាធារណៈ គ្រប់គ្រង ហើយតួអង្គសំខាន់ៗទាំងអស់ដែលចូលរួមក្នុងវគ្គបណ្តុះបណ្តាលត្រូវតែចូលរួម។ បើចាំបាច់ រដ្ឋាភិបាលគួរតែដាក់ការផ្អាកបណ្តោះអាសន្ន។ នេះមិនមានន័យថាការបញ្ឈប់ទាំងស្រុងចំពោះការអភិវឌ្ឍន៍ AI នោះទេ ប៉ុន្តែគ្រាន់តែជាការផ្អាកមួយនៅក្នុងការប្រណាំងដ៏គ្រោះថ្នាក់ចំពោះគំរូអភិវឌ្ឍន៍ផ្សេងទៀត ដែលធ្វើឲ្យប្រព័ន្ធ AI កាន់តែមានភាពត្រឹមត្រូវ សុវត្ថិភាព អាចយល់បាន តម្លាភាព ជាប់លាប់ គួរឱ្យទុកចិត្ត និងស្មោះត្រង់។ នេះគឺជាដំណោះស្រាយដ៏ទូលំទូលាយដែល Elon Musk និងសហការីរបស់គាត់អំពាវនាវក្នុងលិខិតចំហរបស់ពួកគេ ប៉ុន្តែវាមិនអាចទៅរួចនោះទេ។ វាជាការលំបាកខ្លាំងណាស់សម្រាប់មន្ទីរពិសោធន៍ឯករាជ្យទាំងអស់ក្នុងការអនុលោមតាមការហៅទូរស័ព្ទដែលមិនជាប់កាតព្វកិច្ច និងឆ្លងប្រទេសបែបនេះ។

- ពង្រឹងកិច្ចសហប្រតិបត្តិការ និងការចែករំលែកព័ត៌មានរវាងប្រទេស និងអង្គការស្រាវជ្រាវ AI ឯករាជ្យ ដើម្បីធានាថា AI ត្រូវបានបង្កើតឡើង និងប្រើប្រាស់ដោយសុវត្ថិភាពនាពេលអនាគត។ កិច្ចសហប្រតិបត្តិការ និងការចែករំលែកព័ត៌មានក៏ជាវិធានការដើម្បីព្រមានភ្លាមៗ និងការពារហានិភ័យដែលអាចកើតឡើងនាពេលអនាគត។

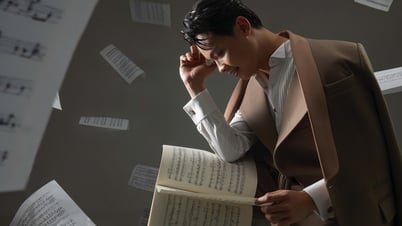

ជាទូទៅ AI មានវត្តមាននៅគ្រប់ទីកន្លែងជុំវិញខ្លួនយើង ហើយរឿងរ៉ាវដូចជា បញ្ញាសិប្បនិមិត្ត សរសេរកំណាព្យ សរសេរតន្ត្រី សរសេរអត្ថបទបានក្លាយទៅជាការពិត ហើយលែងជារឿងប្រឌិតទៀតហើយ។ អ្នកនិពន្ធអត្ថបទនេះខ្លួនគាត់ផ្ទាល់បានប្រើប្រាស់បច្ចេកវិទ្យាបញ្ញាសិប្បនិមិត្តនៅលើកុំព្យូទ័រ និងទូរស័ព្ទដើម្បីជួយ ធ្វើឱ្យដំណើរការសរសេររបស់គាត់កាន់តែងាយស្រួល និងលឿនជាងមុន។ ជាពិសេស ជំពូកនៃអត្ថបទនេះ និងគំនិតមួយចំនួនត្រូវបានស្នើឡើងដោយ AI ហើយជាពិសេសជាងនេះទៅទៀតនោះ រូបថតទាំងអស់ដែលប្រើប្រាស់ក្នុងអត្ថបទនេះត្រូវបានបង្កើតឡើងដោយ AI ។ បច្ចេកវិទ្យាបញ្ញាសិប្បនិមិត្តមានប្រយោជន៍ខ្លាំងណាស់ក្នុងការលើកកំពស់គុណភាពការងារ និងជីវិតរបស់មនុស្ស ប៉ុន្តែវាត្រូវតែគ្រប់គ្រងយ៉ាងតឹងរ៉ឹង ដើម្បីកុំឱ្យផុតពីការគ្រប់គ្រង និងក្លាយជាហានិភ័យនៃការជំនួសមនុស្សនាពេលអនាគត ដូចដែលបានព្យាករណ៍ដោយទ្រឹស្តីរូបវិទ្យា Stephen Hawking ។

អត្ថបទ និងរូបថត៖ ហ៊ុយ ដួងប្រភព

![[Infographic] នៅឆ្នាំ 2025 ផលិតផល 47 នឹងសម្រេចបាន OCOP ជាតិ](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/7/16/5d672398b0744db3ab920e05db8e5b7d)

Kommentar (0)