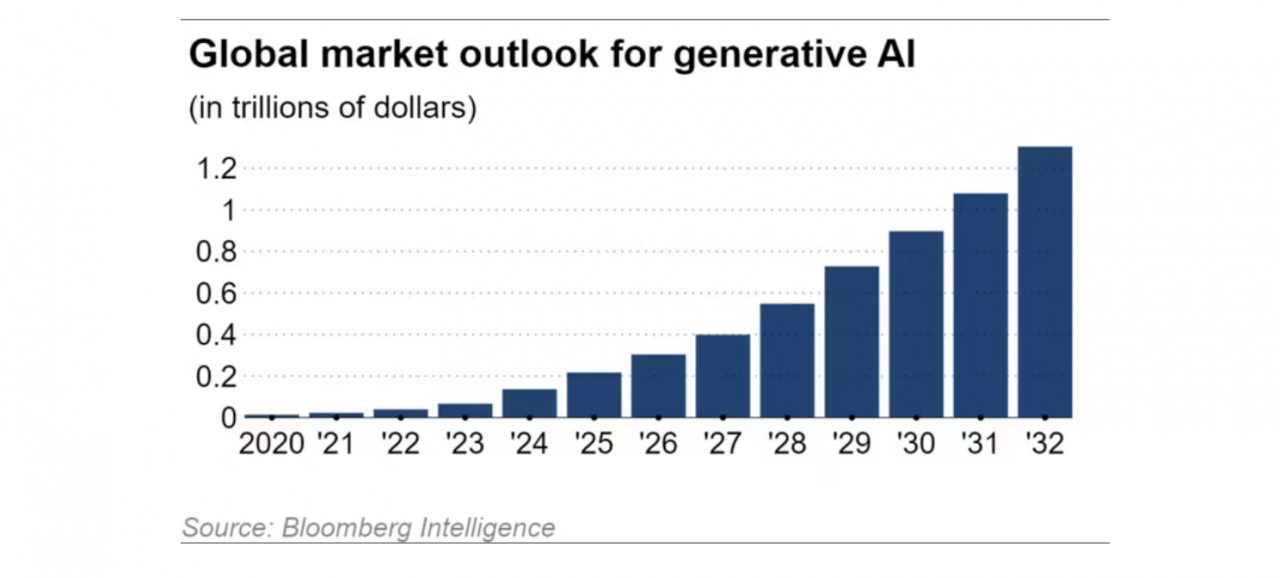

블룸버그 인텔리전스의 추산에 따르면 합성 AI의 글로벌 시장은 연간 42%씩 확대되고 있으며, 2032년까지 1조 3,000억 달러에 이를 것으로 예상됩니다. 이는 2022년 시장 규모인 400억 달러에서 약 32배 성장한 수치입니다.

이러한 흐름을 선도하는 것은 OpenAI, Google, Amazon과 같은 미국의 기술 기업입니다. 이들은 막대한 자금력과 인재를 보유한 기술 거대 기업입니다.

예일대학교 수학 교수이자 VBD의 최고 과학 책임자인 부 하 반(Vu Ha Van)은 치열한 경쟁에도 불구하고 VinGroup은 자체 버전을 개발하기로 결정하고 베트남 데이터를 사용하여 외국 경쟁사보다 정확도가 더 높은 AI를 개발했다고 말했습니다.

지금까지 생성 AI 프로그램은 주로 영어 데이터를 기반으로 학습되어 왔습니다. 즉, 베트남 관련 데이터가 상대적으로 부족하여 현지 문화, 역사, 법률에 대한 프로그램의 정확도가 떨어집니다.

ViGPT의 대규모 언어 모델(LLM)은 16억 개의 매개변수로 구성되어 있다고 하는데, 이는 OpenAI의 GPT-4 크기의 몇 퍼센트에 불과합니다.

일반적으로 매개변수가 많을수록 지능이 더 높습니다. 그러나 베트남 시장에 맞춰 제작된 일반 AI 평가에 따르면, ViGPT는 많은 해외 경쟁사보다 우수한 성과를 보였으며 ChatGPT에 이어 두 번째 점수를 기록했습니다.

빈패스트 그룹은 전기차 생산에 AI 기술을 적용할 예정입니다. 운전자는 베트남어 음성 명령으로 차량을 제어할 수 있습니다. 또한 금융, 보험, 물류 분야에도 AI를 접목할 계획입니다.

아시아의 AI 개발 경쟁

전 세계 인구의 약 5%만이 영어를 모국어로 사용하는 것으로 추정되는데, 이는 영어가 모국어가 아닌 사람을 위해 개발된 AI에 대한 엄청난 잠재적 수요가 있음을 의미합니다.

일본에서는 기업들이 일본어를 생성하는 AI를 개발하고 있습니다. 8월, 전자 대기업 NEC는 코토미(cotomi) LLM을 이용한 서비스를 출시했습니다. 통신사 NTT는 3월에 또 다른 LLM인 츠즈미(tsuzumi)를 기반으로 한 서비스를 출시할 예정입니다. 일본 이동통신사 소프트뱅크 또한 자체 LLM을 개발하고 있습니다.

소프트뱅크 사장인 미야카와 준이치(Junichi Miyakawa)는 "일본의 비즈니스 관행을 이해하면 이메일에 답하고 콜센터 업무를 보다 자연스럽게 처리하는 등 사용성 측면에서 이점이 있습니다." 라고 말했습니다.

토종 AI 개발 경쟁을 부추기는 요인은 미국에 대한 과도한 의존, 특히 국제 경쟁력과 국가 안보 측면에서의 과도한 의존에 따른 위험입니다. 또한, 다른 국가에서 개발된 AI 프로그램을 사용할 경우 민감한 정보를 침해할 수 있는 데이터 유출 사고가 발생할 수 있다는 우려도 있습니다.

반 교수는 점점 더 많은 학생들이 AI를 이용해 공부하고 있기 때문에, 신기술을 외국 기업에 맡겨서는 안 된다고 말했습니다. 이는 혁신이 젊은 세대에 큰 영향을 미친다는 것을 의미합니다.

미국과 기술 경쟁을 벌이고 있는 중국에서는 바이두, 텐센트 홀딩스, 알리바바 그룹 홀딩스가 혁신적인 AI를 개발하고 있습니다. 바이두의 어니봇은 작년 말 기준 1억 명이 넘는 사용자를 자랑했습니다.

바이두 회장 겸 CEO인 로빈 리(Robin Li)는 "우리가 현재 개발 중인 생성적 대규모 언어 모델은 중국어와 중국 시장에 더욱 적합할 것입니다." 라고 말했습니다.

지난 8월, 한국 인터넷 서비스 기업 네이버는 한국어에 특화된 합성 AI인 하이퍼클로바 X를 공개했습니다. 이 프로그램은 네이버의 검색 엔진 및 온라인 쇼핑 플랫폼과 통합되어 사용자가 원하는 결과를 더욱 효율적으로 찾을 수 있도록 지원할 예정입니다.

네이버는 자사의 한국어 데이터베이스가 ChatGPT의 한국어 데이터베이스보다 6,500배 더 크기 때문에 더 자연스럽게 읽히는 텍스트와 더 매끄러운 언어 인식이 가능하다고 밝혔습니다.

지난달 싱가포르는 인도네시아어, 말레이시아어, 태국어에 특화된 LLM(학사 학위 과정) 개발 계획을 발표했습니다. 그러나 이러한 계획은 사용 빈도가 낮은 언어로 학습할 수 있는 데이터 부족과 이러한 모델 개발의 수익성 저하 등의 어려움에 직면할 것입니다.

[광고_2]

원천

![[사진] 응에안성, 홍수로 543D 지방도 심각하게 침식돼](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/8/5/5759d3837c26428799f6d929fa274493)

댓글 (0)