ຫວ່າງມໍ່ໆມານີ້, ກົມຮັກສາຄວາມປອດໄພດ້ານຂໍ້ມູນຂ່າວສານໄດ້ອອກຄຳເຕືອນກ່ຽວກັບການສືບຕໍ່ສືບຕໍ່ມີການສໍ້ໂກງ ວິດີໂອ ເຕັກໂນໂລຢີສູງແລະຮູບພາບ.

ຕາມນັ້ນແລ້ວ, ສະຖານະການຂອງອາດຊະຍາກຳທາງອິນເຕີແນັດສວຍໃຊ້ຮູບພາບແລະວິດີໂອຂອງປະຊາຊົນເພື່ອແກ້ໄຂ, ຕັດຕໍ່, ຂົ່ມຂູ່ທີ່ຈະດຳເນີນການກະທຳຜິດດ້ວຍວິດີໂອປອມໄດ້ຖືກເຈົ້າໜ້າທີ່ກ່າວເຕືອນຢ່າງກວ້າງຂວາງເຖິງປະຊາຊົນເປັນຈຳນວນຫຼວງຫຼາຍ.

ການນໍາໃຊ້ເທກໂນໂລຍີ Deepfake ທີ່ອະນຸຍາດໃຫ້ການສືບພັນຂອງສຽງແລະຮູບພາບຂອງບຸກຄົນທີ່ມີຄວາມຖືກຕ້ອງສູງ, ຄະດີອາຍາສາມາດປອມຕົວເປັນຜູ້ນໍາໃນກອງປະຊຸມອອນໄລນ໌, ຫຼືສ້າງວິດີໂອແລະການໂທຫາເພື່ອດໍາເນີນການສໍ້ໂກງທາງດ້ານການເງິນ.

ນອກຈາກນັ້ນ, ການຫລອກລວງເຫຼົ່ານີ້ມັກຈະໃຊ້ປັດໃຈທາງຈິດໃຈເຊັ່ນ: ຄວາມຮີບດ່ວນ, ຄວາມຢ້ານກົວຫຼືພະລັງງານ, ເຮັດໃຫ້ຜູ້ຖືກເຄາະຮ້າຍປະຕິບັດຢ່າງໄວວາໂດຍບໍ່ມີການກວດສອບຄວາມຖືກຕ້ອງຢ່າງລະມັດລະວັງ.

Deepfakes ບໍ່ຈໍາກັດການຫລອກລວງການລົງທຶນທາງດ້ານການເງິນ. ຕົວຢ່າງອີກອັນຫນຶ່ງແມ່ນການຫລອກລວງ romance, ບ່ອນທີ່ Deepfakes ຖືກນໍາໃຊ້ເພື່ອສ້າງລັກສະນະ fictional ທີ່ພົວພັນກັບຜູ້ຖືກເຄາະຮ້າຍໂດຍຜ່ານການໂທວິດີໂອ; ຫຼັງຈາກໄດ້ຮັບຄວາມໄວ້ວາງໃຈຂອງຜູ້ຖືກເຄາະຮ້າຍ, ຜູ້ຫລອກລວງຈະຮ້ອງຂໍການໂອນເງິນເພື່ອແກ້ໄຂເຫດການສຸກເສີນ, ຄ່າໃຊ້ຈ່າຍໃນການເດີນທາງ, ຫຼືເງິນກູ້.

ຕໍ່ກັບສະພາບການຂ້າງເທິງນີ້, ກົມຮັກສາຄວາມປອດໄພຂໍ້ມູນຂ່າວສານ ສະເໜີໃຫ້ປະຊາຊົນລະວັງການແນະນຳການລົງທຶນຈາກບັນດາຄົນດັງໃນເຄືອຂ່າຍສັງຄົມ; ລະວັງຂອງຂໍ້ຄວາມທີ່ບໍ່ຮູ້ຈັກ, ອີເມວ ຫຼືການໂທ; ແລະລະມັດລະວັງການສັງເກດການສະແດງອອກທາງຫນ້າຜິດທໍາມະຊາດໃນວິດີໂອ.

ປະຊາຊົນຍັງຈໍາເປັນຕ້ອງຈໍາກັດການໂພດເນື້ອຫາທີ່ກ່ຽວຂ້ອງກັບຂໍ້ມູນສ່ວນບຸກຄົນໃນເຄືອຂ່າຍສັງຄົມເພື່ອຫຼີກເວັ້ນການມີຂໍ້ມູນເຊັ່ນຮູບພາບ, ວິດີໂອຫຼືສຽງທີ່ຖືກລັກໂດຍຄົນບໍ່ດີ; ໃນຂະນະດຽວກັນ, ຕັ້ງບັນຊີເປັນໂໝດສ່ວນຕົວເພື່ອປົກປ້ອງຂໍ້ມູນສ່ວນຕົວ.

ໂອ້ລົມກັບນັກຂ່າວໜັງສືພິມ Dai Doan Ket, ຜູ້ຊ່ຽວຊານດ້ານຄວາມປອດໄພທາງອິນເຕີເນັດ ທ່ານ Ngo Minh Hieu, ຜູ້ຮ່ວມກໍ່ຕັ້ງໂຄງການສະກັດກັ້ນການສໍ້ໂກງທາງອິນເຕີເນັດຂອງຫວຽດນາມ (Chongluadao.vn) ໃຫ້ຮູ້ວ່າ, ການນໍາໃຊ້ເຕັກໂນໂລຢີ Deepfake ໃນ AI ເພື່ອປອມແປງການໂທວິດີໂອເພື່ອຈຸດປະສົງການສໍ້ໂກງແມ່ນຍັງສັບສົນ. ວິຊາຂຸດຄົ້ນເຕັກໂນໂລຢີນີ້ເພື່ອເພີ່ມຄວາມຫນ້າເຊື່ອຖືຂອງ "ຜູ້ຖືກລ້າ".

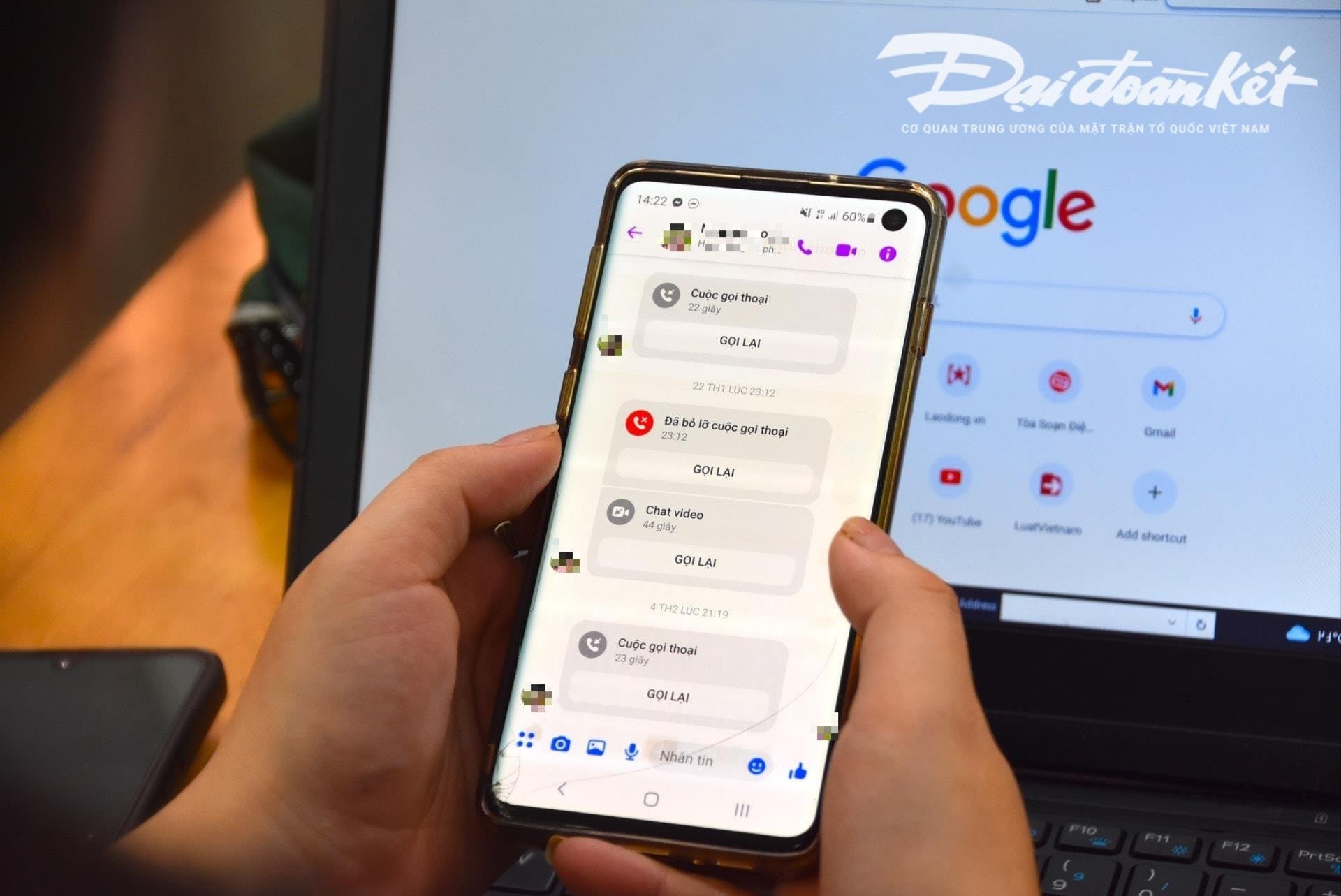

ໂດຍສະເພາະ, ວິຊາດັ່ງກ່າວຈະດໍາເນີນການໂທຫາວິດີໂອກັບຜູ້ຖືກເຄາະຮ້າຍຈາກຮູບພາບແລະວິດີໂອທີ່ "ຖືກລັກ" ກ່ອນຫນ້ານີ້ແລະດັດແປງເຕັກນິກ, ບິດເບືອນບັນຫາສຽງຫຼືຮູບພາບປອມເພື່ອໃຫ້ໄດ້ຮັບຄວາມໄວ້ວາງໃຈຂອງຜູ້ເຄາະຮ້າຍ.

ປົກກະຕິແລ້ວ, ການໂທເຫຼົ່ານີ້ແມ່ນສັ້ນຫຼາຍ, ໃຊ້ເວລາພຽງແຕ່ສອງສາມວິນາທີ, ຫຼັງຈາກນັ້ນພວກເຂົາໃຊ້ຂໍ້ແກ້ຕົວຂອງເຄືອຂ່າຍທີ່ບໍ່ຫມັ້ນຄົງ, ຢູ່ໃນຖະຫນົນ, ແລະອື່ນໆເພື່ອຂໍໃຫ້ຜູ້ຖືກເຄາະຮ້າຍປະຕິບັດຄໍາຮ້ອງຂໍຂອງຜູ້ຫລອກລວງ.

ຜູ້ຊ່ຽວຊານເຕືອນວ່າການນໍາໃຊ້ AI ສໍາລັບການສໍ້ໂກງທາງອິນເຕີເນັດອາດຈະເພີ່ມຂຶ້ນຢ່າງຫຼວງຫຼາຍໃນອະນາຄົດອັນໃກ້ນີ້. ດັ່ງນັ້ນ, ປະຊາຊົນຕ້ອງຍົກສູງຄວາມລະມັດລະວັງຂອງເຂົາເຈົ້າ, ໂດຍສະເພາະໃນເວລາທີ່ໄດ້ຮັບຂໍ້ຄວາມແປກ, ການໂທວິດີໂອ, ແລະການເຊື່ອມຕໍ່.

ອີງຕາມການວິເຄາະຂອງຜູ້ຊ່ຽວຊານນີ້, ປະຈຸບັນ Deepfake artificial intelligence (AI) algorithm ໃນລະຫວ່າງການໂທໃນເວລາຈິງຈະບໍ່ສາມາດຈັດການກັບມັນໄດ້ຖ້າຜູ້ໂທຫັນຊ້າຍ, ຫັນຂວາ, ຫຼືຢືນຂຶ້ນ ...

ຫນຶ່ງໃນຈຸດອ່ອນໂດຍສະເພາະທີ່ປະຊາຊົນຈໍາເປັນຕ້ອງໄດ້ເອົາໃຈໃສ່ໃນເວລາທີ່ໄດ້ຮັບການໂທເຫຼົ່ານີ້ແມ່ນແຂ້ວ. ຕາມນັ້ນແລ້ວ, AI algorithms ໃນປະຈຸບັນບໍ່ສາມາດແຜ່ພັນແຂ້ວຂອງຄົນທີ່ຖືກປອມເປັນໄດ້.

ຖ້າໃຊ້ Deepfake, ຮູບພາບຂອງຄົນເປີດປາກຂອງເຂົາເຈົ້າອາດຈະບໍ່ມີແຂ້ວ, ບາງຄົນອາດຈະມີຄາງກະໄຕ 3 ຫຼື 4 ແມ້ແຕ່. ດັ່ງນັ້ນ, ຄຸນລັກສະນະຂອງແຂ້ວແມ່ນອົງປະກອບທີ່ຮັບຮູ້ທີ່ສຸດຂອງການໂທປອມໂດຍໃຊ້ Deepfake.

"ການຊ້າລົງ" ແລະບໍ່ປະຕິບັດຕາມຄໍາຮ້ອງຂໍທັນທີແມ່ນເງື່ອນໄຂເບື້ອງຕົ້ນເພື່ອຫຼີກເວັ້ນການຕົກຢູ່ໃນຈັ່ນຈັບຫລອກລວງ. ເມື່ອໄດ້ຮັບຂໍ້ຄວາມ ຫຼື ໂທຜ່ານເຄືອຂ່າຍສັງຄົມ, ປະຊາຊົນຈໍາເປັນຕ້ອງໂທຫາຍາດພີ່ນ້ອງໂດຍກົງເພື່ອຢັ້ງຢືນວ່າໃຜເປັນຜູ້ຕິດຕໍ່ກັບເຂົາເຈົ້າໂດຍໃຊ້ເວລາຕໍາ່ສຸດທີ່ 30 ວິນາທີຫຼືພົບດ້ວຍຕົນເອງ.

ໃນກໍລະນີທີ່ສົງໃສວ່າມີການປອມຕົວເປັນຍາດຕິພີ່ນ້ອງໃນເຄືອຂ່າຍສັງຄົມເພື່ອສໍ້ໂກງຫຼືຊັບສິນທີ່ເຫມາະສົມ, ມັນຈໍາເປັນຕ້ອງໄດ້ລາຍງານໃຫ້ເຈົ້າຫນ້າທີ່ຕໍາຫຼວດທີ່ໃກ້ທີ່ສຸດເພື່ອສະຫນັບສະຫນູນແລະຈັດການໃຫ້ທັນເວລາ.

ທີ່ມາ: https://daidoanket.vn/chuyen-gia-chi-meo-nhan-biet-cuoc-goi-deepfake-lua-dao-10300910.html

(0)