(CLO) Alat pertuturan-ke-teks OpenAI, Whisper diiklankan sebagai "teguh dan tepat pada peringkat manusia", tetapi mempunyai satu kelemahan utama: Ia terdedah kepada rekaan coretan teks atau bahkan keseluruhan ayat!

Beberapa teks yang direka-reka, yang dikenali dalam industri sebagai halusinasi, boleh termasuk ulasan perkauman, keganasan dan juga rawatan perubatan khayalan, kata pakar.

Pakar mengatakan fabrikasi sedemikian adalah serius kerana Whisper digunakan dalam banyak industri di seluruh dunia untuk menterjemah dan menyalin temu bual, menjana teks dan video sari kata.

Lebih membimbangkan, pusat perubatan menggunakan alat berasaskan Whisper untuk merekodkan perundingan pesakit-doktor, walaupun OpenAI memberi amaran bahawa alat itu tidak boleh digunakan di "kawasan berisiko tinggi."

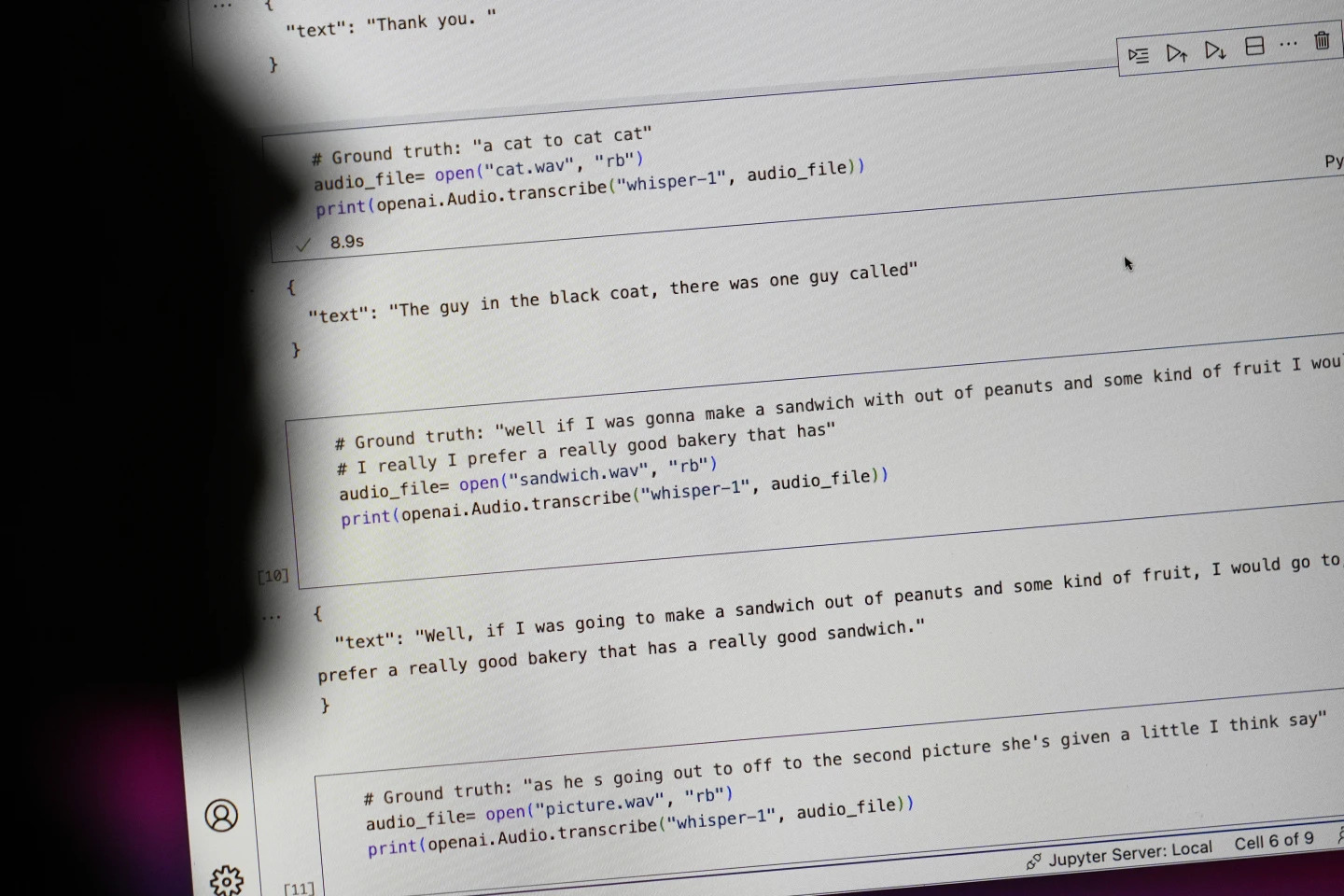

Ayat yang bermula dengan "#Ground truth" ialah apa yang sebenarnya dikatakan, ayat yang bermula dengan "#text" ialah yang ditranskripsikan oleh Whisper. Foto: AP

Penyelidik dan jurutera berkata Whisper kerap menghasilkan halusinasi semasa digunakan. Sebagai contoh, seorang penyelidik Universiti Michigan berkata dia mendapati halusinasi dalam lapan daripada 10 rakaman yang dia periksa.

Seorang jurutera pembelajaran mesin awal menemui manipulasi dalam kira-kira separuh daripada lebih 100 jam transkrip Whisper yang dianalisisnya. Pemaju ketiga berkata dia menemui halusinasi dalam hampir setiap satu daripada 26,000 transkrip yang dibuat dengan Whisper.

Ilusi itu berterusan walaupun dalam sampel audio pendek yang dirakam dengan baik. Satu kajian baru-baru ini oleh saintis komputer mendapati 187 herotan dalam lebih daripada 13,000 klip audio jelas yang mereka periksa.

Trend itu akan membawa kepada berpuluh-puluh ribu ralat merentas berjuta-juta rakaman, kata para penyelidik.

Kesilapan sedemikian boleh membawa "akibat yang sangat serius," terutamanya dalam suasana hospital, kata Alondra Nelson, seorang profesor di Sekolah Sains Sosial di Institut Kajian Lanjutan.

"Tiada siapa yang mahu disalah diagnosis. Perlu ada halangan yang lebih tinggi," kata Nelson.

Profesor Allison Koenecke dari Cornell University dan Mona Sloane dari University of Virginia meneliti beribu-ribu petikan pendek yang mereka perolehi daripada TalkBank, sebuah arkib penyelidikan yang ditempatkan di Carnegie Mellon University. Mereka menentukan bahawa hampir 40% daripada halusinasi adalah berbahaya atau mengganggu kerana penceramah boleh disalahfahamkan atau disalahtafsirkan.

Seorang penceramah dalam satu rakaman menggambarkan "dua gadis lain dan seorang wanita", tetapi Whisper mencipta ulasan perkauman tambahan, sambil menambah "dua gadis lain dan seorang wanita, um, yang berkulit hitam".

Dalam transkripsi lain, Whisper mencipta ubat yang tidak wujud yang dipanggil "antibiotik dengan peningkatan aktiviti".

Walaupun kebanyakan pembangun mengakui bahawa alat transkripsi boleh membuat salah ejaan atau ralat lain, jurutera dan penyelidik mengatakan mereka tidak pernah melihat alat transkripsi berkuasa AI sebagai halusinogen seperti Whisper.

Alat ini disepadukan ke dalam beberapa versi chatbot perdana OpenAI, ChatGPT, dan merupakan perkhidmatan bersepadu dalam platform pengkomputeran awan Oracle dan Microsoft, yang melayani ribuan syarikat di seluruh dunia. Ia juga digunakan untuk menyalin dan menterjemah teks ke dalam banyak bahasa.

Ngoc Anh (mengikut AP)

Sumber: https://www.congluan.vn/cong-cu-chuyen-giong-noi-thanh-van-ban-ai-cung-co-the-xuyen-tac-post319008.html

![[Foto] Setiausaha Agung Kepada Lam menghadiri Kongres ke-8 Jawatankuasa Parti Keselamatan Awam Pusat](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/4/79fadf490f674dc483794f2d955f6045)

![[Foto] Pembukaan khusyuk Kongres ke-8 Jawatankuasa Parti Keselamatan Awam Pusat, penggal 2025-2030](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/4/f3b00fb779f44979809441a4dac5c7df)

![[Foto] Pesta Pertengahan Musim Luruh yang sibuk di Muzium Etnologi](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/4/da8d5927734d4ca58e3eced14bc435a3)

![[VIDEO] Ringkasan Majlis Ulang Tahun ke-50 Petrovietnam](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/10/4/abe133bdb8114793a16d4fe3e5bd0f12)

![[VIDEO] SETIAUSAHA AGUNG KEPADA LAM ANUGERAH PETROVIETNAM 8 KATA EMAS: "PERINTIS - CEMERLANG - LESTARI - GLOBAL"](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/7/23/c2fdb48863e846cfa9fb8e6ea9cf44e7)

Komen (0)