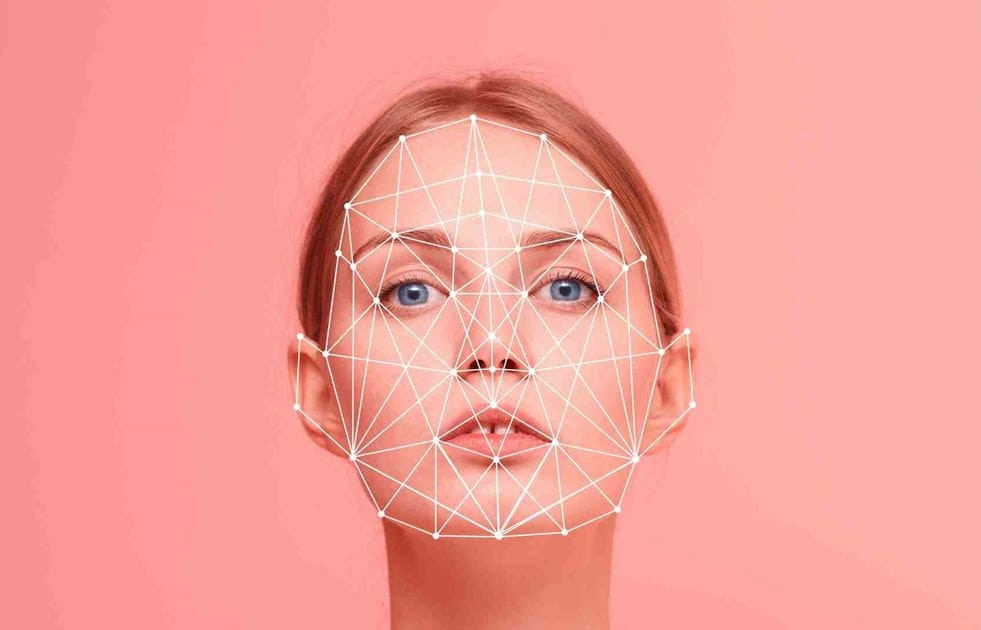

Deepfake er et begrep som er laget ved å kombinere «Deep Learning» og «Fake». Enkelt sagt er dette teknologien for å simulere og lage falske lyd-, bilde- eller til og med videoprodukter .

Siden den eksplosive utviklingen av kunstig intelligens (KI) har problemet med deepfakes blitt stadig mer populært, noe som har skapt bølger av falsk informasjon som sprer seg i pressen. Derfor er proaktiv autentisering av opprinnelsen til bilder og videoer et presserende spørsmål for verdens ledende kameraselskaper.

Sony, Canon og Nikon forventes å lansere digitale kameraer som støtter digitale signaturer direkte på deres speilløse kameraer (eller DSLR-digitalkameraer). Arbeidet med å implementere digitale signaturer på kameraer er et ekstremt viktig tiltak, som skaper bevis på opprinnelsen og integriteten til bilder.

Disse digitale signaturene vil inneholde informasjon om dato, klokkeslett, sted og fotograf, og vil være manipuleringssikre. Dette er spesielt viktig for fotojournalister og andre fagfolk hvis arbeid krever autentisering.

Tre giganter i kameraindustrien har blitt enige om en global standard for digitale signaturer som er kompatible med det nettbaserte verifiseringsverktøyet Verify. Verktøyet, som ble lansert av en koalisjon av globale nyhetsorganisasjoner, teknologiselskaper og kameraprodusenter, vil muliggjøre gratis verifisering av ektheten til ethvert bilde. Hvis bilder opprettes eller endres ved hjelp av AI, vil Verify flagge dem som «Ingen innholdsverifisering».

Betydningen av anti-deepfake-teknologier stammer fra den raske fremveksten av deepfakes av kjente personer som den tidligere amerikanske presidenten Donald Trump og den japanske statsministeren Fumio Kishida.

I tillegg har forskere fra Tsinghua-universitetet i Kina utviklet en ny generativ AI-modell som er i stand til å generere rundt 700 000 bilder per dag.

I tillegg til kameraprodusenter slutter andre teknologiselskaper seg til kampen mot deepfakes. Google har lansert et verktøy for å digitalt vannmerke AI-genererte bilder, mens Intel har utviklet teknologi som analyserer hudtoneendringer i bilder for å bidra til å bestemme autentisiteten deres. Hitachi jobber også med teknologi for å forhindre identitetssvindel på nett.

Den nye teknologien forventes å være tilgjengelig tidlig i 2024. Sony planlegger å markedsføre teknologien til media og har allerede gjennomført feltforsøk i oktober 2023. Canon samarbeider med Thomson Reuters og Starling Data Preservation Lab (et forskningsinstitutt grunnlagt av Stanford University og University of Southern California) for å videreutvikle teknologien.

Kameraprodusenter håper den nye teknologien vil bidra til å gjenopprette publikums tillit til bilder, som igjen former vår oppfatning av verden.

(ifølge OL)

Betalte 5000 dollar for at Facebook skulle spre deepfake-video om investeringssvindel

Ny skadevare tar kontroll over smarttelefoner, og deepfake-videoer blir mer sofistikerte.

Deepfake-videoer blir mer sofistikerte og realistiske

Hva skal man gjøre for å unngå å falle i fellen med Deepfake-videosamtaler som svindelforetak med pengeoverføringer?

Deepfake utnyttes til å sette ofrenes ansikter inn i pornovideoer

[annonse_2]

Kilde

![[Foto] Lam Dong: Nærbilde av ulovlig innsjø med ødelagt vegg](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/03/1762166057849_a5018a8dcbd5478b1ec4-jpg.webp)

![[Foto] Generalsekretær To Lam mottar Singapores ambassadør Jaya Ratnam](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/03/1762171461424_a1-bnd-5309-9100-jpg.webp)

![[Foto] Statsminister Pham Minh Chinh mottar formannen for Japan-Vietnam vennskapsforening i Kansai-regionen.](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/03/1762176259003_ndo_br_dsc-9224-jpg.webp)

![[Foto] Høstmessen 2025 og imponerende rekorder](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/03/1762180761230_ndo_br_tk-hcmt-15-jpg.webp)

Kommentar (0)