Imaginea complexă a utilizării roboților ucigași prin inteligență artificială

Permiterea controlului sistemelor de arme de către inteligența artificială ar putea însemna identificarea, atacarea și distrugerea țintelor fără intervenție umană. Acest lucru ridică serioase probleme juridice și etice.

Subliniind gravitatea situației, ministrul austriac de externe, Alexander Schallenberg, a declarat: „Acesta este Momentul Oppenheimer al generației noastre”.

Roboții și armele care utilizează inteligența artificială încep să fie utilizate pe scară largă în armatele multor țări. Foto: Forbes

Într-adevăr, măsura în care „duhul a scăpat de sticlă” a devenit o întrebare presantă, deoarece dronele și inteligența artificială (IA) au devenit utilizate pe scară largă de către armatele din întreaga lume .

„Utilizarea dronelor în conflictele moderne de către Rusia și Ucraina, utilizarea dronelor de către SUA în operațiuni de atac țintite în Afganistan și Pakistan și, așa cum s-a dezvăluit recent luna trecută, ca parte a programului Lavender al Israelului, arată cum capacitățile de procesare a informațiilor ale inteligenței artificiale sunt utilizate activ de către armatele lumii pentru a-și spori puterea ofensivă”, a declarat Wilson Jones, analist în domeniul apărării la GlobalData.

Investigațiile efectuate de Office of War Investigative Journalism, cu sediul la Londra, au descoperit că sistemul de inteligență artificială Lavender al armatei israeliene avea o rată de precizie de 90% în identificarea persoanelor cu legături cu Hamas, ceea ce înseamnă că 10% nu aveau legături. Acest lucru a dus la decese în rândul civililor din cauza capacităților de identificare și luare a deciziilor ale inteligenței artificiale.

O amenințare la adresa securității globale

Utilizarea inteligenței artificiale în acest mod subliniază necesitatea de a gestiona tehnologia în sistemele de armament.

„Utilizarea IA în sistemele de armament, în special atunci când este utilizată pentru țintire, ridică întrebări fundamentale despre noi - oamenii - și despre relația noastră cu războiul și, mai precis, despre presupunerile noastre despre cum am putea folosi violența în conflictele armate”, a explicat pentru Army Technology dr. Alexander Blanchard, cercetător senior în cadrul programului Guvernanța Inteligenței Artificiale de la Institutul Internațional de Cercetare a Păcii din Stockholm (SIPRI), un grup de cercetare independent axat pe securitatea globală.

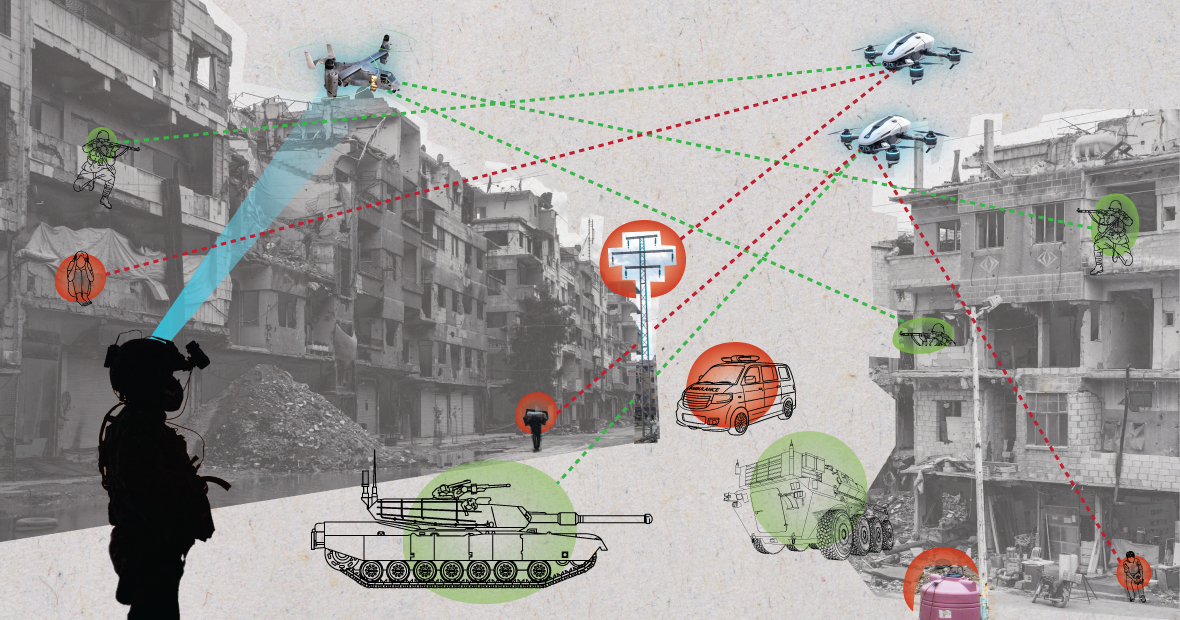

Sistemele de inteligență artificială, atunci când sunt utilizate în medii haotice, se pot comporta imprevizibil și pot eșua în identificarea cu precizie a țintelor. Foto: MES

„Schimbă IA modul în care armata selectează țintele și aplică forța asupra lor? Aceste schimbări, la rândul lor, ridică o serie de întrebări juridice, etice și operaționale. Cele mai mari preocupări sunt de natură umanitară”, a adăugat dr. Blanchard.

„Mulți sunt îngrijorați că, în funcție de modul în care sunt proiectate și utilizate sistemele autonome, acestea ar putea expune civilii și alte persoane protejate de dreptul internațional unui risc mai mare de vătămare”, a explicat expertul SIPRI. „Acest lucru se datorează faptului că sistemele de inteligență artificială, în special atunci când sunt utilizate în medii haotice, pot funcționa imprevizibil și pot eșua în a identifica cu precizie țintele și a ataca civilii sau în a identifica combatanții care nu sunt în luptă.”

Detaliind problema, analistul Wilson Jones de la GlobalData în domeniul apărării a remarcat că modul în care se stabilește vinovăția ar putea fi discutabil.

„În conformitate cu legislația actuală privind războiul, există conceptul de responsabilitate a comandantului”, a spus dl Jones. „Aceasta înseamnă că un ofițer, general sau alt lider este responsabil din punct de vedere legal pentru acțiunile trupelor aflate sub comanda sa. Dacă trupele comit crime de război, ofițerul este responsabil chiar dacă nu a dat ordinele; sarcina probei îi revine lui, care trebuie să demonstreze că a făcut tot posibilul pentru a preveni crimele de război.”

„În cazul sistemelor de inteligență artificială, acest lucru complică lucrurile. Este responsabil un tehnician IT? Un proiectant de sistem? Nu este clar. Dacă nu este clar, se creează un risc moral dacă actorii consideră că acțiunile lor nu sunt protejate de legile existente”, a subliniat dl Jones.

Un soldat american patrulează cu un câine robot. Foto: Forbes

Convenții privind controlul armelor Mai multe acorduri internaționale majore limitează și reglementează anumite utilizări ale armelor. Există interdicții privind armele chimice, tratate de neproliferare nucleară și Convenția privind anumite arme convenționale, care interzice sau limitează utilizarea anumitor arme considerate a cauza suferințe inutile sau nejustificate beligeranților sau a afecta civilii în mod nediscriminatoriu.

„Controlul armelor nucleare a necesitat decenii de cooperare internațională și de tratate ulterioare pentru a fi aplicate”, explică analistul în domeniul apărării Wilson Jones. „Chiar și atunci, am continuat testele atmosferice până în anii 1990. Un motiv major pentru care neproliferarea nucleară a avut succes a fost cooperarea dintre Statele Unite și Uniunea Sovietică în cadrul ordinii mondiale bipolare. Aceasta nu mai există, iar tehnologia care creează IA este mai accesibilă multor țări decât energia nucleară.”

„Un tratat obligatoriu ar trebui să-i aducă la masă a negocierilor pe toți actorii relevanți, care să fie de acord să nu utilizeze un instrument care le sporește puterea militară. Este puțin probabil ca acest lucru să funcționeze, deoarece IA poate îmbunătăți eficacitatea militară cu costuri financiare și materiale minime.”

Perspectiva geopolitică actuală

Deși țările din cadrul Națiunilor Unite au recunoscut necesitatea utilizării militare responsabile a inteligenței artificiale, mai sunt multe de făcut.

„Fără un cadru de reglementare clar, aceste afirmații rămân în mare parte aspiraționale”, a declarat Laura Petrone, analist principal la GlobalData, pentru Army Technology. „Nu este surprinzător faptul că unele țări doresc să-și păstreze propria suveranitate atunci când decid în chestiuni de apărare internă și securitate națională, mai ales în climatul geopolitic actual.”

Dna Petrone a adăugat că, deși Legea UE privind IA stabilește anumite cerințe pentru sistemele de IA, aceasta nu abordează sistemele de IA în scopuri militare.

„Cred că, în ciuda acestei excluderi, Legea IA reprezintă un efort important de a stabili un cadru de mult așteptat pentru aplicațiile IA, ceea ce ar putea duce la un anumit grad de uniformitate a standardelor relevante în viitor”, a comentat ea. „Această uniformitate va fi importantă și pentru IA în domeniul militar.”

Nguyen Khanh

Sursă: https://www.congluan.vn/moi-nguy-robot-sat-thu-ai-dang-de-doa-an-ninh-toan-cau-post304170.html

![Tranziția Dong Nai OCOP: [Articolul 3] Legarea turismului cu consumul de produse OCOP](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/11/10/1762739199309_1324-2740-7_n-162543_981.jpeg)

Comentariu (0)