(Дэн Три) — Объём данных, используемых для обучения искусственного интеллекта, почти исчерпан, что вынуждает исследователей использовать ИИ для обучения друг друга. Это может стать прорывом, который поможет ИИ превзойти человеческий интеллект.

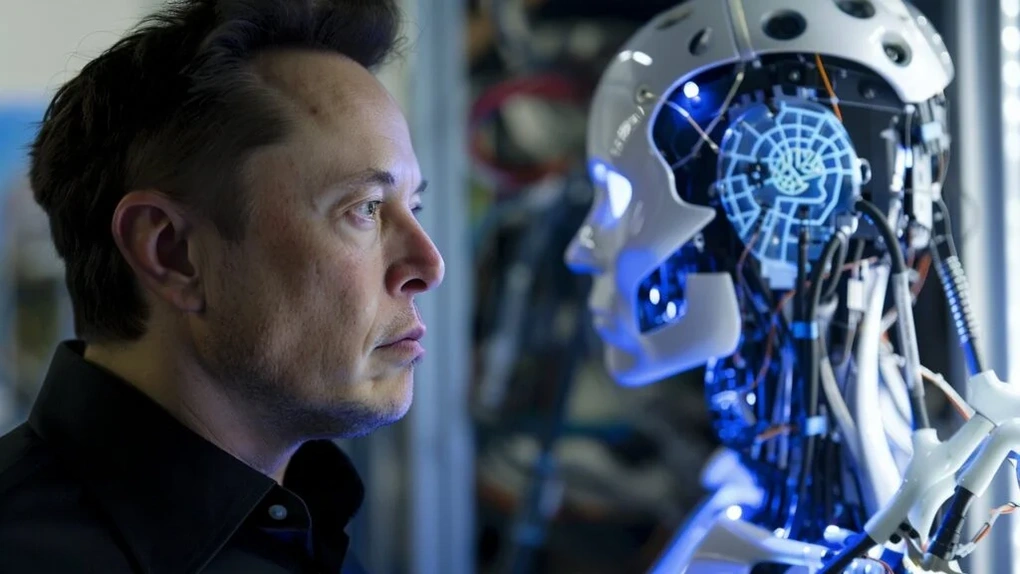

Илон Маск предлагает новые способы развития ИИ, которые могут быть опасны

Технический миллиардер Илон Маск, основатель компании xAI, занимающейся разработкой искусственного интеллекта, только что опубликовал шокирующую информацию о процессе обучения и воспитания моделей искусственного интеллекта (ИИ).

«Мы исчерпали весь объём человеческих знаний в области обучения и воспитания ИИ. По сути, это произошло ещё в прошлом году», — ответил Илон Маск в интервью, которое транслировалось в прямом эфире в социальной сети X 9 января.

Модели ИИ, такие как GPT-4, Gemini, Grok или Llama... обучаются на основе больших объемов данных, собранных из Интернета, из научных журналов, опубликованных исследований, данных пользователей в социальных сетях...

Илон Маск предлагает использовать данные ИИ для обучения ИИ, но это сопряжено со многими потенциальными рисками (Иллюстрация: Getty).

Однако темпы развития моделей ИИ настолько быстры, что объем доступных данных уже недостаточен для обучения и повышения интеллекта этих моделей ИИ.

Чтобы преодолеть эту проблему, Илон Маск предложил решение, которое заключается в переходе к использованию данных, генерируемых самим ИИ, для обучения его моделей. Другими словами, ИИ может обучаться сам и обучать друг друга, не полагаясь на данные, предоставляемые людьми.

«Единственный способ решить эту проблему — дополнить синтетические данные, генерируемые самими моделями ИИ, и использовать эти данные для обучения самого ИИ», — поделился Илон Маск.

Системы искусственного интеллекта, обучающиеся на основе синтетических данных, генерируемых самим ИИ, помогут сократить затраты на разработку и снизить зависимость от данных, полученных от человека. Это заставляет многих опасаться, что ИИ способен обучаться и превзойти человеческий интеллект, выйдя за рамки контроля человечества.

Однако эксперты по искусственному интеллекту утверждают, что использование синтетических данных, созданных самим ИИ, для обучения моделей ИИ может привести к разрушению этих моделей, если созданные данные не являются креативными, предвзятыми и не обновляются последними данными.

«Когда вы используете синтетические данные для обучения моделей ИИ, их производительность постепенно снижается, а выходные данные становятся неинтересными и предвзятыми», — говорит Эндрю Дункан, директор по ИИ в Институте Алана Тьюринга в Великобритании.

Высококачественные данные считаются бесценным «ресурсом», за который конкурируют компании, разрабатывающие искусственный интеллект. Однако не все учёные готовы предоставлять свои исследования для обучения моделей искусственного интеллекта.

Google удалось создать ИИ, который думает и действует точно так же, как человек

Представьте себе, что у вас есть средство, позволяющее определить личность человека, его взгляды и стиль, а затем создать копию этого человека с помощью искусственного интеллекта.

Это не научная фантастика, а основная цель новаторского исследования ученых Стэнфордского университета и Google.

Всего за 2 часа собеседования Google может создать ИИ, который думает и действует точно так же, как вы (Фото: ZipRecruiter).

Используя информацию из интервью, длившихся всего два часа, исследователи создали искусственный интеллект, имитирующий поведение более 1000 участников. Эти искусственные интеллекты способны имитировать поведение человека.

Потенциал применения этого изобретения огромен. Политики и компании могли бы использовать эту ИИ-симуляцию для прогнозирования реакции общественности на новые политические решения или продукты, вместо того чтобы полагаться исключительно на фокус-группы или повторяющиеся опросы.

Исследователи полагают, что эта технология может помочь в изучении социальных структур, пилотных вмешательств и разработке детальных теорий человеческого поведения.

Однако это также сопряжено с определёнными рисками, такими как этические проблемы, связанные с неправомерным использованием клонов ИИ. Злоумышленники могут использовать этот ИИ для манипулирования общественным мнением, выдавая себя за других людей или имитируя общественные предпочтения на основе поддельных синтетических данных.

Эти опасения также соответствуют давней обеспокоенности многих тем, что распространение подобных моделей ИИ может оказать негативное влияние на будущее человечества.

Источник: https://dantri.com.vn/suc-manh-so/ai-sap-dat-duoc-buoc-dot-pha-moi-co-the-vuot-qua-tri-tue-con-nguoi-20250111132229246.htm

![[Фото] Многие люди непосредственно сталкиваются с любимым дядей Хо и Генеральными секретарями](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/9/6/2f4d9a1c1ef14be3933dbef3cd5403f6)

![[Фото] Генеральный секретарь То Лам принимает участие в праздновании 80-летия Генерального штаба Вьетнамской народной армии](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/9/6/126697ab3e904fd68a2a510323659767)

![[Фото] 80-летие Генерального штаба Вьетнамской народной армии](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/9/6/49153e2a2ffc43b7b5b5396399b0c471)

![[Фото] Спасение людей в затопленных районах у подножия перевала Пренн ночью](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/9/6/19095b01eb844de98c406cc135b2f96c)

Комментарий (0)