Мошеннические звонки с дипфейком: новый и очень изощрённый вид мошенничества

Типичный случай — г-жа ВТМ (26 лет, Лонгбьен, Ханой ), которая получила сообщение от родственника из-за рубежа с просьбой перевести 75 миллионов донгов на определённый счёт. В тот момент г-жа ВТМ приняла это за родственника и, не раздумывая, перевела деньги.

Г-жа ВТМ рассказала, что, получив сообщение с просьбой одолжить деньги у родственника, она осторожно перезвонила, чтобы проверить видео , и увидела, что на изображении действительно была её подруга. Г-жа ВТМ доверилась ей и перевела деньги. Но через некоторое время она увидела на личной странице родственника сообщение о том, что его аккаунт в Facebook был взломан мошенником, чтобы попросить денег у друзей и родственников. Г-жа ВТМ перезвонила родственнику и узнала, что его обманули.

Или вот случай с г-ном VDC (42 года, Ко Нюэ, Ханой), который рассказал, что его обманули на 30 миллионов донгов с помощью фейкового видеозвонка. В частности, недавно с зарубежного счёта родственника пришло сообщение с просьбой занять денег по срочному делу. Сразу после этого г-жа Там получила видеозвонок через приложение Facebook Messenger.

«Разговор длился всего несколько секунд, но я увидел лицо любимого человека и привычное обращение к нему, но звонок прерывался. Затем я получил сообщение о слабом сигнале и невозможности продолжить видеозвонок. Для удобства я перешёл на SMS. Я доверился ему и перевёл деньги, как и было сказано», — рассказал г-н VDC.

Комментируя эту проблему, эксперт по технологиям Нго Минь Хьеу из Национального центра мониторинга кибербезопасности (NCSC) отметил, что технологии искусственного интеллекта (ИИ) значительно облегчают жизнь людей. Однако злоумышленники используют их для создания изображений, имитирующих голос, – от взлома аккаунтов Facebook и Instagram до изучения сообщений, форм адресов и истории транзакций, чтобы совершать поддельные звонки и выманивать деньги у родственников и членов семьи, владеющих взломанным аккаунтом, а также звонить жертве напрямую, чтобы создать срочные ситуации, требующие денежных переводов.

«После того, как мошенник захватил контроль над аккаунтом жертвы в Facebook, он заранее отправил ей сообщение с просьбой занять денег, затем заранее совершил видеозвонок с помощью Deepfake-видео и повесил трубку на несколько секунд, после чего сообщил, что потерял сигнал телефона... В этот момент жертва доверилась ему и перевела деньги, поскольку другой стороне нужно было срочно занять деньги», — прокомментировал эксперт по технологиям Нго Минь Хьеу.

Г-н Нго Туан Ань, председатель совета директоров и генеральный директор Smart Cyber Security Joint Stock Company, отметил, что в настоящее время интернет-мошенничество можно разделить на два основных метода: выдача себя за следственные органы и суды и эксплуатация «жадности» людей, например, получение крупных вознаграждений и лёгких денег... Эти два вида мошенничества предполагают множество различных сценариев, включая вариант, когда пользователям предлагают перепроверить информацию, совершив видеозвонок. Этот метод «нейтрализации» был придуман мошенниками для обмана жертв.

Как работает дипфейк?

По данным полиции города Ханой, Deepfake — это технология, которая использует искусственный интеллект (ИИ) для создания аудио-, видео- и визуальных продуктов, которые с очень высокой точностью подделывают реальные объекты.

На основе файла изображения лица и голоса реального человека Deepfake использует алгоритмы для воссоздания лица и голоса, соответствующих чертам лица и мимике другого человека, а затем создаёт видео, полностью имитирующее реального человека. В интернете пользователи собирают изображения и голоса пользователей социальных сетей, используя технологию Deepfake для создания анимаций и фейковых видеороликов, где пользователи общаются в интернете с тем же выражением лица, тем же тоном голоса и манерой общения.

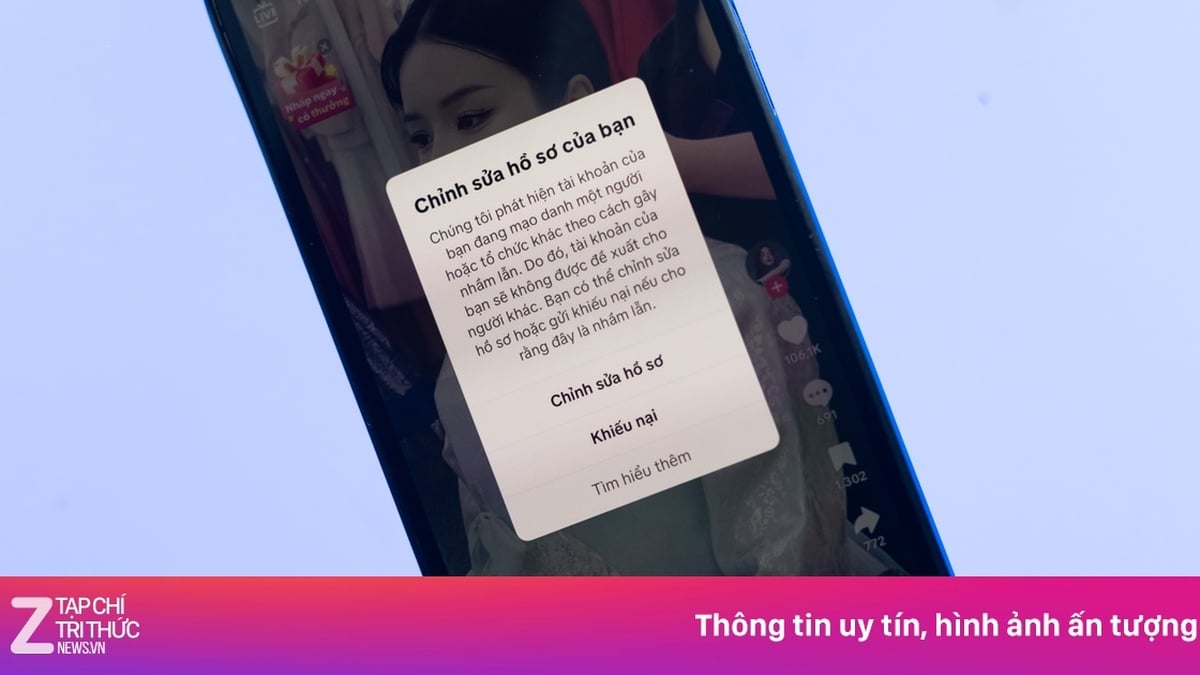

Субъект создаёт поддельные аккаунты в социальных сетях с той же информацией и фотографиями профиля, что и у пользователя, добавляет жертву в друзья и отправляет сообщения с просьбой одолжить деньги по заранее разработанному сценарию. В некоторых случаях субъект взламывает аккаунт пользователя в социальных сетях, чтобы напрямую отправлять сообщения жертвам из списка друзей. Чтобы завоевать доверие жертвы, субъект загружает в канал видеозвонка уже существующие видео с дипфейком, заставляя жертву узнавать изображение и голос знакомого и быстро переводить деньги по просьбе субъекта.

Полиция Ханоя добавила, что благодаря технологии Deepfake поддельные видео обладают высокой точностью, что затрудняет различение настоящих и поддельных. Однако видео, создаваемые мошенниками, часто имеют общий характер, не полностью соответствующий реальному контексту общения с жертвой, что может вызвать у неё подозрения и привести к раскрытию информации. Чтобы скрыть вышеперечисленные недостатки, мошенники часто создают видео с плохо слышимым звуком и нечётким изображением, похожие на видеозвонки с нестабильным сигналом, совершаемые в районах со слабым покрытием мобильной связи/Wi-Fi. Это очень новый и очень изощрённый вид мошенничества.

Как предотвратить кражу данных лица и голоса?

По словам технологического эксперта Нго Минь Хьеу, лучший способ избежать Deepfake — ограничить распространение личных изображений или видео в Интернете, а также всегда защищать аккаунты социальных сетей и электронной почты паролями высокого уровня.

Если вы делитесь видео или клипами в Интернете, вам следует исказить свой голос и заменить его голосом робота или искусственного интеллекта, чтобы злоумышленники не узнали ваш настоящий голос.

Если Deepfake оказывается фейком, пользователи должны немедленно уведомить всех и сообщить об этом властям по адресу canhbao.ncsc.gov.vn или сообщить в проект chongluadao https://chongluadao.vn; в то же время необходимо повышать осведомленность о распознавании мошенничества в киберпространстве по адресу: dauhieuluadao.com.

Полиция города Ханой рекомендует гражданам проявлять бдительность при получении любых сообщений или видеозвонков с предложением одолжить или дать деньги в долг через социальные сети. Необходимо сохранять спокойствие при получении любых сообщений или видеозвонков с предложением одолжить или дать деньги в долг через социальные сети, а затем позвонить или связаться с родственниками напрямую для проверки (не звоните через такие приложения, как Zalo, Messenger, Viber, Telegram и т.д.). В случае подозрения, что кто-то выдает себя за родственника в социальных сетях с целью мошенничества или присвоения имущества, необходимо немедленно обратиться в ближайшее отделение полиции для своевременной поддержки, а также для пресечения, предотвращения и строгого соблюдения закона.

Рассказывая о том, как предотвратить и бороться с мошенническими звонками, г-н Нго Туан Ань отметил, что людям следует быть бдительными и не переходить по подозрительным ссылкам. Если вы переводите деньги, есть простой и эффективный способ проверки: проверьте в интернет-банкинге банка, отображается ли корректная информация о родственниках и друзьях при вводе номера счета перед переводом.

Эксперт по технологиям Нго Минь Хьеу сказал, что признаком, по которому можно распознать и избегать дипфейковых звонков, является отсутствие эмоций на лице персонажа на видео, его «безразличие» во время речи, неловкая, неестественная поза или несоответствие направления головы и тела персонажа на видео.

По данным компаний, занимающихся безопасностью, Deepfake — это сочетание слов «deep» (глубокий), «deep learning» (глубокое обучение) и «fake» (подделка). Глубокое обучение — это использование передовых методов искусственного интеллекта, которые применяют множество алгоритмов для постепенного синтеза расширенных признаков на основе входных данных. Эта технология способна синтезировать и обучаться на основе данных, вводимых пользователями, таких как человеческие лица, движения и голоса. Deepfake позволяет сопоставлять лица одного человека с другим на видео с высокой степенью достоверности. |

ОФИСНЫЙ СТИЛЬ

Источник

![[Морские новости] Более 80% мировых контейнерных перевозок находится в руках MSC и крупных судоходных альянсов.](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/7/16/6b4d586c984b4cbf8c5680352b9eaeb0)

Комментарий (0)