Как сообщает Reuters, Ник Клегг, президент Meta по глобальным вопросам, заявил, что компания будет использовать набор маркеров, интегрированных в файлы. Компания будет присваивать метки любому контенту, размещенному в ее сервисах Facebook, Instagram и Threads, чтобы дать пользователям понять, что изображения (которые могут напоминать реальные фотографии) являются цифровыми продуктами, созданными с помощью искусственного интеллекта. Компания также маркировала контент, созданный с использованием собственных инструментов ИИ.

После того как новая система будет внедрена и начнет функционировать, Meta будет делать то же самое для изображений, созданных с помощью сервисов OpenAI, Microsoft, Adobe, Midjourney, Shutterstock и Alphabet. Это объявление впервые сообщает о новой стандартной системе, которую технологические компании разрабатывают для смягчения вреда, причиняемого технологиями, созданными с помощью ИИ, которые могут создавать поддельный контент, используя только простые источники.

Разметка изображений, созданных с помощью ИИ, поможет ограничить распространение дезинформации и мошенничества.

Этот подход основан на модели, сложившейся за последнее десятилетие, когда компании координируют удаление запрещенного контента с платформ, такого как изображения массового насилия и эксплуатации детей.

Клегг считает, что на данном этапе компании могут надежно размечать изображения, созданные с помощью ИИ, отмечая при этом, что более сложные инструменты для аннотирования аудио- и видеоконтента все еще находятся в стадии разработки.

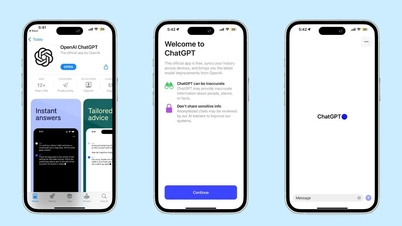

Первоначально Meta начнет требовать от пользователей маркировки измененного аудио- и видеоконтента и будет налагать штрафы за несоблюдение этого требования. Однако Клегг заявил, что в настоящее время нет жизнеспособного механизма для маркировки текста, сгенерированного инструментами искусственного интеллекта, такими как ChatGPT.

Независимый наблюдательный совет Meta раскритиковал политику компании в отношении видеороликов, отредактированных с вводящим в заблуждение смыслом, утверждая, что контент следует маркировать, а не удалять. Поэтому Клегг считает, что новый шаг Meta может помочь лучше классифицировать подобный контент.

Ссылка на источник

![[Изображение] Утекшие в сеть фотографии в преддверии гала-церемонии вручения премии Community Action Awards 2025.](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765882828720_ndo_br_thiet-ke-chua-co-ten-45-png.webp&w=3840&q=75)

![[Фото] Премьер-министр Фам Минь Чинь принимает губернатора провинции Тотиги (Япония)](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765892133176_dsc-8082-6425-jpg.webp&w=3840&q=75)

![[Прямая трансляция] Гала-церемония вручения наград за общественную деятельность 2025 года](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765899631650_ndo_tr_z7334013144784-9f9fe10a6d63584c85aff40f2957c250-jpg.webp&w=3840&q=75)

![[Фото] Премьер-министр Фам Минь Чинь принимает министра образования и спорта Лаоса Тонгсалит Мангнормек.](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765876834721_dsc-7519-jpg.webp&w=3840&q=75)

Комментарий (0)