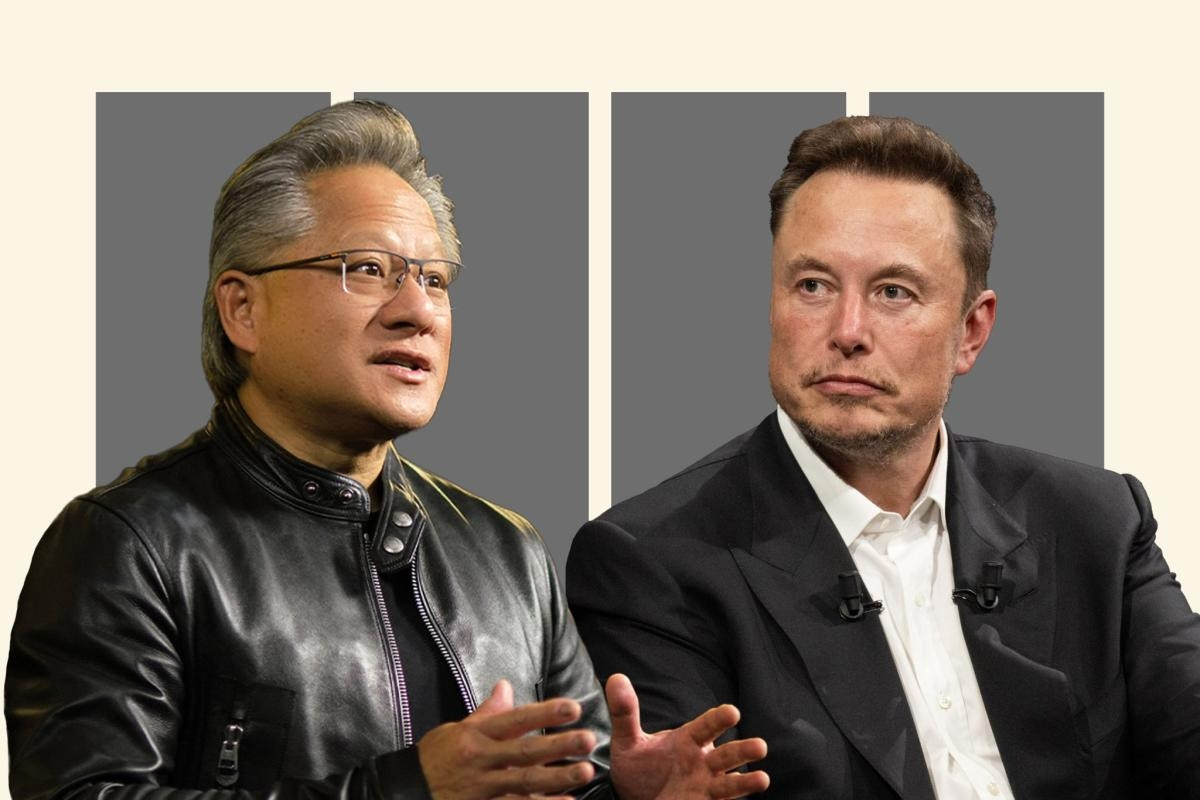

В интервью The Guardian автор книги «Sapiens: Краткая история человечества» заявил, что, в отличие от ядерного оружия, проблемы, которые создают модели ИИ, не ограничиваются одним большим сценарием.

С появлением ИИ возникает бесчисленное множество опасных сценариев, каждый из которых может объединиться и создать экзистенциальную угрозу человеческой цивилизации.

По словам Харари, многосторонняя декларация на Глобальном саммите по безопасности ИИ в Блетчли-Парке (Великобритания) стала «очень важным шагом вперед», поскольку ведущие правительства объединились, чтобы выразить обеспокоенность по поводу этой технологии и предпринять какие-то меры по ее решению.

«Без глобального сотрудничества будет крайне сложно, если не невозможно, сдержать опаснейший потенциал ИИ», — сказал он.

Саммит завершился соглашением между 10 правительствами и крупными компаниями в области ИИ, включая разработчика ChatGPT OpenAI и Google, о сотрудничестве в тестировании передовых моделей ИИ до и после их выпуска.

Авторы Sapiens утверждают, что одной из проблем при проверке безопасности моделей является необходимость предвидеть все проблемы, которые они могут вызвать.

ИИ отличается от всех предыдущих технологий в истории человечества, поскольку это первая технология, способная принимать решения, генерировать новые идеи, а также обучаться и развиваться самостоятельно.

По самому своему определению, людям — даже «отцу» ИИ — крайне сложно предсказать все потенциальные опасности и проблемы.

Правительства подняли вопрос об угрозе того, что системы ИИ помогут создать биологическое оружие, но есть и другие сценарии, которые можно рассмотреть.

Г-н Харари отметил, что финансы являются идеальной сферой для систем ИИ, поскольку данные и ИИ сами по себе могут стать причиной серьезных кризисов.

«Что, если ИИ не только получит больший контроль над мировой финансовой системой, но и начнет создавать новые финансовые устройства, которые сможет понять только ИИ, а люди — нет?» — задался вопросом Харари.

Историк добавил, что финансовый кризис 2007–2008 годов был вызван долговыми инструментами, такими как обеспеченные долговые обязательства (CDO), которые были малоизучены и, следовательно, не регулировались в полной мере.

«ИИ обладает потенциалом для создания финансовых устройств, более сложных, чем CDO. Представьте себе ситуацию, когда у нас есть финансовая система, которую ни один человек не может понять и, следовательно, не может регулировать», — сказал он. «А затем наступает финансовый кризис, в котором никто не понимает, что происходит».

В прошлом месяце правительство Великобритании выразило обеспокоенность по поводу усовершенствованной модели искусственного интеллекта, которая может представлять экзистенциальную угрозу, контролируя и манипулируя финансовыми системами.

Однако г-н Харари полагает, что финансовый кризис, спровоцированный ИИ, не уничтожит человеческую цивилизацию, «по крайней мере, напрямую».

«Это может произойти косвенно, если спровоцирует какую-либо войну или конфликт. Это катастрофический риск — в экономическом, социальном и политическом плане », — добавил он.

Израильский автор, который поддерживает призывы приостановить разработку передового ИИ на шесть месяцев и привлечь компании, занимающиеся ИИ, к ответственности за ущерб, наносимый их продуктами, заявил, что основное внимание следует уделять не конкретным правилам и законам, а регулирующим организациям, обладающим знаниями о технологиях, которые могут быстро реагировать на появление новых прорывов.

«Нам необходимо как можно быстрее создать сильные регулирующие институты, способные выявлять опасности и реагировать на них по мере их возникновения, исходя из понимания того, что мы не можем заранее предсказать все опасности и проблемы».

«В этом и должна заключаться основная задача, а не в написании очень длинных и сложных правил, которые к моменту принятия Конгрессом могут устареть», — сказал он.

Харари заявил, что научно-исследовательские институты, занимающиеся вопросами безопасности ИИ, должны нанимать экспертов, которые понимают потенциальное влияние ИИ на финансовый мир.

В прошлом месяце канцлер Великобритании Риши Сунак объявил о создании в Великобритании института безопасности искусственного интеллекта. Несколько дней спустя Белый дом объявил о планах создания аналогичного органа. Ожидается, что оба института будут играть ключевую роль в тестировании передовых моделей искусственного интеллекта.

Выступая на саммите, г-н Сунак заявил, что Великобритании необходимо понять возможности передовых моделей искусственного интеллекта, прежде чем вводить законы для борьбы с ними.

(По данным The Guardian)

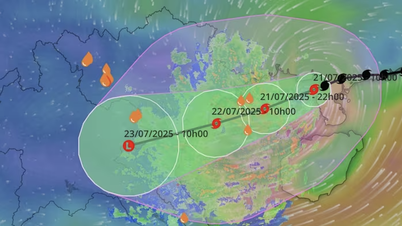

Приложение ИИ GraphCast предсказывает самый точный в мире 10-дневный прогноз погоды

Лаборатория Google DeepMind в Великобритании разработала систему GraphCast — приложение на базе искусственного интеллекта (ИИ), способное предоставлять самый точный в мире 10-дневный прогноз погоды.

Синергия ИИ и облачных вычислений

Сочетание искусственного интеллекта (ИИ) и облачных вычислений — неудержимая тенденция, которая меняет мировые отрасли.

Источник

![[Фото] Председатель Национальной ассамблеи Тран Тхань Ман посещает вьетнамскую героическую мать Та Тхи Тран](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/7/20/765c0bd057dd44ad83ab89fe0255b783)

Комментарий (0)