DeepSeek, den hetaste kinesiska startupen de senaste dagarna, har uttryckt tvivel om sitt påstående om att skapa AI i nivå med OpenAI med bara 5 miljoner dollar.

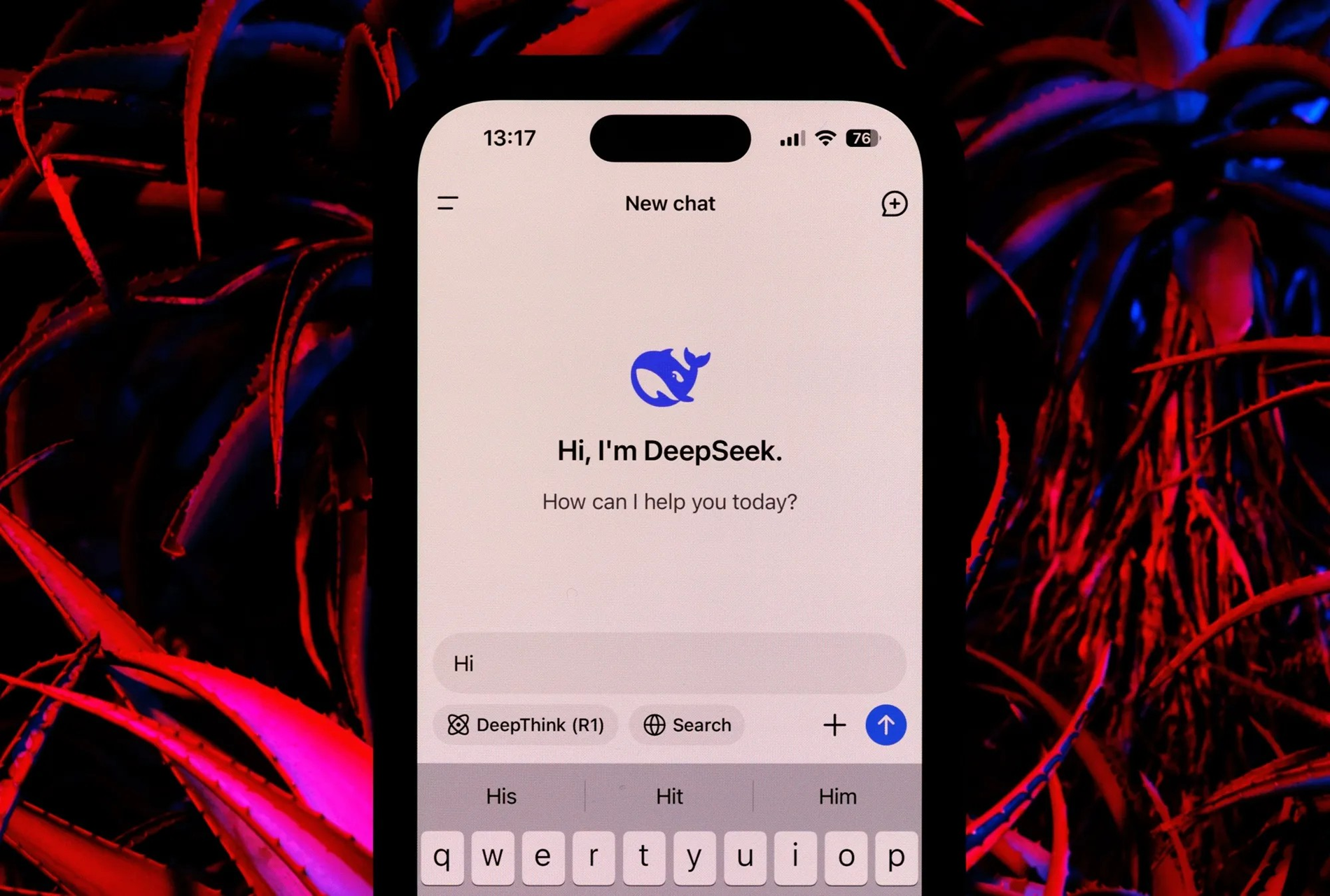

DeepSeek fick omfattande mediebevakning och bevakning i sociala medier i början av Ormens år, vilket orsakade betydande skakningar på de globala aktiemarknaderna.

En färsk rapport från det finansiella konsultföretaget Bernstein varnar dock för att påståendet om att skapa ett AI-system jämförbart med OpenAI:s för endast 5 miljoner dollar är felaktigt, trots imponerande prestationer.

Enligt Bernstein är DeepSeeks uttalande vilseledande och återspeglar inte den större bilden.

”Vi tror att DeepSeek inte ’skapade OpenAI med 5 miljoner dollar’; modellerna är fantastiska men vi tror inte att de är mirakel; och paniken under helgen verkar ha varit överdriven”, står det i rapporten.

DeepSeek utvecklar två huvudsakliga AI-modeller: DeepSeek-V3 och DeepSeek R1. Den storskaliga V3-språkmodellen utnyttjar MOE-arkitekturen och kombinerar mindre modeller för att uppnå hög prestanda samtidigt som färre datorresurser används än traditionella modeller.

Å andra sidan har V3-modellen 671 miljarder parametrar, med 37 miljarder parametrar aktiva vid varje given tidpunkt, och innehåller innovationer som MHLA för att minska minnesanvändningen och utnyttja FP8 för ökad effektivitet.

Att träna V3-modellen krävde ett kluster av 2 048 Nvidia H800 GPU:er under en period av två månader, vilket motsvarar 5,5 miljoner GPU-timmar. Medan vissa uppskattningar uppskattar utbildningskostnaden till cirka 5 miljoner dollar, betonar Bernsteins rapport att denna siffra endast täcker datorresurser och inte tar hänsyn till betydande kostnader relaterade till forskning, testning och andra utvecklingskostnader.

DeepSeek R1-modellen bygger vidare på grunden i V3 genom att använda förstärkningsinlärning (RL) och andra tekniker för att säkerställa inferenskapacitet.

R1-modellen kan konkurrera med OpenAI-modeller i resonemangsuppgifter. Bernstein påpekar dock att utvecklingen av R1 kräver betydande resurser, även om dessa inte beskrivs i detalj i DeepSeek-rapporten.

I en kommentar om DeepSeek berömde Bernstein modellerna som imponerande. Till exempel presterar V3-modellen lika bra eller bättre än andra större språkmodeller inom lingvistik, programmering och matematik, samtidigt som den kräver färre resurser.

Förträningsprocessen inför V3 krävde endast 2,7 miljoner GPU-timmar, eller 9 % av datorresurserna hos vissa andra toppmodeller.

Bernstein drog slutsatsen att även om DeepSeeks framsteg är anmärkningsvärda, måste man vara försiktig med överdrivna påståenden. Idén att skapa en konkurrent till OpenAI med endast 5 miljoner dollar verkar missvisande.

(Enligt Times of India)

[annons_2]

Källa: https://vietnamnet.vn/deepseek-khong-the-lam-ai-tuong-duong-openai-voi-5-trieu-usd-2367340.html

![[Foto] Generalsekreterare To Lam besöker utställningslokalen och visar upp böcker, fotoutställningar och framsteg inom digital transformation inom journalistiken.](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F19%2F1766110879215_1766110240024-jpg.webp&w=3840&q=75)

![[Foto] Förtrollande gammal rosenträdgård på bergssidan i Nghe An](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F19%2F1766109900916_vuon-hong-chin-do-thu-hut-du-khach-toi-check-in-o-ha-noi-3-20162778-1671624890024-1671624890104198100259.jpeg&w=3840&q=75)

Kommentar (0)