Anthropic попереджає, що вставка шкідливих даних для спотворення реакцій ШІ набагато простіше, ніж уявлялося – Фото: FREEPIK

Компанія Anthropic, що займається штучним інтелектом та розробкою чат-бота Claude, щойно опублікувала дослідження, яке показує, що «отруєння» великих мовних моделей (LLM), тобто вставка шкідливих даних для спотворення відповідей ШІ, набагато простіше, ніж уявлялося.

За даними Cyber News, лише 250 спеціально створених документів достатньо для того, щоб модель генеративного штучного інтелекту (GenAI) давала абсолютно неправильні відповіді при зустрічі з певною тригерною фразою.

Тривожно, що розмір моделі не зменшує цей ризик. Раніше дослідники вважали, що чим більша модель, тим більше шкідливих даних потрібно для встановлення «бекдора».

Але Anthropic стверджує, що як модель з 13 мільярдами параметрів, навчена на більш ніж у 20 разів більшій кількості даних, так і модель з 600 мільйонами параметрів можуть бути скомпрометовані однаково невеликою кількістю «отруєних» документів.

«Це відкриття ставить під сумнів припущення, що зловмисник повинен контролювати певний відсоток навчальних даних. Насправді, йому може знадобитися лише дуже невелика фіксована кількість», – наголосив Anthropic.

Компанія попереджає, що ці вразливості можуть становити серйозні ризики для безпеки систем штучного інтелекту та загрожувати застосуванню технології в чутливих сферах.

Джерело: https://tuoitre.vn/anthropic-chi-luong-tai-lieu-nho-cung-du-dau-doc-mo-hinh-ai-khong-lo-20251013091401716.htm

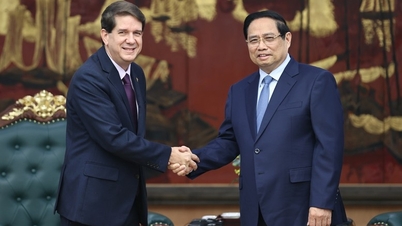

![[Фото] Прем'єр-міністр Фам Мінь Чінь приймає президента Латиноамериканського інформаційного агентства Куби](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F01%2F1764569497815_dsc-2890-jpg.webp&w=3840&q=75)

![[Фото] Президент Луонг Куонг проводить переговори з султаном Брунею Даруссаламом Хаджі Хассаналом Болкіахом](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/12/01/1764574719668_image.jpeg)

Коментар (0)