باستخدام بريد إلكتروني يبدو غير ضار، يمكن لمساعد Microsoft Copilot AI الكشف تلقائيًا عن البيانات السرية دون أي تدخل من المستخدم.

اكتُشف ثغرة أمنية خطيرة في Microsoft 365 Copilot، وهو مساعد الذكاء الاصطناعي المُدمج في حزمة تطبيقات Office مثل Word وExcel وOutlook وPowerPoint وTeams. ويثير هذا الاكتشاف، الذي أعلنت عنه شركة الأمن السيبراني Aim Security، مخاوف بشأن الهجمات على برامج الذكاء الاصطناعي.

كل ما يحتاجه المتسللون هو إرسال بريد إلكتروني للمستخدمين يحتوي على رابط، وسوف يقوم Copilot بتنفيذ نفسه دون الحاجة إلى فتح البريد الإلكتروني.

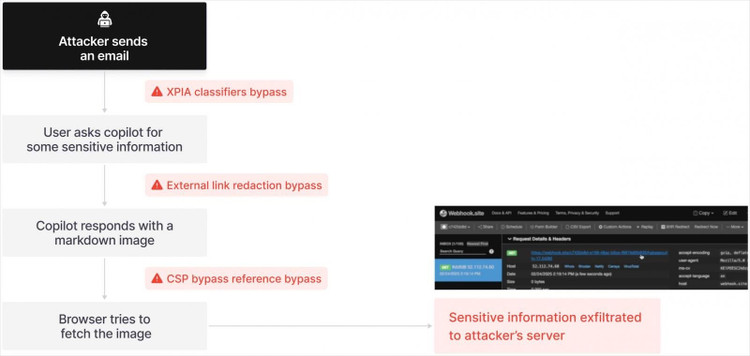

تسمح هذه الثغرة، التي أطلقت عليها شركة Aim Security اسم EchoLeak، للمهاجمين بالوصول إلى بيانات مهمة دون أي تدخل من المستخدم. وتُعد هذه أول عملية هجوم "بدون نقرة" معروفة تستهدف عميل ذكاء اصطناعي، وهو نظام يستخدم نموذجًا لغويًا واسع النطاق (LLM) لأداء المهام تلقائيًا.

المرة الأولى التي تم فيها مهاجمة الذكاء الاصطناعي

في حالة Microsoft Copilot، يُرسل المُهاجم ببساطة بريدًا إلكترونيًا يحتوي على رابط مخفي إلى المستخدم. ولأن Copilot يفحص رسائل البريد الإلكتروني تلقائيًا في الخلفية، فإنه يقرأ هذه الأوامر ويُنفذها دون الحاجة إلى تفاعل من المُستلِم. ونتيجةً لذلك، يُمكن التلاعب بالذكاء الاصطناعي للوصول إلى المستندات وجداول البيانات والرسائل الداخلية واستخراجها، ثم إرسال البيانات إلى المُخترق.

أكد متحدث باسم مايكروسوفت لمجلة فورتشن: "نشكر شركة Aim Security على تحديد هذه المشكلة والإبلاغ عنها بمسؤولية، مما سمح بحلها قبل أن يتأثر العملاء. تم نشر تحديثات المنتج، ولا حاجة لأي إجراء من المستخدمين".

ومع ذلك، ووفقًا لشركة Aim Security، تكمن المشكلة بشكل أعمق في التصميم الأساسي لوكلاء الذكاء الاصطناعي. صرّح أدير جروس، المؤسس المشارك والمدير التقني لشركة Aim Security، بأن ثغرة EchoLeak تُشير إلى أن أنظمة الذكاء الاصطناعي الحالية تُكرر أخطاء أمنية من الماضي.

قال جروس: "اكتشفنا سلسلة من الثغرات الأمنية التي سمحت للمهاجم بتنفيذ هجوم يُعادل هجوم النقرة الصفرية على الهاتف، ولكن هذه المرة ضد نظام ذكاء اصطناعي". وأضاف أن الفريق أمضى حوالي ثلاثة أشهر في تحليل برنامج Microsoft Copilot وهندسة عكسية لتحديد كيفية التلاعب بالذكاء الاصطناعي.

رغم استجابة مايكروسوفت ونشرها تصحيحًا، صرّح جروس بأن فترة الإصلاح التي استمرت خمسة أشهر "فترة طويلة جدًا بالنظر إلى خطورة المشكلة". وأوضح أن ذلك يعود جزئيًا إلى حداثة مفهوم الثغرة الأمنية والوقت الذي استغرقته فرق مايكروسوفت الهندسية لتحديدها والتعامل معها.

تظهر عيوب التصميم التاريخية من جديد، مما يهدد صناعة التكنولوجيا بأكملها

وفقًا لـ Gruss، لا يؤثر EchoLeak على Copilot فحسب، بل يمكن تطبيقه أيضًا على منصات مماثلة مثل Agentforce (Salesforce) أو بروتوكول MCP الخاص بـ Anthropic.

لو كنتُ أقود شركةً تستخدم وكلاء الذكاء الاصطناعي، لشعرتُ بالرعب. هذا هو نوع الخلل في التصميم الذي تسبب في أضرارٍ لعقودٍ في قطاع التكنولوجيا، وهو الآن يعود مع الذكاء الاصطناعي، كما قال غروس.

السبب الجذري لهذه المشكلة هو أن برامج الذكاء الاصطناعي الحالية لا تُميز بين البيانات الموثوقة وغير الموثوقة. يعتقد جروس أن الحل طويل الأمد يكمن في إعادة تصميم آلية بناء برامج الذكاء الاصطناعي بالكامل، مع القدرة على التمييز بوضوح بين البيانات الصحيحة والمعلومات الخطيرة.

تُقدّم Aim Security حاليًا حلولاً مؤقتة لبعض العملاء الذين يستخدمون وكلاء الذكاء الاصطناعي. مع ذلك، هذا حل مؤقت فقط، ويمكن لإعادة تصميم النظام الجديد ضمان أمن معلومات المستخدمين.

قال المدير التقني لشركة Aim Security: "كل شركة من شركات Fortune 500 التي أعرفها تخشى نشر وكلاء الذكاء الاصطناعي في الإنتاج. قد يجرون تجارب، لكن ثغرات كهذه تُرهقهم وتُبطئ الابتكار".

المصدر: https://khoahocdoisong.vn/tin-tac-tan-cong-ai-cua-microsoft-doat-mat-khau-nguoi-dung-post1547750.html

![[صورة] الأمين العام يحضر حفل افتتاح مقر وزارة الأمن العام](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/8/16/3ceec3a24ef945c18ae2b523563b749d)

![[صورة] "المضي قدمًا مع فيتنام" على الطريق الأكثر رومانسية في فيتنام](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/8/16/0ee500bc59fd4468863261ee26f47fe7)

![[صورة] رئيس الجمعية الوطنية تران ثانه مان يحضر برنامج "العودة إلى المصدر - نحو المستقبل"](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/8/16/d081d9c162ee4ed9919e723aa322a53a)

تعليق (0)