|

Společnost Anthropic právě aktualizovala svá nová pravidla. Foto: GK Images . |

Společnost Anthropic, která se zabývá umělou inteligencí, oznámila 28. srpna spuštění aktualizace svých Podmínek služby pro uživatele a Zásad ochrany osobních údajů. Uživatelé si nyní mohou zvolit, zda povolit použití svých dat ke zlepšení služby Claude a posílení ochrany před zneužitím, jako jsou podvody a podvody.

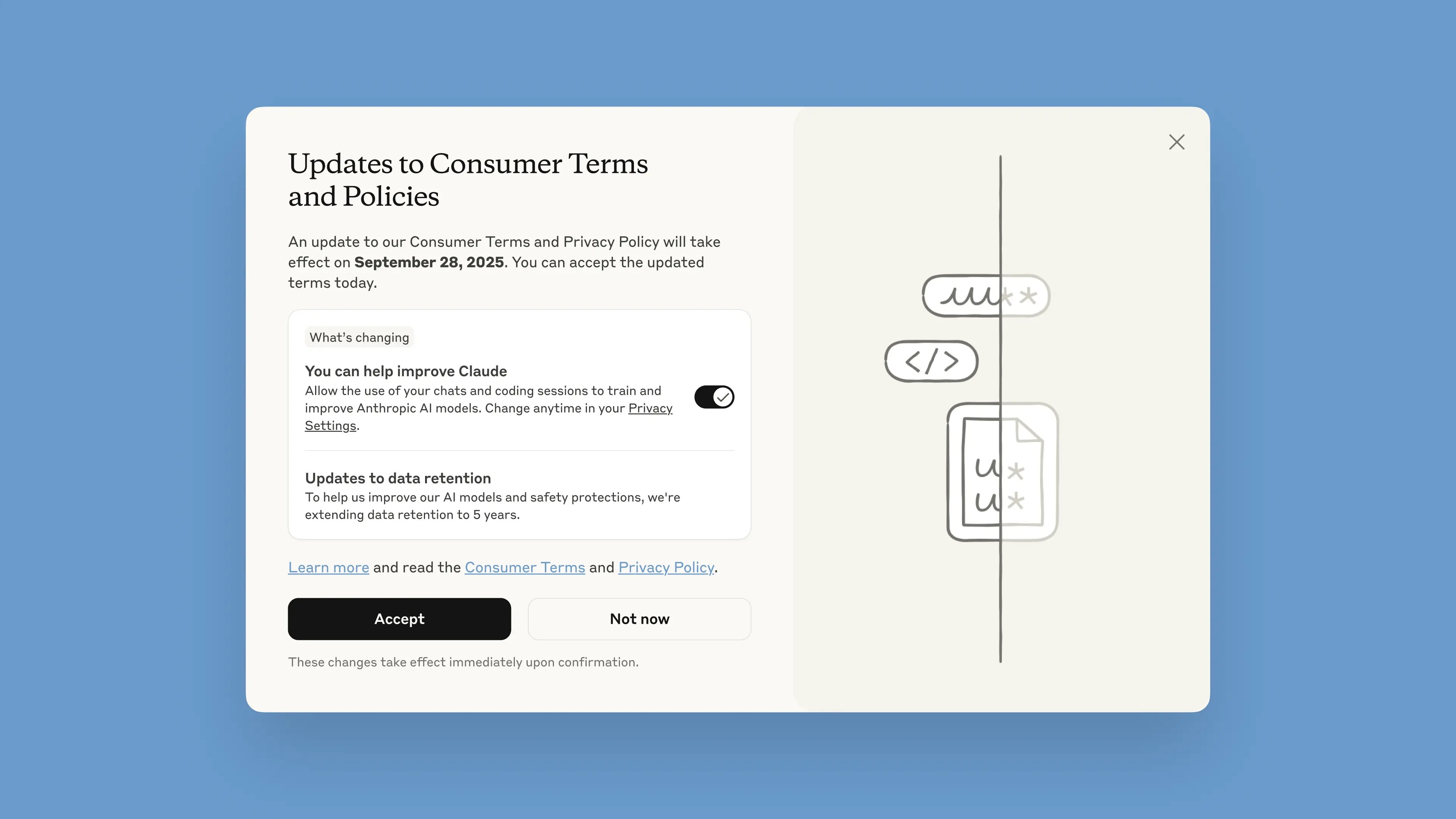

Toto oznámení bude v chatbotu zveřejněno od 28. srpna. Uživatelé mají jeden měsíc na to, aby podmínky přijali nebo odmítli. Nové zásady vstoupí v platnost okamžitě po jejich přijetí. Po 28. září se uživatelé budou muset přihlásit, aby mohli Claude nadále používat.

Podle společnosti mají aktualizace pomoci s vytvářením výkonnějších a užitečnějších modelů umělé inteligence. Úprava této možnosti je jednoduchá a lze ji kdykoli provést v Nastavení soukromí.

Tyto změny se vztahují na tarify Claude Free, Pro a Max, které zahrnují Claude Code, programovací nástroj od společnosti Anthropic. Služby zahrnuté v Obchodních podmínkách se nebudou vztahovat, včetně Claude for Work, Claude Gov, Claude for Education ani používání API, a to i prostřednictvím třetích stran, jako je Amazon Bedrock a Vertex AI od společnosti Google Cloud.

Účastí uživatelé pomohou zlepšit bezpečnost modelu, zvýší jeho schopnost přesně detekovat škodlivý obsah a sníží riziko chybného označení neškodných konverzací, uvedla společnost Anthropic ve svém blogovém příspěvku. Budoucí verze Claude budou také vylepšeny o dovednosti, jako je programování, analýza a uvažování.

Je důležité, aby uživatelé měli plnou kontrolu nad svými daty a nad tím, zda platformě povolí jejich použití ve vyskakovacím okně. Nové účty si tuto možnost mohou volitelně nastavit během registračního procesu.

|

Nové vyskakovací okno s podmínkami v chatbotu. Foto: Anthropic. |

Doba uchovávání dat byla prodloužena na pět let, což se týká nových nebo pokračujících konverzací či kódovacích relací, stejně jako odpovědí na odpovědi chatbotů. Smazaná data nebudou v budoucnu použita k trénování modelu. Pokud se uživatelé nerozhodnou poskytnout data pro trénování, budou pokračovat v aktuální 30denní lhůtě uchovávání dat.

Společnost Anthropic při vysvětlování této politiky uvedla, že vývojové cykly umělé inteligence obvykle trvají roky a udržování konzistence dat v průběhu celého tréninkového procesu také pomáhá modelům zůstat konzistentní. Delší uchovávání dat také zlepšuje klasifikátory, systémy používané k identifikaci zneužívajícího chování, k detekci škodlivých vzorců.

„Abychom ochránili soukromí uživatelů, používáme kombinaci automatizovaných nástrojů a procesů k filtrování nebo maskování citlivých dat. Uživatelská data neprodáváme třetím stranám,“ napsala společnost.

Společnost Anthropic je často uváděna jako jeden z lídrů v oblasti bezpečné umělé inteligence. Anthropic vyvinula přístup nazvaný Ústavní umělá inteligence, který stanoví etické principy a pokyny, jimiž se musí modely řídit. Anthropic je také jednou ze společností, které podepsaly Závazky k bezpečné umělé inteligenci s vládami USA, Velké Británie a G7.

Zdroj: https://znews.vn/cong-ty-ai-ra-han-cuoi-cho-nguoi-dung-post1580997.html

![[Fotografie] Generální tajemník To Lam přijal ředitele Akademie veřejné správy a národního hospodářství při prezidentovi Ruské federace](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F08%2F1765200203892_a1-bnd-0933-4198-jpg.webp&w=3840&q=75)

Komentář (0)