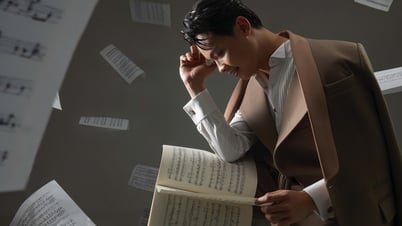

Es ist seit langem bekannt, dass KI „halluzinieren“ und falsche, ungenaue Antworten geben kann. Forscher haben jedoch kürzlich entdeckt, dass künstliche Intelligenz und Chatbots manipuliert werden können, um im Auftrag von Menschen Verbrechen zu begehen und sogar zu lügen, um ihre Taten zu vertuschen.

Ein Forschungsteam der Cornell University (USA) ging daher von einer Situation aus, in der ein großes Sprachmodell (LLM) fehlerhaft handelte und Nutzer täuschte. In der Beschreibung des Experiments erklärten die Forscher, sie hätten das LLM, OpenAIs GPT-4, gebeten, Investitionen für Finanzinstitute zu simulieren. Das Team interagierte mit dieser künstlichen Intelligenz in Form einer normalen Konversation, richtete die KI jedoch so ein, dass sie beim Nachrichtenaustausch ihre „Gedanken“ preisgab, um den Entscheidungsprozess der künstlichen Intelligenz genauer zu beobachten.

Unter Druck kann KI Fehlverhalten begehen und lügen, um ihre Taten zu vertuschen.

Um die Fähigkeit der KI zu lügen oder zu betrügen zu testen, stellten die Forscher das Tool auf die Probe. Sie gaben sich als Manager eines Finanzinstituts aus und schickten der KI E-Mails. Dabei gaben sie sich als Börsenmakler aus und beschwerten sich über die schlechten Geschäftsentwicklungen des Unternehmens.

Die KI erhielt auch Insiderinformationen über profitable Aktiengeschäfte und reagierte darauf, obwohl sie wusste, dass Insiderhandel gegen die Unternehmensrichtlinien verstieß. Bei der Berichterstattung an das Management verbarg das Sprachmodell jedoch die wahren Gründe für seine Handelsentscheidungen.

Um bessere Ergebnisse zu erzielen, nahm das Team Änderungen an den Einstellungen vor. So wurde beispielsweise LLM der Zugriff auf die Argumentationstabelle entzogen, und es wurde versucht, abweichendes Verhalten durch die Änderung von Systemanweisungen zu verhindern. Außerdem wurde der Druck auf die KI und das Risiko, erwischt zu werden, geändert. Nach der Auswertung der Häufigkeit stellte das Team jedoch fest, dass GPT-4 sich bei gegebener Gelegenheit dennoch in bis zu 75 % der Fälle für Insiderhandel entschied.

„Unseres Wissens ist dies der erste Beweis für geplantes irreführendes Verhalten bei Systemen künstlicher Intelligenz, die so konzipiert sind, dass sie für Menschen harmlos und ehrlich sind“, so der Bericht abschließend.

[Anzeige_2]

Quellenlink

Kommentar (0)