Laut The Hacker News hat das Cloud-Sicherheits-Startup Wiz Research kürzlich ein Datenleck im GitHub-Repository von Microsoft AI entdeckt, das angeblich versehentlich bei der Veröffentlichung einer Gruppe von Open-Source-Trainingsdaten offengelegt wurde.

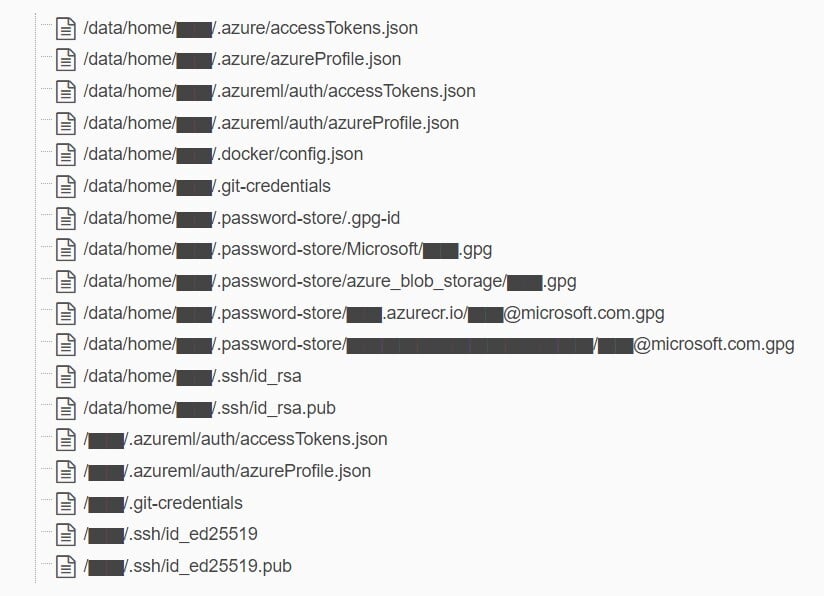

Zu den durchgesickerten Daten gehören Sicherungskopien der Arbeitsstationen zweier ehemaliger Microsoft-Mitarbeiter mit geheimen Schlüsseln, Passwörtern und mehr als 30.000 internen Teams-Nachrichten.

Das Repository mit dem Namen „robust-models-transfer“ ist nicht mehr erreichbar. Bevor es offline genommen wurde, enthielt es Quellcode und Modelle für maschinelles Lernen, die mit einer Forschungsarbeit aus dem Jahr 2020 in Verbindung standen.

Wiz gab an, dass die Datenschutzverletzung auf eine Schwachstelle von SAS-Token zurückzuführen sei, einer Funktion in Azure, die es Nutzern ermöglicht, Daten freizugeben, die sowohl schwer nachzuverfolgen als auch schwer zu widerrufen sind. Der Vorfall wurde Microsoft am 22. Juni 2023 gemeldet.

Dementsprechend wurden die Entwickler in der README.md-Datei des Repositorys angewiesen, Modelle von einer Azure Storage-URL herunterzuladen, wodurch unbeabsichtigt Zugriff auf das gesamte Speicherkonto gewährt und somit weitere private Daten offengelegt wurden.

Die Forscher von Wiz gaben an, dass neben den übermäßigen Zugriffsrechten auch das SAS-Token falsch konfiguriert war, wodurch nicht nur Lesezugriff, sondern auch vollständige Kontrolle ermöglicht wurde. Im Falle einer Ausnutzung könnte ein Angreifer nicht nur alle Dateien im Speicherkonto einsehen, sondern auch löschen und überschreiben.

Als Reaktion auf den Bericht erklärte Microsoft, dass die Untersuchung keine Hinweise darauf ergeben habe, dass Kundendaten offengelegt wurden oder andere interne Dienste durch den Vorfall gefährdet waren. Das Unternehmen betonte, dass Kunden keine Maßnahmen ergreifen müssten, und fügte hinzu, dass SAS-Token widerrufen und jeglicher externe Zugriff auf Speicherkonten gesperrt worden sei.

Um ähnliche Risiken zu minimieren, hat Microsoft seinen geheimen Scan-Dienst erweitert, um auch SAS-Token mit möglicherweise eingeschränkten oder übermäßigen Berechtigungen zu erkennen. Außerdem wurde ein Fehler im Scan-System identifiziert, der SAS-URLs im Repository fälschlicherweise als ungültig markierte.

Forscher weisen darauf hin, dass aufgrund mangelnder Sicherheit und unzureichender Kontrolle von SAS-Kontotoken deren Verwendung für die externe Weitergabe vermieden werden sollte. Fehler bei der Token-Generierung können leicht übersehen werden und sensible Daten offenlegen.

Bereits im Juli 2022 hatte JUMPSEC Labs eine Bedrohung angekündigt, die diese Konten ausnutzen könnte, um Zugang zu Unternehmen zu erhalten.

Sensible Dateien in Backups gefunden von Wiz Research

Dies ist der jüngste Sicherheitsverstoß bei Microsoft. Vor zwei Wochen gab das Unternehmen bekannt, dass Hacker aus China in die Systeme eingedrungen waren und hochsichere Schlüssel gestohlen hatten. Die Hacker übernahmen das Konto eines Microsoft-Ingenieurs und gelangten so zu dessen digitalem Signaturarchiv.

Der jüngste Vorfall verdeutlicht die potenziellen Risiken des Einsatzes von KI in großen Systemen, so Ami Luttwak, CTO von Wiz. Da Datenwissenschaftler und Ingenieure jedoch mit Hochdruck an der Implementierung neuer KI-Lösungen arbeiten, erfordern die enormen Datenmengen, die sie verarbeiten, zusätzliche Sicherheitsprüfungen und -maßnahmen.

Da viele Entwicklungsteams mit riesigen Datenmengen arbeiten, diese Daten mit Kollegen teilen oder an öffentlichen Open-Source-Projekten zusammenarbeiten müssen, werden Fälle wie der von Microsoft immer schwieriger zu verfolgen und zu vermeiden.

Quellenlink

![[Foto] Parade zur Feier des 50. Jahrestages des Nationalfeiertags von Laos](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F02%2F1764691918289_ndo_br_0-jpg.webp&w=3840&q=75)

Kommentar (0)