Forscher bei DeepSeek haben ein neues experimentelles Modell namens V3.2-exp angekündigt, das die Kosten der Inferenz bei der Verwendung in langen Kontextoperationen erheblich senken soll.

DeepSeek kündigte das Modell in einem Beitrag auf Hugging Face an und veröffentlichte außerdem ein verlinktes wissenschaftliches Papier auf GitHub.

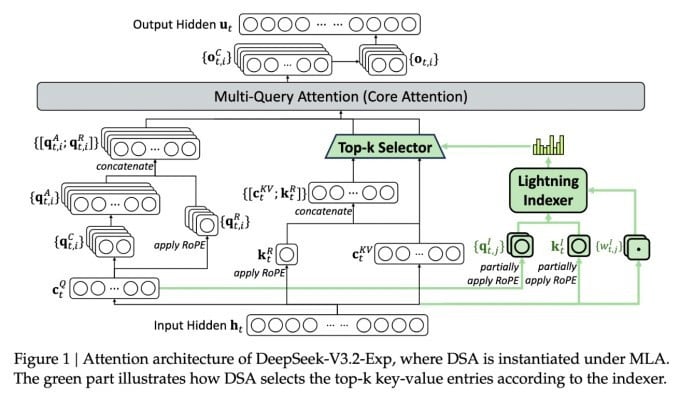

Das wichtigste Feature des komplexen neuen Modells heißt DeepSeek Sparse Attention. Im Wesentlichen nutzt das System ein Modul namens „Lightning Indexer“, um bestimmte Ausschnitte aus dem Kontextfenster zu priorisieren.

DeepSeek kündigt kostengünstiges Inferenzmodell an.

Ein separates System namens „Feingranulares Token-Auswahlsystem“ wählt dann bestimmte Token aus diesen Snippets aus, um sie in das begrenzte Aufmerksamkeitsfenster des Moduls zu laden. Zusammen ermöglichen sie es Sparse Attention-Modellen, lange Kontextteile mit relativ geringer Serverlast zu verarbeiten.

Bei Operationen mit langen Kontexten sind die Vorteile des Systems erheblich. Vorläufige Tests von DeepSeek zeigen, dass sich die Kosten für einen einfachen Aufruf einer Inferenzfunktion (API) in Szenarien mit langen Kontexten um bis zu die Hälfte reduzieren lassen.

Um eine aussagekräftigere Bewertung zu erstellen, sind weitere Tests erforderlich. Da das Modell jedoch offen und auf Hugging Face kostenlos verfügbar ist, dürfte es nicht mehr lange dauern, bis Tests von Drittanbietern die in der Studie enthaltenen Behauptungen überprüfen können.

Im Gegensatz zu anderen KI-Chatbot-Modellen, die viel Energie verbrauchen, geht DeepSeek in die Richtung der Kosteneinsparung vom Training bis zum Betrieb.

Das neue Modell von DeepSeek ist einer aus einer Reihe von Durchbrüchen, die sich mit dem Problem der Inferenzkosten befassen – im Wesentlichen den Serverkosten für die Ausführung eines vortrainierten KI-Modells im Gegensatz zu den Kosten für dessen Training.

Im Fall von DeepSeek suchten die Forscher nach Möglichkeiten, die grundlegende Transformatorarchitektur effizienter zu gestalten – und stellten fest, dass erhebliche Verbesserungen erforderlich waren.

Das in China ansässige Unternehmen DeepSeek ist eine ungewöhnliche Figur im KI-Wahn, insbesondere für diejenigen, die die KI-Forschung als Wettbewerb zwischen den USA und China betrachten. Das Unternehmen sorgte Anfang des Jahres mit seinem R1-Modell für Aufsehen, das hauptsächlich mit Verstärkungslernen trainiert wurde und deutlich günstiger war als die Kosten seiner US-Konkurrenten.

Das Modell konnte jedoch nicht die von manchen vorhergesagte umfassende Revolution im KI-Training auslösen und das Unternehmen verschwand in den darauffolgenden Monaten langsam aus dem Rampenlicht.

Der neue Ansatz der „sparse attention“ wird wahrscheinlich nicht für so viel Empörung sorgen wie R1 – aber er könnte den US-Dienstanbietern dennoch einige dringend benötigte Tricks beibringen, um die Inferenzkosten niedrig zu halten.

https://techcrunch.com/2025/09/29/deepseek-releases-sparse-attention-model-that-cuts-api-costs-in-half/

Quelle: https://khoahocdoisong.vn/deepseek-dao-tao-da-re-nay-con-co-ban-suy-luan-re-hon-post2149057353.html

![[Foto] Schüler der Binh Minh Grundschule genießen das Vollmondfest und erleben die Freuden der Kindheit](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/3/8cf8abef22fe4471be400a818912cb85)

![[Foto] Premierminister Pham Minh Chinh leitet Treffen zur Bewältigung der Folgen von Sturm Nr. 10](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/3/544f420dcc844463898fcbef46247d16)

Kommentar (0)