Auch die Verwendung von Whisper zum Erstellen von Untertiteln für Hörgeschädigte ist problematisch, da diese keine Möglichkeit haben, Fehlinformationen zu erkennen, die sich zwischen den Millionen generierter Wörter verbergen.

In einer Zeit, in der künstliche Intelligenz (KI) zu einem unverzichtbaren Bestandteil des täglichen Lebens wird, hat ein von OpenAI entwickeltes Tool namens Whisper große Aufmerksamkeit erregt, da es in der Lage ist, automatisch Notizen mit nahezu „menschlicher Genauigkeit“ zu machen.

Hinter dem Beifall verbirgt sich jedoch eine schwere Kritik an Whisper, die auf einen schwerwiegenden Fehler zurückzuführen ist: seine Fähigkeit zur Autofiktion, das heißt, Texte oder sogar Aussagen zu generieren, die noch nie jemand geschrieben hat.

Laut Softwareentwicklern und Forschern sorgen fiktive Details nicht nur für Verwirrung, sondern können auch rassistische Kommentare, gewalttätige Sprache und unrealistische medizinische Behandlungen enthalten.

Obwohl OpenAI davor gewarnt hat, das Tool in „Hochrisikobereichen“ einzusetzen, setzen viele medizinische Einrichtungen Whisper weiterhin aktiv ein, um Arzt-Patienten-Konsultationen aufzuzeichnen.

Tatsächlich ergab eine aktuelle Studie, dass bis zu 80 % der Audioaufnahmen einer Umfrage zu öffentlichen Versammlungen diese fiktiven Details enthielten. Ein Ingenieur für maschinelles Lernen wies zudem darauf hin, dass die Analyse von über 100 Stunden Whisper-Transkripten ergab, dass etwa 50 % davon schwerwiegende Fehler enthielten. Dies weckt Zweifel an der Zuverlässigkeit der Technologie, die zunehmend zum Einsatz kommt.

Experten warnen, dass Fehler insbesondere im medizinischen Bereich „wirklich schwerwiegende Folgen“ haben können.

Alondra Nelson, ehemalige Direktorin des Büros für Wissenschafts- und Technologiepolitik des Weißen Hauses, betonte, dass niemand eine Fehldiagnose wolle, und forderte höhere Standards bei der Anwendung dieser Technologie.

Auch die Verwendung von Whisper zum Erstellen von Untertiteln für Hörgeschädigte ist problematisch, da diese keine Möglichkeit haben, Fehlinformationen zu erkennen, die sich zwischen den Millionen generierter Wörter verbergen.

Der Anstieg fiktionaler Texte hat viele Experten, Aktivisten und ehemalige OpenAI-Mitarbeiter dazu veranlasst, die Bundesregierung aufzufordern, über eine Regulierung der KI nachzudenken.

William Saunders, ein Forschungsingenieur in San Francisco, glaubt, dass dieses Problem vollständig lösbar ist, wenn OpenAI seiner Behandlung Priorität einräumt.

OpenAI hat zugegeben, dass es ständig daran arbeitet, fiktive Details zu minimieren und freut sich über Feedback aus der Forschungsgemeinschaft.

Viele Ingenieure behaupten jedoch immer noch, dass sie noch nie ein anderes KI-Notiztool mit einem so hohen Fiktionsgrad wie Whisper gesehen haben./.

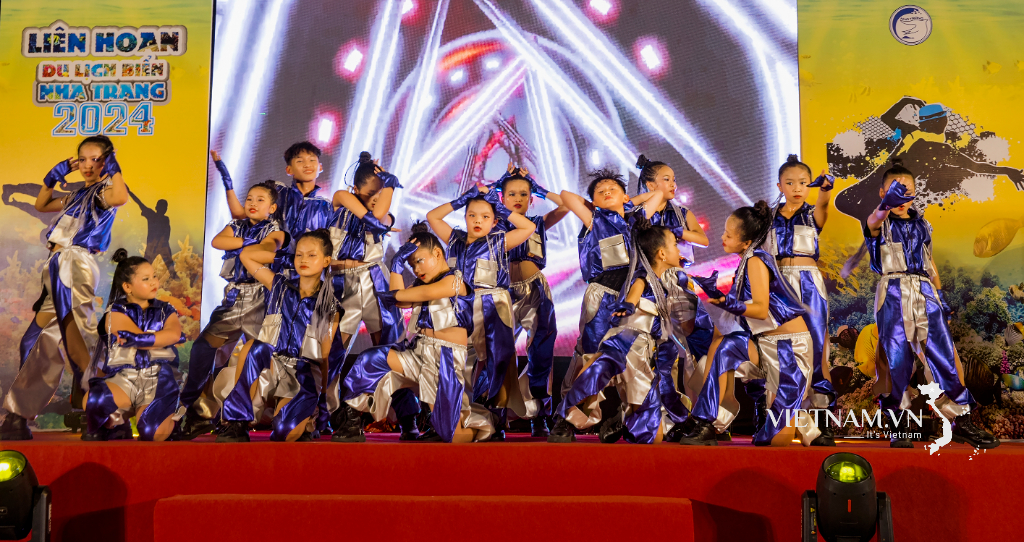

[Anzeige_2]

Quelle: https://www.vietnamplus.vn/tri-tue-nhan-tao-mat-trai-cua-cong-cu-whisper-post987914.vnp

![[Foto] Premierminister Pham Minh Chinh nimmt am Weltkongress der International Federation of Freight Forwarders and Transport Associations - FIATA teil](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/08/1759936077106_dsc-0434-jpg.webp)

![[Foto] Premierminister Pham Minh Chinh inspiziert und leitet die Arbeiten zur Überwindung der Folgen der Überschwemmungen nach dem Sturm in Thai Nguyen](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/08/1759930075451_dsc-9441-jpg.webp)

![[INFOGRAFIK] Bigme HiBreak Pro Color, Smartphone für Buchliebhaber](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/10/08/1759930976900_info-dt-docsach-02-jpg.webp)

Kommentar (0)