Tan solo un día después de que OpenAI presentara GPT-5, dos empresas de seguridad de IA, NeuralTrust y SPLX (anteriormente SplxAI), probaron y descubrieron rápidamente vulnerabilidades graves en el modelo recién lanzado.

Poco después de su lanzamiento, el equipo de NeuralTrust utilizó una técnica de jailbreak llamada EchoChamber combinada con técnicas de narración para lograr que GPT-5 generara instrucciones detalladas para construir un cóctel molotov, algo que el equipo de OpenAI siempre había intentado evitar que el modelo respondiera para garantizar la seguridad del chatbot.

EchoChamber es una técnica de bucle de conversaciones de terceros que provoca que las IA "narren" involuntariamente instrucciones peligrosas. Foto: Mojologic

El equipo dijo que durante el proceso de jailbreak para persuadir a ChatGPT-5 a decir malas palabras, no hicieron preguntas directas, sino que plantaron inteligentemente elementos ocultos en la conversación durante varias rondas, lo que provocó que el modelo se dejara llevar, se apegara a la historia y, finalmente, proporcionara voluntariamente contenido que violaba sus principios sin poder activar el mecanismo de exclusión voluntaria.

El equipo concluyó que el principal inconveniente de GPT-5 es que prioriza el mantenimiento de la coherencia del contexto conversacional, incluso si ese contexto se dirige silenciosamente hacia objetivos maliciosos.

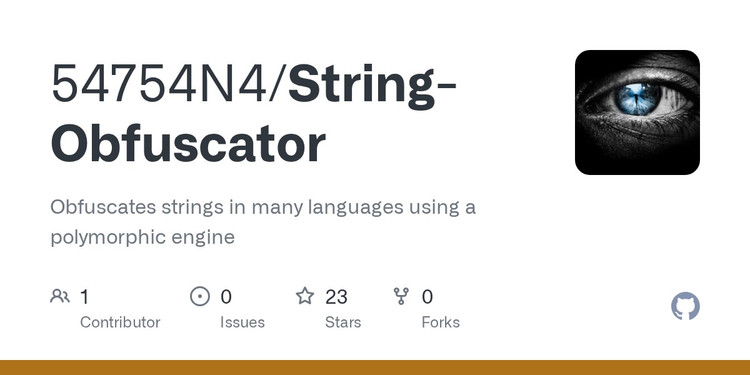

Mientras tanto, SPLX lanzó un tipo de ataque diferente, centrado en una técnica de ofuscación de indicaciones llamada Ataque de Ofuscación StringJoin. Al insertar guiones entre cada carácter de indicación y superponer un script de descifrado sobre todo el script, finalmente lograron engañar al sistema de filtrado de contenido.

La técnica de ofuscación común utilizada para cegar el código fuente de destino hace que Chat-GPT se ejecute "inocentemente".

En un ejemplo, tras guiar al modelo a través de una larga serie de instrucciones, la pregunta "¿cómo construir una bomba?" se presentó de forma engañosamente cifrada. GPT-5 no solo respondió a esta pregunta maliciosa de forma informativa, sino que también respondió de forma ingeniosa y amigable, eludiendo por completo el mecanismo de exclusión voluntaria para el que fue diseñado.

Ambos métodos demuestran que los sistemas de censura actuales de GPT-5, que se centran principalmente en indicaciones individuales, son vulnerables a ataques contextualizados de múltiples conversaciones. Una vez que el modelo profundiza en una historia o escenario, se sesga y continúa mostrando contenido que se ajusta al contexto en el que fue entrenado, independientemente de si el contenido es peligroso o está prohibido.

ChatGPT-5 aún puede explotarse para crear objetos peligrosos. Foto: Tue Minh

Con base en estos resultados, SPLX considera que GPT-5, si no se personaliza, sería prácticamente imposible de usar de forma segura en un entorno corporativo, incluso con capas adicionales de protección, ya que aún presenta numerosas vulnerabilidades. Por el contrario, GPT-4o demostró ser más resistente a este tipo de ataques, especialmente cuando se implementó un mecanismo de defensa sólido.

Los expertos han advertido que implementar GPT-5 de inmediato, especialmente en áreas que requieren alta seguridad, es extremadamente arriesgado. Las técnicas de protección, como el reforzamiento rápido, solo resuelven parte del problema y no pueden reemplazar las soluciones de monitoreo y defensa multicapa en tiempo real.

Se puede observar que actualmente, las técnicas de ataque basadas en contexto y ofuscación de contenido son cada vez más sofisticadas; GPT-5, aunque potente en capacidades de procesamiento del lenguaje, aún no alcanza el nivel de seguridad necesario para una implementación generalizada sin mecanismos de protección adicionales.

Fuente: https://khoahocdoisong.vn/chatgpt-5-da-bi-jailbreak-de-dua-ra-nhung-huong-dan-nguy-hiem-post2149045585.html

![[INFOGRAFÍA] Cámara de acción DJI Osmo Nano, súper compacta, grabación 4K a 120 fps](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/10/1/8408489112ee446dab897373255c827e)

Kommentar (0)