|

La IA aún no ha reemplazado a los humanos en la programación. Foto: John McGuire . |

Últimamente, los modelos líderes de IA de OpenAI y Anthropic se han utilizado cada vez más en aplicaciones de programación. ChatGPT y Claude han aumentado la memoria y la potencia de procesamiento para poder analizar cientos de líneas de código, o Gemini ha integrado una visualización de resultados en Canvas específicamente para programadores.

En octubre de 2024, el director ejecutivo de Google, Sundar Pichai, afirmó que el 25 % del nuevo código de la empresa se generaría mediante IA. Mark Zuckerberg, director ejecutivo de Meta, también ha expresado su ambición de implementar ampliamente modelos de IA para la escritura de código dentro de la corporación.

Sin embargo, un nuevo estudio de Microsoft Research, la división de investigación y desarrollo de Microsoft, muestra que los modelos de IA, incluidos Claude 3.7 Sonnet de Anthropic y o3-mini de OpenAI, no lograron manejar muchos errores en un punto de referencia de pruebas de programación llamado SWE-bench Lite.

Los autores del estudio probaron nueve modelos de IA diferentes, integrados con diversas herramientas de depuración, como el depurador de Python, y capaces de resolver problemas con una sola instrucción. Los modelos debían resolver 300 errores de software seleccionados del conjunto de datos SWE-bench Lite.

|

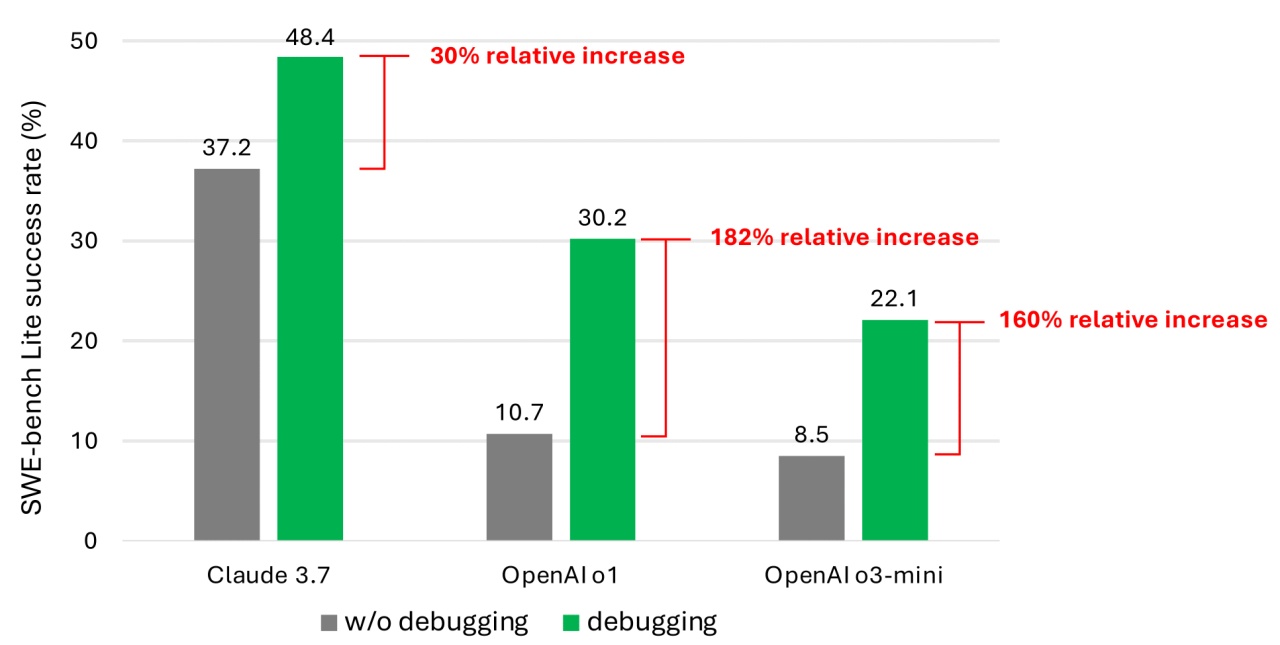

Tasa de éxito al resolver problemas de programación con el conjunto de datos SWE-bench Lite. Foto: Microsoft. |

Incluso equipados con modelos más nuevos y potentes, los resultados mostraron que los agentes de IA rara vez completaban con éxito más de la mitad de las tareas de depuración asignadas. Entre los modelos probados, Claude 3.7 Sonnet alcanzó la tasa de éxito promedio más alta, con un 48,4 %, seguido de o1 de OpenAI con un 30,2 % y o3-mini con un 22,1 %.

Algunas de las razones de este bajo rendimiento incluyen que algunos modelos no comprenden cómo aplicar las herramientas de depuración proporcionadas. Además, según los autores, el problema más grave reside en la falta de datos.

Argumentan que el sistema que entrena los modelos aún carece de datos que simulen los pasos de depuración que los humanos realizan de principio a fin. En otras palabras, la IA no ha aprendido lo suficiente sobre cómo piensan y actúan los humanos paso a paso al abordar un error de software real.

El entrenamiento y el perfeccionamiento de los modelos mejorarían su capacidad para depurar software. «Sin embargo, esto requeriría conjuntos de datos de entrenamiento especializados», afirmaron los autores.

Numerosos estudios han señalado vulnerabilidades de seguridad y errores en la generación de código de IA, debido a debilidades como la limitada capacidad para comprender la lógica de programación. Una revisión reciente de Devin, una herramienta de programación de IA, reveló que solo completó 3 de 20 pruebas de programación.

La capacidad de programación de la IA sigue siendo controvertida. Anteriormente, el Sr. Kevin Weil, director de producto de OpenAI, afirmó que para finales de este año, la IA superará a los programadores humanos.

Por otro lado, Bill Gates, cofundador de Microsoft, cree que la programación seguirá siendo una carrera sostenible en el futuro. Otros líderes como Amjad Masad (CEO de Replit), Todd McKinnon (CEO de Okta) y Arvind Krishna (CEO de IBM) también han expresado su apoyo a esta opinión.

La investigación de Microsoft, aunque no es nueva, también es un recordatorio para los programadores, incluidos los gerentes, para que piensen más cuidadosamente antes de darle el control total de la codificación a la IA.

Fuente: https://znews.vn/diem-yeu-chi-mang-cua-ai-post1545220.html

![[Foto] El presidente de la Asamblea Nacional, Tran Thanh Man, visita a la heroica madre vietnamita Ta Thi Tran](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/7/20/765c0bd057dd44ad83ab89fe0255b783)

Kommentar (0)