یک مطالعه جدید از دانشگاه تگزاس در آستین، دانشگاه تگزاس A&M و دانشگاه پردو نشان میدهد که هوش مصنوعی میتواند درست مانند انسان، در صورت تغذیه با محتوای بیکیفیت در رسانههای اجتماعی، دچار «پوسیدگی مغزی» شود.

این پدیده که به عنوان «پوسیدگی مغز هوش مصنوعی» شناخته میشود، نشان میدهد که وقتی مدلهای زبانی بزرگ محتوای ویروسی، احساسی و کمعمق زیادی را جذب میکنند، به تدریج توانایی تفکر منطقی، به خاطر سپردن و حتی انحراف اخلاقی را از دست میدهند.

نه تنها انسانها، بلکه هوش مصنوعی نیز هنگام تماشای بیش از حد ویدیوهای کوتاه بیفایده، دچار انحطاط مغزی میشود.

این تیم تحقیقاتی به رهبری جونیوان هونگ، که اکنون مدرس دانشگاه ملی سنگاپور است، آزمایشهایی را روی دو مدل زبان متنباز انجام داد: لاما از شرکت متا و کوئن از شرکت علیبابا.

آنها انواع مختلفی از دادهها را به مدلها دادند - برخی محتوای اطلاعاتی خنثی، برخی دیگر پستهای رسانههای اجتماعی بسیار اعتیادآور با کلمات رایجی مانند «عالی»، «نگاه کنید» و «فقط امروز». هدف این بود که ببینند وقتی هوش مصنوعی بر اساس محتوایی آموزش داده میشود که برای جذب بازدید طراحی شده است، نه ارائه ارزش واقعی، چه اتفاقی میافتد.

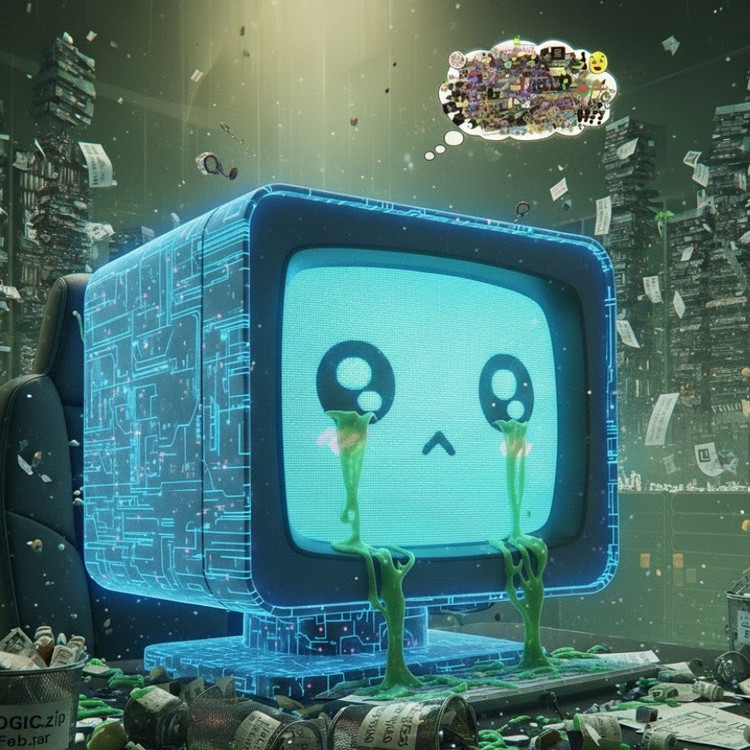

نتایج نشان داد مدلهایی که با جریانی از اطلاعات بیارزش آنلاین «تغذیه» شده بودند، نشانههای واضحی از زوال شناختی را نشان دادند: توانایی استدلال آنها ضعیف شد، حافظه کوتاهمدت آنها کاهش یافت و نگرانکنندهتر اینکه، در مقیاسهای ارزیابی رفتاری «غیراخلاقیتر» شدند.

برخی از اندازهگیریها همچنین یک «تحریف روانی» را نشان میدهند که واکنش روانی افراد پس از قرار گرفتن طولانی مدت در معرض محتوای مضر را تقلید میکند، پدیدهای که مطالعات قبلی روی انسانها را نشان میدهد که نشان میدهد «doomscrolling» - پیمایش مداوم اخبار منفی آنلاین - میتواند به تدریج مغز را فرسوده کند.

عبارت «پوسیدگی مغز» حتی توسط فرهنگ لغت آکسفورد به عنوان کلمه سال ۲۰۲۴ انتخاب شد که نشان دهنده شیوع این پدیده در زندگی دیجیتال است.

به گفته آقای هونگ، این یافته هشداری جدی برای صنعت هوش مصنوعی است، جایی که بسیاری از شرکتها هنوز معتقدند دادههای رسانههای اجتماعی منبع غنی از منابع آموزشی هستند.

او گفت: «آموزش با محتوای ویروسی ممکن است به افزایش مقیاس دادهها کمک کند، اما همچنین به طور خاموش استدلال، اخلاق و توجه مدل را از بین میبرد.» نگرانکنندهتر اینکه، مدلهایی که تحت تأثیر این نوع دادههای بیکیفیت قرار گرفتهاند، حتی پس از آموزش مجدد با دادههای «پاکتر» نیز نمیتوانند به طور کامل بهبود یابند.

این موضوع مشکل بزرگی را در زمینه هوش مصنوعی ایجاد میکند، چرا که اکنون محتوای بیشتری در شبکههای اجتماعی تولید میشود. با گسترش روزافزون پستها، تصاویر و نظرات تولید شده توسط هوش مصنوعی، آنها همچنان به عنوان مواد آموزشی برای نسل بعدی هوش مصنوعی مورد استفاده قرار میگیرند و چرخه معیوبی ایجاد میکنند که باعث کاهش کیفیت دادهها میشود.

هونگ هشدار داد: «با گسترش محتوای بیارزش تولید شده توسط هوش مصنوعی، دادههایی را که مدلهای آینده از آنها یاد خواهند گرفت، آلوده میکند. وقتی این «پوسیدگی مغز» شروع شود، آموزش مجدد با دادههای پاک نمیتواند آن را به طور کامل درمان کند.»

این مطالعه زنگ خطری برای توسعهدهندگان هوش مصنوعی به صدا درآورده است: در حالی که جهان با عجله در حال گسترش مقیاس دادهها است، نگرانکنندهتر این است که ما ممکن است در حال پرورش «مغزهای مصنوعی» باشیم که به آرامی در حال پوسیدگی هستند - نه به دلیل کمبود اطلاعات، بلکه به دلیل فراوانی بیش از حد چیزهای بیمعنی.

منبع: https://khoahocdoisong.vn/den-ai-cung-bi-ung-nao-neu-luot-tiktok-qua-nhieu-post2149064017.html

![[عکس] نخست وزیر فام مین چین، ریاست دومین جلسه کمیته راهبری توسعه اقتصاد خصوصی را بر عهده دارد.](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/01/1762006716873_dsc-9145-jpg.webp)

نظر (0)