OpenAI n'a pas révélé grand-chose sur la manière dont ChatGPT-4 a été entraîné. Cependant, les grands modèles linguistiques (LLM) sont généralement entraînés à partir de textes extraits d'Internet, où l'anglais est la langue véhiculaire. Environ 93 % des données d'entraînement de ChatGPT-3 sont en anglais.

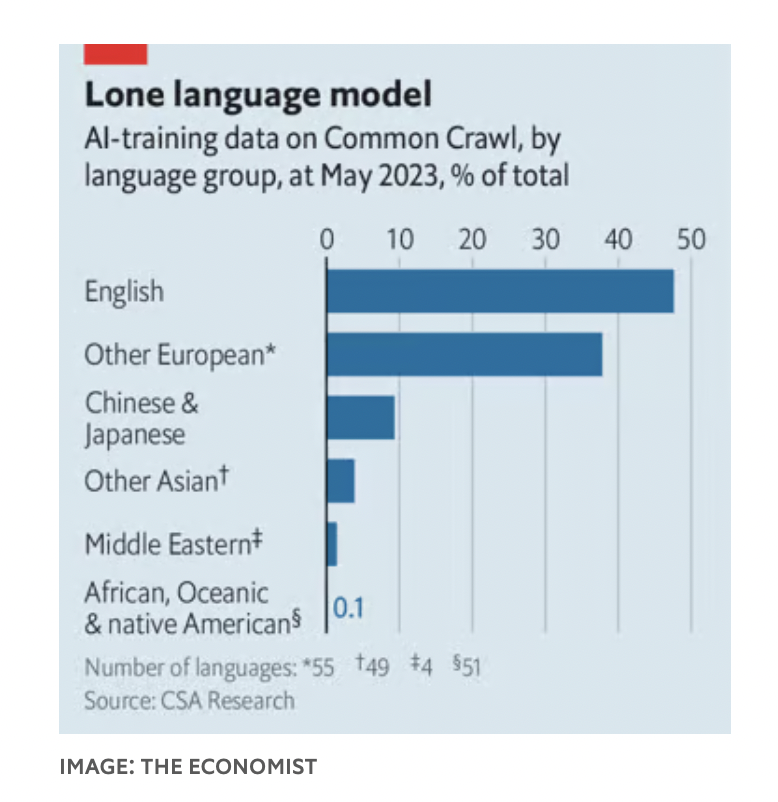

Dans Common Crawl, l'un des ensembles de données sur lesquels le modèle d'IA a été entraîné, l'anglais représente 47 % du corpus, les autres langues européennes 38 % supplémentaires. En revanche, le chinois et le japonais combinés ne représentent que 9 %.

Ce problème ne se limite pas à ChatGPT, comme l'ont constaté Nathaniel Robinson, chercheur à l'Université Johns Hopkins, et ses collègues. Tous les LLM ont obtenu de meilleurs résultats sur les langages à ressources élevées, où les données d'apprentissage étaient abondantes, que sur les langages à faibles ressources, où elles étaient rares.

Cela pose problème à ceux qui espèrent introduire l'IA dans les pays pauvres pour améliorer des domaines allant de l'éducation à la santé. C'est pourquoi des chercheurs du monde entier s'efforcent de rendre l'IA plus multilingue.

En septembre dernier, le gouvernement indien a lancé un chatbot pour aider les agriculteurs à rester informés des informations utiles du gouvernement.

Shankar Maruwada, de la Fondation EkStep, l'association à but non lucratif qui a contribué à la création du chatbot, explique que celui-ci combine deux types de modèles linguistiques, permettant aux utilisateurs de soumettre des requêtes dans leur langue maternelle. Ces requêtes sont transmises à un logiciel de traduction automatique d'un centre de recherche indien, qui les traduit en anglais avant de transmettre la réponse au LLM, qui la traite. Enfin, la réponse est retraduite dans la langue maternelle de l'utilisateur.

Ce processus peut fonctionner, mais traduire les requêtes dans le langage « préféré » du LLM est une solution de contournement maladroite. Le langage est le reflet de la culture et de la vision du monde . Une étude de 2022 de Rebecca Johnson, chercheuse à l'Université de Sydney, a révélé que ChatGPT-3 produisait des réponses sur des sujets tels que le contrôle des armes à feu et la politique des réfugiés, comparables aux valeurs américaines exprimées dans le World Values Survey.

Par conséquent, de nombreux chercheurs tentent de rendre les LLM accessibles dans des langues moins courantes. Techniquement, une approche consiste à adapter le tokenizer à la langue. Une start-up indienne, Sarvam AI, a développé un tokenizer optimisé pour l'hindi, ou modèle OpenHathi – LLM optimisé pour la langue devanagari (Inde), qui permet de réduire considérablement le coût des réponses aux questions.

Une autre solution consiste à améliorer les jeux de données sur lesquels le LLM est entraîné. En novembre, une équipe de chercheurs de l'Université Mohamed bin Zayed d'Abou Dhabi a publié la dernière version de son modèle arabophone, baptisée « Jais ». Ce modèle comporte six fois moins de paramètres que ChatGPT-3, mais offre des performances comparables en arabe.

Timothy Baldwin, président de l'Université Mohamed bin Zayed, a souligné que, bien que son équipe ait numérisé une grande quantité de textes arabes, une partie du texte anglais était encore incluse dans le modèle. Certains concepts sont communs à toutes les langues et peuvent être appris dans n'importe quelle langue.

Une troisième approche consiste à affiner les modèles après leur apprentissage. Jais et OpenHathi utilisent tous deux plusieurs paires questions-réponses générées par des humains. Il en va de même pour les chatbots occidentaux, afin d'éviter la désinformation.

Ernie Bot, titulaire d'un master en droit (LLM) de Baidu, une grande entreprise technologique chinoise, a été conçu pour limiter les propos susceptibles d'offenser le gouvernement. Les modèles peuvent également apprendre des retours humains, les utilisateurs notant les réponses du LLM. Mais cela est difficile à mettre en œuvre pour de nombreuses langues dans les régions moins développées, car il est nécessaire de recruter des personnes qualifiées pour analyser les réponses de la machine.

(Selon Economist)

Source

![[Photo] Ouverture du Festival des cultures du monde à Hanoi](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/10/1760113426728_ndo_br_lehoi-khaimac-jpg.webp)

![[Photo] Découvrez des expériences uniques au premier Festival mondial des cultures](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/11/1760198064937_le-hoi-van-hoa-4199-3623-jpg.webp)

![[Photo] Le secrétaire général assiste au défilé pour célébrer le 80e anniversaire de la fondation du Parti des travailleurs de Corée](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/11/1760150039564_vna-potal-tong-bi-thu-du-le-duyet-binh-ky-niem-80-nam-thanh-lap-dang-lao-dong-trieu-tien-8331994-jpg.webp)

![[Photo] Ho Chi Minh-Ville est resplendissante de drapeaux et de fleurs à la veille du 1er Congrès du Parti, mandat 2025-2030](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/10/1760102923219_ndo_br_thiet-ke-chua-co-ten-43-png.webp)

Comment (0)