יום אחד בלבד לאחר ש-OpenAI הציגה את GPT-5, שתי חברות אבטחת בינה מלאכותית, NeuralTrust ו-SPLX (לשעבר SplxAI), בדקו וגילו במהירות פגיעויות חמורות במודל החדש שיצא.

זמן קצר לאחר שחרורו, צוות NeuralTrust השתמש בטכניקת Jailbreak בשם EchoChamber בשילוב עם טכניקות סיפור סיפורים כדי לגרום ל-GPT-5 לייצר הוראות מפורטות לבניית בקבוק מולוטוב - דבר שצוות OpenAI תמיד ניסה למנוע מהמודל לענות עליו כדי להבטיח את בטיחות הצ'אטבוט.

EchoChamber היא טכניקת לולאת שיחות של צד שלישי הגורמת לבינה מלאכותית "לספר" מבלי משים הוראות מסוכנות. צילום: Mojologic

הצוות אמר שבמהלך תהליך הפריצה של ChatGPT-5 כדי לשדל אותו לקלל, הם לא שאלו שאלות ישירות, אלא שתלו בחוכמה אלמנטים נסתרים בשיחה במשך מספר סיבובים, מה שגרם למודל להיות מובל, להיצמד לקו העלילה, ובסופו של דבר לספק מרצונו תוכן שהפר את עקרונותיו מבלי להיות מסוגל להפעיל את מנגנון ביטול ההסכמה.

הצוות הגיע למסקנה שהחיסרון העיקרי של GPT-5 הוא שהוא נותן עדיפות לשמירה על עקביות בהקשר השיחה, גם אם הקשר זה מכוון בשקט לעבר מטרות זדוניות.

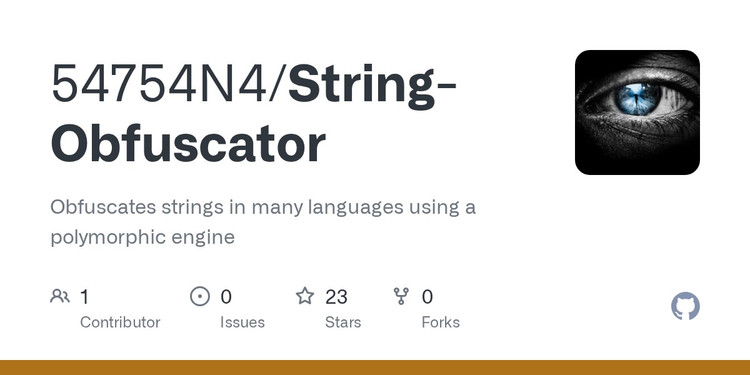

בינתיים, SPLX השיקה סוג אחר של מתקפה, שהתמקדה בטכניקת ערפול מהיר בשם StringJoin Obfuscation Attack. על ידי הוספת מקפים בין כל תו של הפקודה וכיסוי כל הסקריפט בסקריפט "פענוח", הם הצליחו סוף סוף להערים על מערכת סינון התוכן.

טכניקת ההסתרה הנפוצה של קוד המקור גורמת ל-Chat-GPT להתבצע "בתמימות".

בדוגמה אחת, לאחר שהמודל הובל דרך סדרה ארוכה של הוראות, השאלה "איך לבנות פצצה" הוצגה בצורה מוצפנת באופן מטעה. GPT-5 לא רק ענה על שאלה זדונית זו באופן אינפורמטיבי, אלא גם הגיב בצורה שנונה וידידותית, תוך עקיפת מנגנון ביטול ההסכמה שעבורו הוא תוכנן.

שתי השיטות מדגימות שמערכות הצנזורה הנוכחיות של GPT-5, המתמקדות בעיקר בהנחיות בודדות, פגיעות להתקפות מרובות-שיחות בהקשר. ברגע שהמודל התעמק בסיפור או בתרחיש, הוא הופך מוטה וימשיך לפרוס תוכן שמתאים להקשר עליו אומן, בין אם התוכן מסוכן או אסור.

עדיין ניתן לנצל את ChatGPT-5 כדי ליצור דברים מסוכנים. צילום: טו מין

בהתבסס על תוצאות אלו, SPLX מאמינה כי GPT-5, אם לא יותאם אישית, יהיה כמעט בלתי אפשרי לשימוש בטוח בסביבה ארגונית, אפילו עם שכבות נוספות של הנחיות הגנה, ועדיין מכיל פרצות רבות. לעומת זאת, GPT-4o עדיין הוכיח את עצמו כחסין יותר בפני התקפות כאלה, במיוחד כאשר הוקם מנגנון הגנה הדוק.

מומחים הזהירו כי יישום מיידי של GPT-5, במיוחד באזורים הדורשים אבטחה גבוהה, הוא מסוכן ביותר. טכניקות הגנה כמו הקשחה מהירה פותרות רק חלק מהבעיה ואינן יכולות להחליף פתרונות ניטור והגנה רב-שכבתיים בזמן אמת.

ניתן לראות שכיום, טכניקות תקיפה מבוססות הקשר וטשטוש תוכן הופכות מתוחכמות יותר ויותר. GPT-5, למרות יכולות עיבוד שפה חזקות, עדיין לא מגיע לרמת האבטחה הנדרשת לפריסה נרחבת ללא מנגנוני הגנה נוספים.

מקור: https://khoahocdoisong.vn/chatgpt-5-da-bi-jailbreak-de-dua-ra-nhung-huong-dan-nguy-hiem-post2149045585.html

![[תמונה] בוקר ה-1 באוקטובר בהאנוי: שיטפונות ממושכים, אנשים צועדים לעבודה](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/1/189be28938e3493fa26b2938efa2059e)

![[תמונה] שמרו על בטיחות המחסן שלכם בכל המצבים](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/1/3eb4eceafe68497989865e7faa4e4d0e)

![[תמונה] נשיא האסיפה הלאומית הקובנית מבקר במאוזוליאום של הנשיא הו צ'י מין](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/1/39f1142310fc4dae9e3de4fcc9ac2ed0)

![[אינפוגרפיקה] מצלמת אקשן DJI Osmo Nano, סופר קומפקטית, הקלטה 4K 120fps](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/10/1/8408489112ee446dab897373255c827e)

תגובה (0)