एंड्रॉइड अथॉरिटी के अनुसार, ऐप्पल के शोध पत्र में सीमित रैम वाले उपकरणों पर बड़े भाषा मॉडल (एलएलएम) चलाने के समाधान का विवरण दिया गया है। यह पत्र बताता है कि कंपनी कैसे "मॉडल पैरामीटर्स" को स्टोर कर सकती है और ज़रूरत पड़ने पर पूरे मॉडल को रैम में लोड करने के बजाय, उनमें से एक हिस्से को डिवाइस की रैम में लोड कर सकती है।

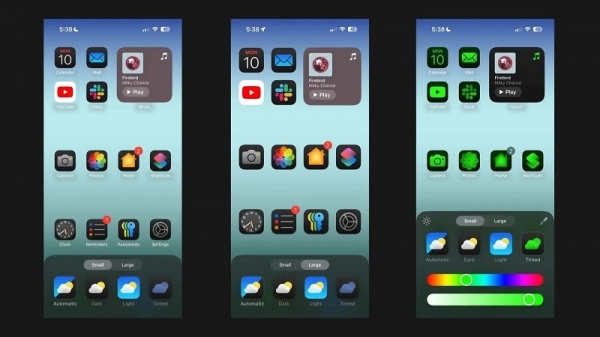

एप्पल कम रैम वाले पुराने आईफ़ोन को सामान्य एआई चलाने में मदद करना चाहता है

पेपर में दावा किया गया है कि इस विधि से ऐसे मॉडल चलाए जा सकते हैं, जिनके लिए आईफोन की तुलना में दोगुनी रैम की आवश्यकता होती है, जबकि सीपीयू और जीपीयू पर सरल लोडिंग विधियों की तुलना में क्रमशः 4-5x और 20-25x अनुमान गति सुनिश्चित की जा सकती है।

ज़्यादा रैम वाले डिवाइस पर सिंथेटिक एआई का इस्तेमाल करना एक बड़ा फ़ायदा होगा क्योंकि इससे पढ़ने/लिखने की गति तेज़ हो जाएगी। ऑन-डिवाइस एआई के लिए गति महत्वपूर्ण है, जिससे अनुमान लगाने में काफ़ी तेज़ी आती है क्योंकि उपयोगकर्ताओं को प्रतिक्रिया या अंतिम परिणाम के लिए दसियों सेकंड (या उससे ज़्यादा) इंतज़ार नहीं करना पड़ता। इसका मतलब है कि एक ऑन-डिवाइस एआई असिस्टेंट बातचीत की गति से काम कर सकता है, बहुत तेज़ी से चित्र/टेक्स्ट तैयार कर सकता है, लेखों का सारांश तेज़ी से दे सकता है, वगैरह। लेकिन ऐप्पल के इस समाधान का मतलब है कि उपयोगकर्ताओं को ऑन-डिवाइस एआई कार्यों की प्रतिक्रिया को तेज़ करने के लिए बहुत ज़्यादा रैम की ज़रूरत नहीं है।

Apple के इस कदम से पुराने और नए iPhones अपने डिवाइस में सीधे सिंथेटिक AI फ़ीचर दे सकेंगे। यह इसलिए ज़रूरी है क्योंकि Apple के iPhones में आमतौर पर हाई-एंड Android फ़ोन्स की तुलना में कम RAM होती है। उदाहरण के लिए, iPhone 11 सीरीज़ में सिर्फ़ 4GB RAM है, जबकि आम iPhone 15 में भी सिर्फ़ 6GB RAM है।

Apple अकेली मोबाइल कंपनी नहीं है जो LLM को छोटा करने पर काम कर रही है। क्वालकॉम और मीडियाटेक के हालिया फ्लैगशिप चिप्स, दोनों ही इन मॉडलों को छोटा करने के लिए INT4 प्रिसिशन को सपोर्ट करते हैं। बहरहाल, कंपनियाँ ऑन-डिवाइस AI के लिए सिस्टम आवश्यकताओं को कम करने के नए तरीके खोजने की कोशिश कर रही हैं, जिससे कम-अंत वाले फ़ोन भी यह सुविधा प्रदान कर सकें।

[विज्ञापन_2]

स्रोत लिंक

![[फोटो] प्रधानमंत्री फाम मिन्ह चीन्ह भ्रष्टाचार, बर्बादी और नकारात्मकता की रोकथाम और मुकाबला करने के लिए आयोजित 5वें राष्ट्रीय प्रेस पुरस्कार समारोह में शामिल हुए](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/31/1761881588160_dsc-8359-jpg.webp)

![[फोटो] दा नांग: पानी धीरे-धीरे कम हो रहा है, स्थानीय अधिकारी सफाई का लाभ उठा रहे हैं](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/31/1761897188943_ndo_tr_2-jpg.webp)

टिप्पणी (0)