एनवीडिया ने 18 मार्च को अपने डेवलपर इवेंट में आर्टिफिशियल इंटेलिजेंस (एआई) बाजार में अपनी स्थिति मजबूत करने के लिए कई नए उत्पादों की घोषणा की। 2022 के अंत में चैटजीपीटी द्वारा वैश्विक एआई दौड़ शुरू करने के बाद से चिप निर्माता के शेयर की कीमत 54 गुना बढ़ गई है और राजस्व तीन गुना से भी अधिक हो गया है। एनवीडिया के उच्च-स्तरीय सर्वर जीपीयू बड़े भाषा मॉडल के प्रशिक्षण और परिनियोजन के लिए महत्वपूर्ण हैं, और माइक्रोसॉफ्ट और मेटा जैसी कंपनियां इन चिप्स पर अरबों डॉलर खर्च कर रही हैं।

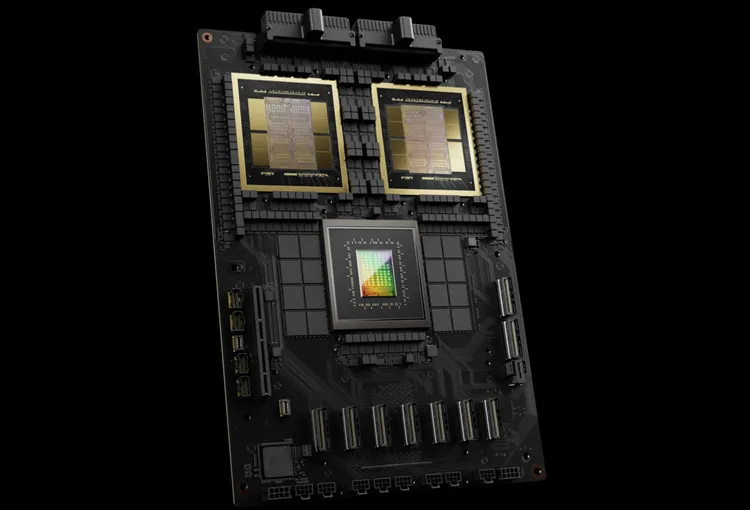

एनवीडिया अपनी अगली पीढ़ी की एआई चिप को ब्लैकवेल नाम देता है। पहली ब्लैकवेल चिप, GB200, इस साल के अंत में उपलब्ध होगी। नए ऑर्डर बढ़ाने के लिए एनवीडिया ग्राहकों को ज़्यादा शक्तिशाली चिप्स दे रहा है। ग्राहक अभी भी H100 हॉपर चिप पाने के लिए संघर्ष कर रहे हैं।

एनवीडिया के सीईओ जेन्सन हुआंग ने कार्यक्रम में कहा, "हॉपर बहुत बढ़िया है, लेकिन हमें बड़े जीपीयू की जरूरत है।"

ब्लैकवेल चिप के साथ, एनवीडिया ने एनआईएम सॉफ्टवेयर भी पेश किया है जो एआई को तैनात करना आसान बनाता है। एनवीडिया के अधिकारियों का कहना है कि कंपनी चिप आपूर्तिकर्ता से ज़्यादा ऐप्पल और माइक्रोसॉफ्ट जैसी प्लेटफ़ॉर्म प्रदाता बन रही है।

हुआंग ने कहा, "ब्लैकवेल कोई चिप नहीं है, यह एक प्लेटफ़ॉर्म का नाम है।" एनवीडिया के उपाध्यक्ष मनुवीर दास ने वादा किया कि एनआईएम सॉफ़्टवेयर डेवलपर्स को किसी भी एनवीडिया जीपीयू, चाहे वह पुराना हो या नया, पर प्रोग्राम चलाने में मदद करेगा ताकि ज़्यादा लोगों तक पहुँच सके।

ब्लैकवेल, हॉपर के "उत्तराधिकारी"

हर दो साल में, Nvidia अपने GPU आर्किटेक्चर को अपडेट करता है, जिससे नए प्रदर्शन लाभ सामने आते हैं। पिछले साल जारी किए गए कई AI मॉडल हॉपर आर्किटेक्चर पर प्रशिक्षित किए गए थे, जो 2022 से उपलब्ध होगा।

एनवीडिया का कहना है कि ब्लैकवेल-आधारित चिप्स जैसे GB200, AI व्यवसायों के प्रदर्शन में उल्लेखनीय वृद्धि प्रदान करते हैं, जो H100 के 4 पेटाफ्लॉप की तुलना में 20 पेटाफ्लॉप प्रदान करते हैं। यह प्रोसेसिंग पावर AI व्यवसायों को बड़े और अधिक जटिल मॉडलों को प्रशिक्षित करने में सक्षम बनाती है।

ब्लैकवेल जीपीयू बड़ा है और दो अलग-अलग निर्मित डाई को एक चिप में जोड़ता है। यह GB200 NVLink 2 नामक एक पूर्ण सर्वर के रूप में भी उपलब्ध है, जो 72 ब्लैकवेल जीपीयू और एआई मॉडलों को प्रशिक्षित करने के लिए डिज़ाइन किए गए अन्य Nvidia पुर्जों को एक साथ जोड़ता है।

अमेज़न, गूगल, माइक्रोसॉफ्ट और ओरेकल क्लाउड सेवाओं के माध्यम से GB200 तक पहुँच बेचेंगे। GB200 में दो B200 ब्लैकवेल GPU और एक ग्रेस CPU का संयोजन है। Nvidia ने कहा कि अमेज़न वेब सर्विसेज (AWS) 20,000 GB200 चिप्स वाला एक सर्वर क्लस्टर बनाएगा।

यह प्रणाली 27 ट्रिलियन पैरामीटर मॉडल चला सकती है, जो आज उपलब्ध सबसे बड़े मॉडल, जैसे GPT-4 (1.7 ट्रिलियन पैरामीटर) से कहीं ज़्यादा बड़ा है। कई AI शोधकर्ताओं का मानना है कि ज़्यादा पैरामीटर और डेटा वाले बड़े मॉडल नई क्षमताओं को उजागर कर सकते हैं।

एनवीडिया ने नए जीबी200 या जीबी200 वाले सिस्टम की कीमतों की घोषणा नहीं की है। विश्लेषकों के अनुमान के अनुसार, एनवीडिया के हॉपर-आधारित एच100 की कीमत प्रति यूनिट $25,000 से $40,000 के बीच है, और पूरे सिस्टम की कीमत $200,000 तक है।

(सीएनबीसी के अनुसार)

[विज्ञापन_2]

स्रोत

![[फोटो] लाओस के राष्ट्रपति थोंगलाउन सिसोउलिथ और कम्बोडियन पीपुल्स पार्टी के अध्यक्ष और कम्बोडियन सीनेट के अध्यक्ष हुन सेन पार्टी के ध्वज प्रकाश मार्ग की 95वीं वर्षगांठ प्रदर्शनी का दौरा करते हुए](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/9/2/3c1a640aa3c3495db1654d937d1471c8)

![[फोटो] विशेष कला कार्यक्रम "दा नांग - भविष्य को जोड़ना"](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/9/2/efdd7e7142fd45fabc2b751d238f2f08)

![[फोटो] नेशनल असेंबली के अध्यक्ष ट्रान थान मान ने क्यूबा के प्रथम सचिव और राष्ट्रपति मिगुएल डियाज़-कैनेल बरमूडेज़ से मुलाकात की](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/9/2/c6a0120a426e415b897096f1112fac5a)

![[फोटो] हो ची मिन्ह शहर के निवासी अगस्त क्रांति की 80वीं वर्षगांठ और 2 सितंबर को राष्ट्रीय दिवस मनाने के लिए अपना स्नेह प्रदर्शित करते हैं](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/9/3/55d860cbb63a40808e1e74ad9289b132)

टिप्पणी (0)