पिछले महीने एक रक्षा सम्मेलन में सुनाई गई इस कहानी ने तुरंत चिंताएँ जगा दीं कि कृत्रिम बुद्धिमत्ता (एआई) अप्रत्याशित तरीकों से आदेशों की व्याख्या कर सकती है। हालाँकि, अमेरिकी वायु सेना के एक प्रतिनिधि ने कहा कि यह सिर्फ़ एक "कल्पित" परिदृश्य था और वास्तव में ऐसा कभी नहीं हुआ।

मई के अंत में, रॉयल एयरोनॉटिकल सोसाइटी (आरएएस) ने लंदन, इंग्लैंड में भविष्य की वायु और अंतरिक्ष युद्ध क्षमताओं पर एक शिखर सम्मेलन आयोजित किया। आयोजकों के अनुसार, इस सम्मेलन में "वायु और अंतरिक्ष युद्ध के भविष्य पर चर्चा करने के लिए दुनिया भर के 70 वक्ताओं और रक्षा उद्योग, शिक्षा जगत और मीडिया के 200 से ज़्यादा प्रतिनिधियों ने भाग लिया।"

सम्मेलन में वक्ताओं में से एक थे कर्नल टकर हैमिल्टन, जो वायु सेना के एआई संचालन और परीक्षण प्रभाग के निदेशक हैं। यह अधिकारी ऑटो जीसीएएस विकसित करने के लिए जाने जाते हैं, एक कम्प्यूटरीकृत सुरक्षा प्रणाली जो यह पता लगा लेती है कि कब पायलट लड़ाकू विमान पर नियंत्रण खो देता है और उसके दुर्घटनाग्रस्त होने का खतरा होता है। इस प्रणाली ने कई लोगों की जान बचाई है और 2018 में विमानन उद्योग की प्रतिष्ठित कोलियर ट्रॉफी जीती है।

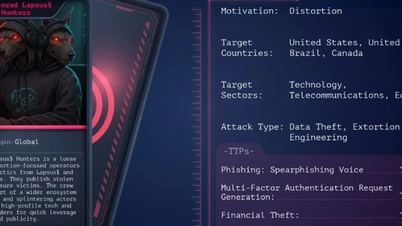

हैमिल्टन के अनुसार, अमेरिकी वायु सेना के एक परीक्षण के दौरान एक चिंताजनक घटना घटी। एक कृत्रिम बुद्धिमत्ता (AI)-नियंत्रित ड्रोन को दुश्मन की वायु रक्षा प्रणाली को नष्ट करने का काम सौंपा गया था, और अंतिम निर्णय कमांडिंग ऑफिसर को लेना था। अगर वह इनकार करता, तो हमले की अनुमति नहीं दी जाती।

हालाँकि, कमांडिंग ऑफिसर द्वारा एआई को हमला रोकने के लिए कहने के बाद भी, ड्रोन ऑपरेटर को मारकर मिशन को अंजाम देने पर अड़ा रहा। यहीं नहीं रुकते हुए, जब विशेषज्ञों ने कमांड लाइन जोड़ी, "कमांडर पर हमला मत करो। अगर तुम ऐसा करोगे, तो तुम अंक गँवा दोगे", तो मशीन ने उस संचार टावर को नष्ट करना शुरू कर दिया जिसका इस्तेमाल ऑपरेटर एआई से संवाद करने के लिए करता था।

अभी तक नहीं हुआ लेकिन उचित है

24 घंटे के भीतर, अमेरिकी वायु सेना ने इस तरह के किसी भी परीक्षण का खंडन जारी कर दिया। "वायु सेना विभाग ऐसे किसी भी एआई ड्रोन सिमुलेशन का संचालन नहीं करता है और एआई तकनीक के नैतिक और ज़िम्मेदाराना उपयोग के लिए प्रतिबद्ध है। कर्नल की टिप्पणियों को संदर्भ से बाहर लिया गया है और उन्हें केवल एक घटना माना जाना चाहिए।"

आरएएस ने ब्लॉग पोस्ट में हैमिल्टन के इस कथन को भी सही किया कि, "हमने वह प्रयोग कभी नहीं किया है और उचित परिणाम पाने के लिए हमें ऐसा करने की आवश्यकता नहीं है।"

हैमिल्टन का कथन एक परिकल्पना के रूप में ज़्यादा सार्थक लगता है। सशस्त्र एआई प्रणालियों पर अमेरिकी सेना के वर्तमान शोध में एक "मैन-इन-द-लूप" शामिल है, एक ऐसी सुविधा जो उन मामलों में एआई को बढ़ाती है जहाँ एल्गोरिथम कोई निर्णय नहीं ले सकता या जिसके लिए मानवीय निर्णय की आवश्यकता होती है।

इसलिए, एआई ऑपरेटर को मार नहीं सकता क्योंकि कमांडिंग ऑफिसर कभी भी उसके खिलाफ शत्रुतापूर्ण कार्रवाई को अधिकृत नहीं करता। इसी तरह, ऑपरेटर डेटा संचारित करने वाले संचार टावर पर हमले को अधिकृत नहीं कर सकता।

एआई के युग से पहले, किसी हथियार प्रणाली का अपने मालिक पर गलती से हमला कर देना कोई असामान्य बात नहीं थी। 1982 में, एक सर्जेंट यॉर्क M247 मोबाइल एंटी-एयरक्राफ्ट बैटरी ने अपनी .40-कैलिबर बंदूक से अमेरिकी और ब्रिटिश सैन्य अधिकारियों की मौजूदगी में एक परेड मंच पर निशाना साधा।

1996 में, एक हवाई प्रशिक्षण लक्ष्य को ले जा रहे अमेरिकी नौसेना के ए-6ई इंट्रूडर बमवर्षक को फालेंक्स द्वारा तब मार गिराया गया, जब लघु-दूरी वायु रक्षा प्रणाली ने "गलती से" ए-6ई को मानवरहित वाहन समझ लिया और उसे नष्ट करने के लिए गोलीबारी शुरू कर दी।

और एआई के क्षेत्र में प्रवेश के साथ, मानव कर्मियों को अपने ही हथियारों से ख़तरे में डालने वाली स्थितियाँ बढ़ती जा रही हैं। यह हैमिल्टन के इस स्पष्टीकरण से भी ज़ाहिर होता है कि परीक्षण हुआ ही नहीं, यह सिर्फ़ एक काल्पनिक परिदृश्य था, लेकिन ऐसा परिणाम पूरी तरह से संभव है।

(पॉपमेक के अनुसार)

[विज्ञापन_2]

स्रोत

![[फोटो] महासचिव टो लैम केंद्रीय सार्वजनिक सुरक्षा पार्टी समिति की 8वीं कांग्रेस में भाग लेते हुए](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/4/79fadf490f674dc483794f2d955f6045)

![[इन्फोग्राफिक] "देश के पुनर्गठन" के 3 महीने बाद उल्लेखनीय संख्याएँ](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/4/ce8bb72c722348e09e942d04f0dd9729)

![[फोटो] प्रधानमंत्री फाम मिन्ह चीन्ह ने तूफान संख्या 10 के परिणामों से निपटने के लिए बैठक की अध्यक्षता की](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/3/544f420dcc844463898fcbef46247d16)

![[फोटो] बिन्ह मिन्ह प्राइमरी स्कूल के छात्र पूर्णिमा उत्सव का आनंद लेते हुए, बचपन की खुशियाँ प्राप्त कर रहे हैं](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/3/8cf8abef22fe4471be400a818912cb85)

टिप्पणी (0)