Ha valaha is böngésztél a közösségi médiában, valószínűleg találkoztál már mesterséges intelligencia által készített képekkel vagy videókkal . Sok embert becsaptak már, például a trambulinon ugráló nyulakat bemutató vírusvideót. De a Sora – a ChatGPT testvéralkalmazása, amelyet az OpenAI fejlesztett ki – új szintre emeli a mesterséges intelligencia által készített videókat, egyre sürgetőbbé téve a hamis tartalmak felderítését.

A mesterséges intelligencia által támogatott videóeszközök minden eddiginél nehezebbé teszik a valódi videók azonosítását. (Forrás: CNET)

A 2024-ben indult és nemrégiben a Sora 2-vel frissített alkalmazás felülete hasonló a TikTokhoz, ahol minden videót mesterséges intelligencia generál. A „cameo” funkció lehetővé teszi, hogy valódi embereket illesszünk be a szimulált felvételekbe, így ijesztően realisztikus videókat hozva létre.

Ezért sok szakértő attól tart, hogy a Sora deepfake-ek terjedését fogja okozni, torzítva az információkat és elmosva a valóság és a hamisítvány közötti határokat. A hírességek különösen sebezhetőek, ezért olyan szervezetek, mint a SAG-AFTRA, felszólították az OpenAI-t a védelem megerősítésére.

A mesterséges intelligencia által generált tartalmak azonosítása komoly kihívást jelent a technológiai vállalatok, a közösségi média platformok és a felhasználók számára egyaránt. Vannak azonban módszerek a Sora segítségével létrehozott videók felismerésére.

Sora vízjel keresése

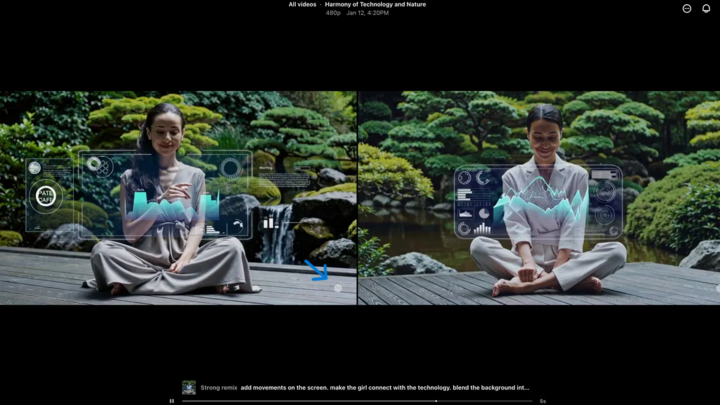

A Sora vízjel (kék nyíllal jelölve) egy jelölő, amely azonosítja a videó létrehozásához használt eszközt. (Forrás: CNET)

Minden, a Sora iOS alkalmazásban létrehozott videó letöltéskor vízjellel rendelkezik – a fehér Sora logó (felhő ikon) a videó szélei körül mozog, hasonlóan a TikTok vízjeléhez.

Ez egy vizuális módja a mesterséges intelligencia által generált tartalom azonosításának. Például a Google Gemini „nano-banán” modellje automatikusan vízjelet ad a képekhez. A vízjelek azonban nem mindig megbízhatóak. Ha a vízjel statikus, könnyen kivágható. Még a dinamikus vízjelek, mint például a Sora vízjele, speciális alkalmazásokkal eltávolíthatók.

Amikor erről kérdezték, az OpenAI vezérigazgatója, Sam Altman azzal érvelt, hogy a társadalomnak alkalmazkodnia kell ahhoz a valósághoz, hogy bárki készíthet hamis videókat. A Sora előtt soha nem létezett olyan eszköz, amely ennyire népszerű, elérhető és semmilyen szakértelmet nem igényelt volna az ilyen videók készítéséhez. Véleménye kiemeli az alternatív ellenőrzési módszerekre való támaszkodás szükségességét.

Metaadatok ellenőrzése

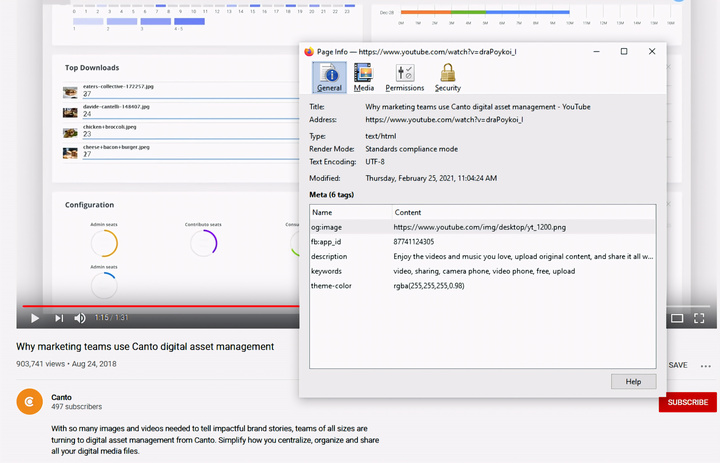

Metaadatok ellenőrzése – kulcsfontosságú lépés annak megállapításában, hogy egy videót mesterséges intelligencia, például Sora készített-e. (Forrás: Canto)

Azt gondolhatod, hogy a metaadatok ellenőrzése túl bonyolult, de valójában elég egyszerű és nagyon hatékony.

A metaadatok olyan információk halmaza, amelyeket automatikusan csatolnak a tartalomhoz annak létrehozásakor, például a kamera típusa, a helyszín, a felvétel ideje és a fájlnév. Akár ember, akár mesterséges intelligencia által generált a tartalom, metaadatokkal rendelkezik. A mesterséges intelligencia által generált tartalmak esetében a metaadatok gyakran tartalmazzák a forrásmegjelölési információkat.

Az OpenAI tagja a Tartalom Eredetéért és Hitelességéért Koalíciónak (C2PA), így a Sora videók C2PA metaadatokat tartalmaznak majd. Ezt a tartalomhitelesség-kezdeményezés ellenőrző eszközével ellenőrizheted:

A metaadatok ellenőrzése:

- Látogasson el a verify.contentauthenticity.org oldalra

- Töltse fel az ellenőrizni kívánt fájlt.

- Nyomja meg a „Megnyitás” gombot

- Lásd a jobb oldali táblázatban található információkat.

Ha a videót mesterséges intelligencia készítette, az összefoglaló ezt egyértelműen fel fogja tüntetni. A Sora-videók ellenőrzésekor látni fogja az „OpenAI által közzétéve” sort, valamint azt az információt, hogy a videó mesterséges intelligenciával készült. Minden Sora-videónak tartalmaznia kell ezt az információt az eredetének igazolásához.

Forrás: https://vtcnews.vn/cach-nhan-biet-video-that-hay-do-ai-tao-ar972891.html

![[Kép] A vietnami női futball kitartó küzdőszelleme](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F17%2F1765990260956_ndo_br_4224760955870434771-copy-jpg.webp&w=3840&q=75)

![[Fotó] Pham Minh Chinh miniszterelnök fogadja Thongsalith Mangnormek laoszi oktatási és sportminisztert](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765876834721_dsc-7519-jpg.webp&w=3840&q=75)

![[Kép] Kiszivárgott képek a 2025-ös Közösségi Akciódíjak gálája előtt.](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765882828720_ndo_br_thiet-ke-chua-co-ten-45-png.webp&w=3840&q=75)

![[Fotó] Pham Minh Chinh miniszterelnök fogadja Tochigi tartomány (Japán) kormányzóját](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765892133176_dsc-8082-6425-jpg.webp&w=3840&q=75)

![[Élő] 2025-ös Közösségi Akció Díjátadó Gála](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765899631650_ndo_tr_z7334013144784-9f9fe10a6d63584c85aff40f2957c250-jpg.webp&w=3840&q=75)

![[Élő] Záróünnepség és díjátadó a "Lenyűgöző vietnami turizmus" videó-/klipkészítő versenyen 2025](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/12/17/1765974650260_z7273498850699-00d2fd6b0972cb39494cfa2559bf85ac-1765959338756946072104-627-0-1338-1138-crop-1765959347256801551121.jpeg)

Hozzászólás (0)