រូបភាពស្មុគស្មាញនៃការប្រើប្រាស់មនុស្សយន្តឃាតករ AI។

ការអនុញ្ញាតឱ្យបញ្ញាសិប្បនិម្មិត (AI) គ្រប់គ្រងប្រព័ន្ធអាវុធអាចមានន័យថាគោលដៅត្រូវបានកំណត់អត្តសញ្ញាណ វាយប្រហារ និងបំផ្លាញចោលដោយគ្មានអន្តរាគមន៍ពីមនុស្ស។ នេះបង្កើនសំណួរផ្លូវច្បាប់ និងសីលធម៌ធ្ងន់ធ្ងរ។

ដោយសង្កត់ធ្ងន់លើភាពធ្ងន់ធ្ងរនៃស្ថានភាពនេះ រដ្ឋមន្ត្រីការបរទេស អូទ្រីស លោក Alexander Schallenberg បានថ្លែងថា “នេះគឺជាពេលវេលា Oppenheimer ជំនាន់យើង”។

មនុស្សយន្ត និងអាវុធដែលដំណើរការដោយបញ្ញាសិប្បនិម្មិតកំពុងចាប់ផ្តើមត្រូវបានប្រើប្រាស់យ៉ាងទូលំទូលាយនៅក្នុងយោធានៃប្រទេសជាច្រើន។ រូបថត៖ Forbes

ជាការពិតណាស់ កម្រិតដែល «ទេវតាបានរត់គេចពីពាង» បានក្លាយជាសំណួរដ៏សំខាន់មួយ ដោយសារតែការប្រើប្រាស់យន្តហោះគ្មានមនុស្សបើក និងបញ្ញាសិប្បនិម្មិត (AI) យ៉ាងទូលំទូលាយដោយយោធានៅជុំវិញ ពិភពលោក ។

លោក Wilson Jones អ្នកវិភាគផ្នែកការពារជាតិរបស់ GlobalData បានចែករំលែកថា៖ «ការប្រើប្រាស់យន្តហោះគ្មានមនុស្សបើកដោយរុស្ស៊ី និងអ៊ុយក្រែនក្នុងជម្លោះសម័យទំនើប ការប្រើប្រាស់យន្តហោះគ្មានមនុស្សបើករបស់សហរដ្ឋអាមេរិកក្នុងប្រតិបត្តិការវាយប្រហារគោលដៅនៅក្នុងប្រទេសអាហ្វហ្គានីស្ថាន និងប៉ាគីស្ថាន និងដូចដែលបានបង្ហាញថ្មីៗនេះកាលពីខែមុន ក្នុងនាមជាផ្នែកមួយនៃកម្មវិធី Lavender របស់អ៊ីស្រាអែល បង្ហាញពីរបៀបដែលសមត្ថភាពដំណើរការព័ត៌មានរបស់ AI ត្រូវបានប្រើប្រាស់យ៉ាងសកម្មដោយយោធាពិភពលោកដើម្បីបង្កើនអំណាចវាយលុករបស់ពួកគេ»។

ការស៊ើបអង្កេតដោយការិយាល័យស៊ើបអង្កេតសង្គ្រាមដែលមានមូលដ្ឋាននៅទីក្រុងឡុងដ៍បានរកឃើញថា ប្រព័ន្ធបញ្ញាសិប្បនិម្មិត Lavender របស់យោធាអ៊ីស្រាអែលមានអត្រាភាពត្រឹមត្រូវ 90% ក្នុងការកំណត់អត្តសញ្ញាណបុគ្គលដែលមានទំនាក់ទំនងជាមួយហាម៉ាស មានន័យថា 10% មិនមាន។ នេះបានបណ្តាលឱ្យមានអ្នកស្លាប់និងរបួសដោយសារសមត្ថភាពកំណត់អត្តសញ្ញាណនិងការសម្រេចចិត្តរបស់បញ្ញាសិប្បនិម្មិត។

ជាការគំរាមកំហែងដល់សន្តិសុខពិភពលោក។

ការប្រើប្រាស់ AI តាមរបៀបនេះគូសបញ្ជាក់ពីតម្រូវការសម្រាប់ការគ្រប់គ្រងបច្ចេកវិទ្យានៅក្នុងប្រព័ន្ធអាវុធ។

លោកវេជ្ជបណ្ឌិត Alexander Blanchard អ្នកស្រាវជ្រាវជាន់ខ្ពស់ក្នុងកម្មវិធីគ្រប់គ្រងបញ្ញាសិប្បនិម្មិតនៅវិទ្យាស្ថានស្រាវជ្រាវ សន្តិភាព អន្តរជាតិស្តុកហូម (SIPRI) ដែលជាក្រុមស្រាវជ្រាវឯករាជ្យមួយដែលផ្តោតលើសន្តិសុខសកល បានពន្យល់ទៅកាន់ Army Technology ថា “ការប្រើប្រាស់បញ្ញាសិប្បនិម្មិតនៅក្នុងប្រព័ន្ធអាវុធ ជាពិសេសនៅពេលប្រើសម្រាប់កំណត់គោលដៅ បង្កើនសំណួរជាមូលដ្ឋានអំពីអ្នកដែលយើងជា - មនុស្ស - និងទំនាក់ទំនងរបស់យើងជាមួយសង្គ្រាម និងជាពិសេស ការសន្មត់របស់យើងអំពីរបៀបដែលយើងអាចប្រើអំពើហិង្សាក្នុងជម្លោះប្រដាប់អាវុធ”។

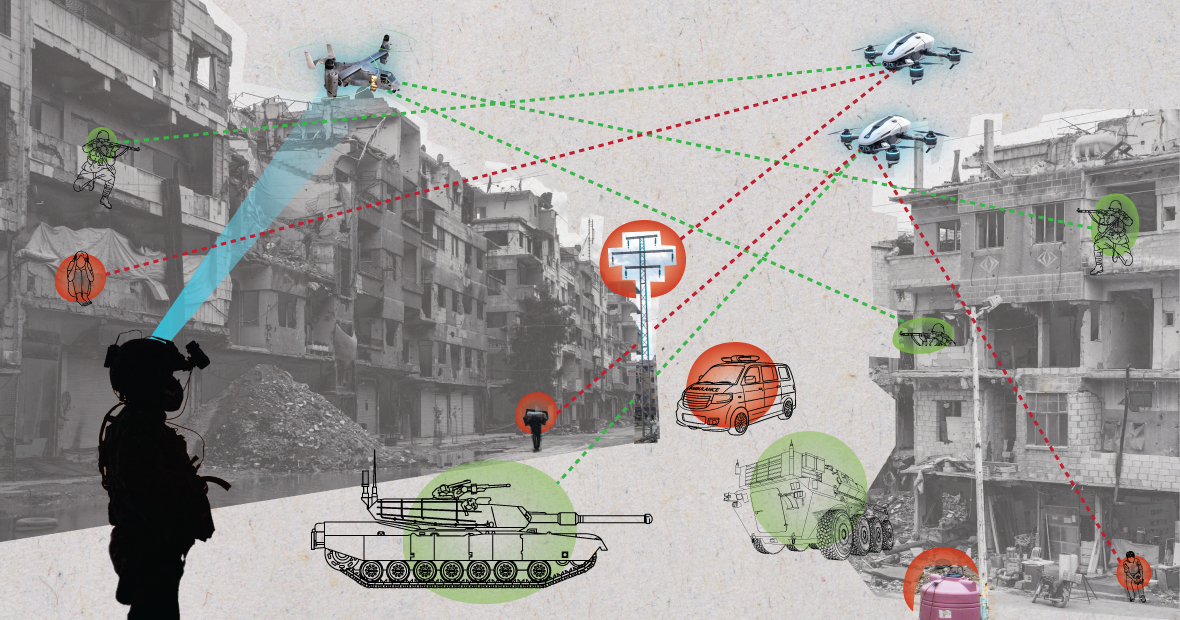

នៅពេលប្រើប្រាស់ក្នុងបរិយាកាសច្របូកច្របល់ ប្រព័ន្ធ AI អាចដំណើរការដោយមិនអាចទាយទុកជាមុនបាន ហើយអាចមិនអាចកំណត់អត្តសញ្ញាណគោលដៅបានត្រឹមត្រូវ។ (រូបភាព៖ MES)

លោកវេជ្ជបណ្ឌិត Blanchard បានបន្ថែមថា «តើ AI នឹងផ្លាស់ប្តូររបៀបដែលយោធាជ្រើសរើសគោលដៅ និងអនុវត្តកម្លាំងទៅលើពួកគេដែរឬទេ? ការផ្លាស់ប្តូរទាំងនេះ ជាថ្នូរនឹងការលើកឡើងនូវសំណួរផ្នែកច្បាប់ សីលធម៌ និងប្រតិបត្តិការជាច្រើន។ ក្តីបារម្ភធំបំផុតគឺមនុស្សធម៌»។

អ្នកជំនាញ SIPRI បានពន្យល់ថា “មនុស្សជាច្រើនមានការព្រួយបារម្ភថា អាស្រ័យលើរបៀបដែលប្រព័ន្ធស្វ័យប្រវត្តិត្រូវបានរចនា និងប្រើប្រាស់ ពួកវាអាចធ្វើឱ្យជនស៊ីវិល និងអ្នកដទៃទៀតដែលត្រូវបានការពារដោយច្បាប់អន្តរជាតិប្រឈមនឹងហានិភ័យខ្ពស់នៃគ្រោះថ្នាក់។ នេះដោយសារតែប្រព័ន្ធ AI ជាពិសេសនៅពេលប្រើប្រាស់ក្នុងបរិយាកាសវឹកវរ អាចដំណើរការដោយមិនអាចទាយទុកជាមុនបាន ហើយអាចបរាជ័យក្នុងការកំណត់អត្តសញ្ញាណគោលដៅ និងវាយប្រហារជនស៊ីវិលបានយ៉ាងត្រឹមត្រូវ ឬបរាជ័យក្នុងការកំណត់អត្តសញ្ញាណអ្នកប្រយុទ្ធដែលនៅក្រៅខ្សែបន្ទាត់បាញ់”។

ដោយពន្យល់អំពីបញ្ហានេះ លោក Wilson Jones អ្នកវិភាគផ្នែកការពារជាតិរបស់ GlobalData បានកត់សម្គាល់ថា សំណួរអំពីរបៀបដែលកំណត់ពីកំហុសអាចនឹងត្រូវបានសួរឡើង។

លោក Jones បានមានប្រសាសន៍ថា «ក្រោមច្បាប់សង្គ្រាមបច្ចុប្បន្ន មានគោលគំនិតនៃការទទួលខុសត្រូវក្នុងការបញ្ជា»។ «នេះមានន័យថា មន្ត្រី ឧត្តមសេនីយ៍ ឬមេដឹកនាំផ្សេងទៀត ទទួលខុសត្រូវតាមផ្លូវច្បាប់ចំពោះសកម្មភាពរបស់កងទ័ពក្រោមបញ្ជារបស់ពួកគេ។ ប្រសិនបើកងទ័ពប្រព្រឹត្តបទឧក្រិដ្ឋសង្គ្រាម មន្ត្រីនោះត្រូវទទួលខុសត្រូវ ទោះបីជាពួកគេមិនបានចេញបញ្ជាក៏ដោយ។ បន្ទុកនៃភស្តុតាងស្ថិតនៅលើពួកគេ ដោយបង្ហាញថាពួកគេបានធ្វើអ្វីគ្រប់យ៉ាងដែលអាចធ្វើទៅបានដើម្បីទប់ស្កាត់បទឧក្រិដ្ឋសង្គ្រាម»។

លោក Jones បានសង្កត់ធ្ងន់ថា «ជាមួយនឹងប្រព័ន្ធ AI នេះធ្វើឱ្យរឿងស្មុគស្មាញ។ តើអ្នកបច្ចេកទេស IT ទទួលខុសត្រូវទេ? ជាអ្នករចនាប្រព័ន្ធ? វាមិនច្បាស់លាស់ទេ។ ប្រសិនបើវាមិនច្បាស់លាស់ទេ នោះវាបង្កើតគ្រោះថ្នាក់ខាងសីលធម៌ ប្រសិនបើអ្នកដើរតួគិតថាសកម្មភាពរបស់ពួកគេមិនត្រូវបានការពារដោយច្បាប់ដែលមានស្រាប់»។

ទាហានអាមេរិកម្នាក់កំពុងល្បាតជាមួយឆ្កែរ៉ូបូត។ រូបថត៖ Forbes

អនុសញ្ញាគ្រប់គ្រងអាវុធ៖ កិច្ចព្រមព្រៀងអន្តរជាតិសំខាន់ៗមួយចំនួនរឹតត្បិត និងគ្រប់គ្រងការប្រើប្រាស់អាវុធមួយចំនួន។ ទាំងនេះរួមមាន ការហាមឃាត់អាវុធគីមី សន្ធិសញ្ញាមិនរីកសាយភាយអាវុធនុយក្លេអ៊ែរ និងអនុសញ្ញាស្តីពីអាវុធធម្មតាមួយចំនួន ដែលហាមឃាត់ ឬរឹតត្បិតការប្រើប្រាស់អាវុធជាក់លាក់ដែលត្រូវបានចាត់ទុកថាបង្កការឈឺចាប់ដែលមិនចាំបាច់ ឬមិនអាចប្រកែកបានចំពោះយុទ្ធជន ឬប៉ះពាល់ដល់ជនស៊ីវិលដោយមិនរើសអើង។

លោក Wilson Jones អ្នកវិភាគការពារជាតិបានពន្យល់ថា «ការគ្រប់គ្រងអាវុធនុយក្លេអ៊ែរតម្រូវឱ្យមានកិច្ចសហប្រតិបត្តិការអន្តរជាតិរាប់ទសវត្សរ៍ និងសន្ធិសញ្ញាជាបន្តបន្ទាប់ដើម្បីអាចអនុវត្តបាន»។ «សូម្បីតែពេលនោះក៏ដោយ យើងបានបន្តការធ្វើតេស្តបរិយាកាសរហូតដល់ទសវត្សរ៍ឆ្នាំ 1990។ ហេតុផលចម្បងមួយសម្រាប់ភាពជោគជ័យនៃការមិនរីកសាយអាវុធនុយក្លេអ៊ែរគឺកិច្ចសហប្រតិបត្តិការរវាងសហរដ្ឋអាមេរិក និងសហភាពសូវៀតក្នុងសណ្តាប់ធ្នាប់ពិភពលោកបាយប៉ូឡា។ នោះលែងមានទៀតហើយ ហើយបច្ចេកវិទ្យា AI បានក្លាយជាអាចចូលដំណើរការបានកាន់តែច្រើនសម្រាប់ប្រទេសជាច្រើនជាងថាមពលអាតូមិក»។

«សន្ធិសញ្ញាដែលមានកាតព្វកិច្ចមួយ នឹងត្រូវនាំភាគីពាក់ព័ន្ធទាំងអស់មកតុចរចា ដើម្បីយល់ព្រមមិនប្រើប្រាស់ឧបករណ៍ដែលបង្កើនអំណាចយោធារបស់ពួកគេ។ នោះទំនងជាមិនមានប្រសិទ្ធភាពទេ ពីព្រោះបញ្ញាសិប្បនិម្មិត (AI) អាចបង្កើនប្រសិទ្ធភាពយោធាជាមួយនឹងការចំណាយហិរញ្ញវត្ថុ និងសម្ភារៈតិចតួចបំផុត»។

ទស្សនៈភូមិសាស្ត្រនយោបាយបច្ចុប្បន្ន

ទោះបីជាប្រទេសនានានៅអង្គការសហប្រជាជាតិបានទទួលស្គាល់ពីតម្រូវការសម្រាប់ការប្រើប្រាស់បញ្ញាសិប្បនិម្មិត (AI) ដោយមានការទទួលខុសត្រូវដោយយោធាក៏ដោយ ក៏នៅតែមានការងារជាច្រើនដែលត្រូវធ្វើ។

លោកស្រី Laura Petrone អ្នកវិភាគសំខាន់នៅ GlobalData បានប្រាប់ Army Technology ថា “ដោយសារតែខ្វះក្របខ័ណ្ឌគ្រប់គ្រងច្បាស់លាស់ សេចក្តីថ្លែងការណ៍ទាំងនេះនៅតែមានមហិច្ឆតាខ្ពស់។ វាមិនមែនជារឿងគួរឱ្យភ្ញាក់ផ្អើលទេដែលប្រទេសមួយចំនួនចង់រក្សាអធិបតេយ្យភាពរបស់ខ្លួននៅពេលសម្រេចចិត្តលើបញ្ហាការពារជាតិ និងសន្តិសុខជាតិ ជាពិសេសនៅក្នុងបរិបទនៃភាពតានតឹងភូមិសាស្ត្រនយោបាយបច្ចុប្បន្ន”។

លោកស្រី Petrone បានបន្ថែមថា ខណៈពេលដែលច្បាប់ AI របស់សហភាពអឺរ៉ុបកំណត់តម្រូវការមួយចំនួនសម្រាប់ប្រព័ន្ធ AI វាមិនដោះស្រាយប្រព័ន្ធ AI សម្រាប់គោលបំណងយោធានោះទេ។

លោកស្រីបានអត្ថាធិប្បាយថា «ខ្ញុំគិតថា បើទោះជាមានការដកចេញនេះក៏ដោយ ច្បាប់ AI គឺជាកិច្ចខិតខំប្រឹងប្រែងដ៏សំខាន់មួយដើម្បីបង្កើតក្របខ័ណ្ឌដែលមានរយៈពេលយូរសម្រាប់កម្មវិធី AI ដែលអាចនាំទៅដល់កម្រិតជាក់លាក់មួយនៃការចុះសម្រុងគ្នានៃស្តង់ដារពាក់ព័ន្ធនាពេលអនាគត»។ «ការចុះសម្រុងគ្នានេះក៏នឹងមានសារៈសំខាន់សម្រាប់ AI ក្នុងវិស័យយោធាផងដែរ»។

ង្វៀន ខាញ់

[ការផ្សាយពាណិជ្ជកម្ម_២]

ប្រភព៖ https://www.congluan.vn/moi-nguy-robot-sat-thu-ai-dang-de-doa-an-ninh-toan-cau-post304170.html

![[រូបភាព] ការិយាល័យកណ្តាលបក្សសង្ខេបការងារនៅឆ្នាំ ២០២៥](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F18%2F1766065572073_vptw-hoi-nghi-tong-ket-89-1204-jpg.webp&w=3840&q=75)

Kommentar (0)