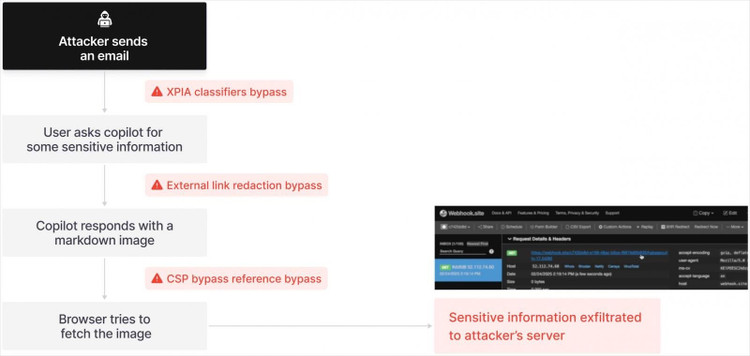

ដោយគ្រាន់តែអ៊ីមែលដែលហាក់ដូចជាគ្មានគ្រោះថ្នាក់ ជំនួយការ Microsoft Copilot AI អាចបង្ហាញទិន្នន័យសម្ងាត់ដោយស្វ័យប្រវត្តិដោយមិនមានការអន្តរាគមន៍ពីអ្នកប្រើប្រាស់ណាមួយឡើយ។

កំហុសសុវត្ថិភាពធ្ងន់ធ្ងរត្រូវបានរកឃើញនៅក្នុង Microsoft 365 Copilot ដែលជាជំនួយការ AI ដែលត្រូវបានបង្កើតឡើងនៅក្នុងឈុតការិយាល័យនៃកម្មវិធីដូចជា Word, Excel, Outlook, PowerPoint និងក្រុម។ ការរកឃើញនេះ ត្រូវបានផ្សព្វផ្សាយជាសាធារណៈដោយក្រុមហ៊ុនសន្តិសុខអ៊ីនធឺណិត Aim Security ធ្វើឱ្យមានការព្រួយបារម្ភអំពីការវាយប្រហារលើភ្នាក់ងារ AI ។

ពួក Hacker គ្រាន់តែត្រូវការផ្ញើទៅអ្នកប្រើនូវអ៊ីមែលដែលមានតំណនោះ Copilot នឹងប្រតិបត្តិដោយខ្លួនឯងដោយមិនចាំបាច់បើកអ៊ីមែលនោះទេ។

ភាពងាយរងគ្រោះនេះ ត្រូវបានគេដាក់ឈ្មោះថា EchoLeak ដោយ Aim Security អនុញ្ញាតឱ្យអ្នកវាយប្រហារចូលប្រើទិន្នន័យសំខាន់ៗ ដោយគ្មានសកម្មភាពណាមួយពីអ្នកប្រើប្រាស់។ វាគឺជាការវាយប្រហារ "សូន្យចុច" ដែលគេស្គាល់ជាលើកដំបូងប្រឆាំងនឹងភ្នាក់ងារ AI ដែលជាប្រព័ន្ធដែលប្រើគំរូភាសាធំ (LLM) ដើម្បីបំពេញភារកិច្ចដោយស្វ័យប្រវត្តិ។

ជាលើកដំបូង AI ត្រូវបានវាយប្រហារ

ក្នុងករណី Microsoft Copilot អ្នកវាយប្រហារគ្រាន់តែផ្ញើអ៊ីមែលដែលមានតំណភ្ជាប់លាក់ទៅអ្នកប្រើប្រាស់។ ដោយសារ Copilot ស្កេនអ៊ីមែលដោយស្វ័យប្រវត្តិក្នុងផ្ទៃខាងក្រោយ វាអាន និងប្រតិបត្តិពាក្យបញ្ជាទាំងនេះដោយមិនចាំបាច់មានអន្តរកម្មពីអ្នកទទួល។ ជាលទ្ធផល AI អាចត្រូវបានរៀបចំដើម្បីចូលប្រើ និងទាញយកឯកសារ សៀវភៅបញ្ជី និងសារខាងក្នុង ហើយបញ្ជូនទិន្នន័យត្រឡប់ទៅពួក Hacker វិញ។

"យើងសូមថ្លែងអំណរគុណចំពោះ Aim Security សម្រាប់ការកំណត់អត្តសញ្ញាណ និងរាយការណ៍បញ្ហានេះដោយការទទួលខុសត្រូវ ដូច្នេះវាអាចត្រូវបានដោះស្រាយមុនពេលអតិថិជនរងផលប៉ះពាល់។ ការធ្វើបច្ចុប្បន្នភាពផលិតផលត្រូវបានដាក់ឱ្យប្រើប្រាស់ ហើយមិនតម្រូវឱ្យមានសកម្មភាពណាមួយពីអ្នកប្រើប្រាស់នោះទេ" អ្នកនាំពាក្យរបស់ Microsoft បានបញ្ជាក់ទៅកាន់ Fortune ។

ទោះជាយ៉ាងណាក៏ដោយ យោងទៅតាម Aim Security បញ្ហាគឺកាន់តែស៊ីជម្រៅនៅក្នុងការរចនាមូលដ្ឋាននៃភ្នាក់ងារ AI ។ Adir Gruss សហស្ថាបនិក និង CTO នៃ Aim Security បាននិយាយថា ភាពងាយរងគ្រោះ EchoLeak គឺជាសញ្ញាមួយបង្ហាញថា ប្រព័ន្ធ AI បច្ចុប្បន្នកំពុងធ្វើម្តងទៀតនូវកំហុសសុវត្ថិភាពពីអតីតកាល។

លោក Gruss បាននិយាយថា "យើងបានរកឃើញភាពងាយរងគ្រោះជាបន្តបន្ទាប់ដែលអនុញ្ញាតឱ្យអ្នកវាយប្រហារធ្វើប្រតិបត្តិការដែលស្មើនឹងការវាយប្រហារដោយចុចសូន្យនៅលើទូរស័ព្ទ ប៉ុន្តែលើកនេះប្រឆាំងនឹងប្រព័ន្ធ AI" ។ គាត់បាននិយាយថាក្រុមនេះបានចំណាយពេលប្រហែល 3 ខែដើម្បីធ្វើការវិភាគនិងវិស្វកម្មបញ្ច្រាស Microsoft Copilot ដើម្បីកំណត់ពីរបៀបដែល AI អាចត្រូវបានរៀបចំ។

ទោះបីជាក្រុមហ៊ុន Microsoft បានឆ្លើយតប និងដាក់ពង្រាយបំណះក៏ដោយ Gruss បាននិយាយថា ការជួសជុលរយៈពេលប្រាំខែគឺជា "រយៈពេលយូរសម្រាប់ភាពធ្ងន់ធ្ងរនៃបញ្ហា" ។ លោកបានពន្យល់ថា នេះមួយផ្នែកដោយសារតែភាពថ្មីនៃគំនិតនៃភាពងាយរងគ្រោះ និងពេលវេលាដែលវាត្រូវការសម្រាប់ក្រុមវិស្វកររបស់ Microsoft ដើម្បីកំណត់អត្តសញ្ញាណ និងធ្វើសកម្មភាព។

គុណវិបត្តិនៃការរចនាជាប្រវត្តិសាស្ត្រកើតឡើងជាថ្មី ដែលគំរាមកំហែងដល់ឧស្សាហកម្មបច្ចេកវិទ្យាទាំងមូល

យោងតាម Gruss EchoLeak ប៉ះពាល់មិនត្រឹមតែ Copilot ប៉ុណ្ណោះទេ ប៉ុន្តែវាក៏អាចត្រូវបានអនុវត្តចំពោះវេទិកាស្រដៀងគ្នាដូចជា Agentforce (Salesforce) ឬពិធីការ MCP របស់ Anthropic ផងដែរ។

Gruss បាននិយាយថា "ប្រសិនបើខ្ញុំកំពុងដឹកនាំក្រុមហ៊ុនដែលកំពុងដាក់ពង្រាយភ្នាក់ងារ AI នោះ ខ្ញុំនឹងមានការភ័យខ្លាច។ នេះគឺជាប្រភេទនៃគុណវិបត្តិនៃការរចនាដែលបានបណ្តាលឱ្យខូចខាតជាច្រើនទសវត្សរ៍នៅក្នុងឧស្សាហកម្មបច្ចេកវិទ្យា ហើយឥឡូវនេះវាត្រលប់មកវិញជាមួយនឹង AI" ។

មូលហេតុឫសគល់នៃបញ្ហានេះគឺថាភ្នាក់ងារ AI បច្ចុប្បន្នមិនបែងចែករវាងទិន្នន័យដែលគួរឱ្យទុកចិត្ត និងមិនគួរឱ្យទុកចិត្ត។ Gruss ជឿជាក់ថាដំណោះស្រាយរយៈពេលវែងគឺរៀបចំឡើងវិញទាំងស្រុងនូវវិធីដែលភ្នាក់ងារ AI ត្រូវបានបង្កើតឡើង ដោយមានសមត្ថភាពបែងចែកយ៉ាងច្បាស់រវាងទិន្នន័យត្រឹមត្រូវ និងព័ត៌មានគ្រោះថ្នាក់។

បច្ចុប្បន្ន Aim Security កំពុងផ្តល់នូវការកាត់បន្ថយបណ្តោះអាសន្នសម្រាប់អតិថិជនមួយចំនួនដែលប្រើប្រាស់ភ្នាក់ងារ AI ។ ទោះជាយ៉ាងណាក៏ដោយ នេះគ្រាន់តែជាការជួសជុលបណ្ដោះអាសន្នប៉ុណ្ណោះ ហើយការរចនាប្រព័ន្ធថ្មីអាចធានាសុវត្ថិភាពព័ត៌មានសម្រាប់អ្នកប្រើប្រាស់។

Aim Security CTO បាននិយាយថា "រាល់ក្រុមហ៊ុន Fortune 500 ដែលខ្ញុំស្គាល់មានការភ័យខ្លាចក្នុងការដាក់ពង្រាយភ្នាក់ងារ AI ទៅក្នុងផលិតកម្ម។ ពួកគេអាចនឹងកំពុងធ្វើការពិសោធន៍ ប៉ុន្តែភាពងាយរងគ្រោះបែបនេះធ្វើឱ្យពួកគេភ្ញាក់នៅពេលយប់ និងបន្ថយការច្នៃប្រឌិត" ។

ប្រភព៖ https://khoahocdoisong.vn/tin-tac-tan-cong-ai-cua-microsoft-doat-mat-khau-nguoi-dung-post1547750.html

![[រូបថត] នាយករដ្ឋមន្ត្រី Pham Minh Chinh ចូលរួមកម្មវិធីសិល្បៈពិសេសមួយដែលមានឈ្មោះថា "ហាណូយ - ពីរដូវស្លឹកឈើជ្រុះជាប្រវត្តិសាស្ត្រឆ្នាំ 1945"](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/8/15/c1c42655275c40d1be461fee0fd132f3)

![[រូបថត] អគ្គលេខាធិការចូលរួមពិធីសម្ពោធទីស្នាក់ការក្រសួងសន្តិសុខសាធារណៈ](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/8/16/3ceec3a24ef945c18ae2b523563b749d)

![[រូបថត] នាយករដ្ឋមន្ត្រី Pham Minh Chinh សន្ទនាតាមទូរស័ព្ទជាមួយនាយករដ្ឋមន្ត្រីកម្ពុជា ហ៊ុន ម៉ាណែត](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/8/15/72d3838db8154bafabdadc0a5165677f)

![[រូបថត] “ឆ្ពោះទៅមុខជាមួយវៀតណាម” នៅលើផ្លូវស្នេហាបំផុតនៅក្នុងប្រទេសវៀតណាម](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/8/16/0ee500bc59fd4468863261ee26f47fe7)

![[រូបថត] ពិធីលើកទង់ដ៏ពិសិដ្ឋ "ខ្ញុំស្រឡាញ់មាតុភូមិរបស់ខ្ញុំ" បានធ្វើឡើងក្នុងពេលដំណាលគ្នានៅទូទាំងប្រទេស។](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/8/16/bc88d86d5270494c98dc9a6e722206e9)

![[រូបថត] ប្រធានរដ្ឋសភាលោក Tran Thanh Man ចូលរួមពិធីសម្ពោធវិមានអនុស្សាវរីយ៍ប្រធានាធិបតី Ton Duc Thang](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/8/16/23555950872d428a8708a1e2f94cbf59)

![[រូបថត] តារាក្រហម និងលឿង ក្នុងពិធីសម្ពោធកម្មវិធី "ឆ្ពោះទៅមុខជាមួយវៀតណាម"](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/8/16/076df6ed0eb345cfa3d1cd1d7591a66f)

Kommentar (0)