인스타그램 앱의 모회사인 메타(Meta)는 청소년이 메타 플랫폼을 사용할 때 이를 보호하기 위한 일련의 새로운 안전 기능을 발표했습니다. 여기에는 청소년에게 메시지를 보낸 계정에 대한 정보를 표시하는 기능과 한 번의 탭으로 차단 및 신고하는 옵션이 포함됩니다.

메타는 또한 성적으로 노골적인 댓글을 남기거나 노골적인 이미지를 요청한 수천 개의 계정을 삭제했다고 밝혔습니다. 해당 계정들은 성인이 소유했지만 13세 미만 아동으로 위장한 것으로 확인되었습니다. 회사 블로그에 게시된 성명에 따르면, 이 중 13만 5천 개는 댓글을 달기 위한 계정이었고, 50만 개는 "부적절한 상호작용"을 위한 계정이었습니다.

이러한 조치는 소셜 미디어 플랫폼이 젊은 사용자의 정신 건강과 안전에 미치는 영향에 대한 감시가 강화되는 가운데 나온 것으로, 특히 누드 사진으로 유인되거나 협박을 받을 위험에 대한 우려가 커지고 있습니다.

Meta에 따르면, 사용자에게 "개인 메시지를 보낼 때 주의하고, 불편한 사항이 있으면 신고하세요"라는 안전 알림 덕분에 100만 개 이상의 계정이 차단되었고 100만 건 이상의 위반 사항이 신고되었습니다.

올해 초, Meta는 13세 이상만 이용 가능한 플랫폼인 Instagram에서 나이를 속인 사용자를 감지하기 위해 인공지능(AI) 기술을 테스트하기 시작했습니다.

위반 사항이 감지되면 해당 계정은 자동으로 성인 계정보다 제한 사항이 더 많은 주니어 계정으로 전환됩니다.

청소년 계정은 기본적으로 비공개로 설정되어 팔로우하거나 이전에 연락했던 사람의 메시지만 허용됩니다. 이 정책은 2024년부터 적용됩니다.

메타는 현재 미국 수십 개 주에서 여러 건의 소송에 직면해 있습니다. 소송 내용은 회사가 인스타그램과 페이스북에 의도적으로 중독성 있는 기능을 설계하여 청소년의 정신 건강을 해쳤다는 것입니다.

(TTXVN/베트남+)

출처: https://www.vietnamplus.vn/meta-tang-cuong-bien-phap-bao-ve-thieu-nien-tren-instagram-post1051542.vnp

![[사진] 까마우, 올해 최고 조수에 대처 "힘들게"…경계 수준 3 넘어설 듯](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/04/1762235371445_ndo_br_trieu-cuong-2-6486-jpg.webp)

![[사진] 호치민시 청소년, 깨끗한 환경을 위해 행동하다](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/04/1762233574890_550816358-1108586934787014-6430522970717297480-n-1-jpg.webp)

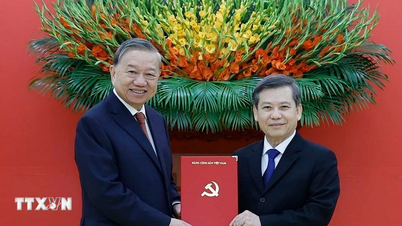

![[사진] 응우옌 두이 응옥 동지, 하노이 당위원회 서기직 맡아](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/04/1762234472658_a1-bnd-5518-8538-jpg.webp)

![[사진] 정부, 베트남 국제금융센터 관련 8개 법령 특별회의 개최](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/04/1762229370189_dsc-9764-jpg.webp)

댓글 (0)