미국의 로봇 이모는 반대편 사람이 미소 짓기 약 840밀리초 전에 미소를 예측할 수 있으며, 그 순간 상대방도 동시에 미소 짓습니다.

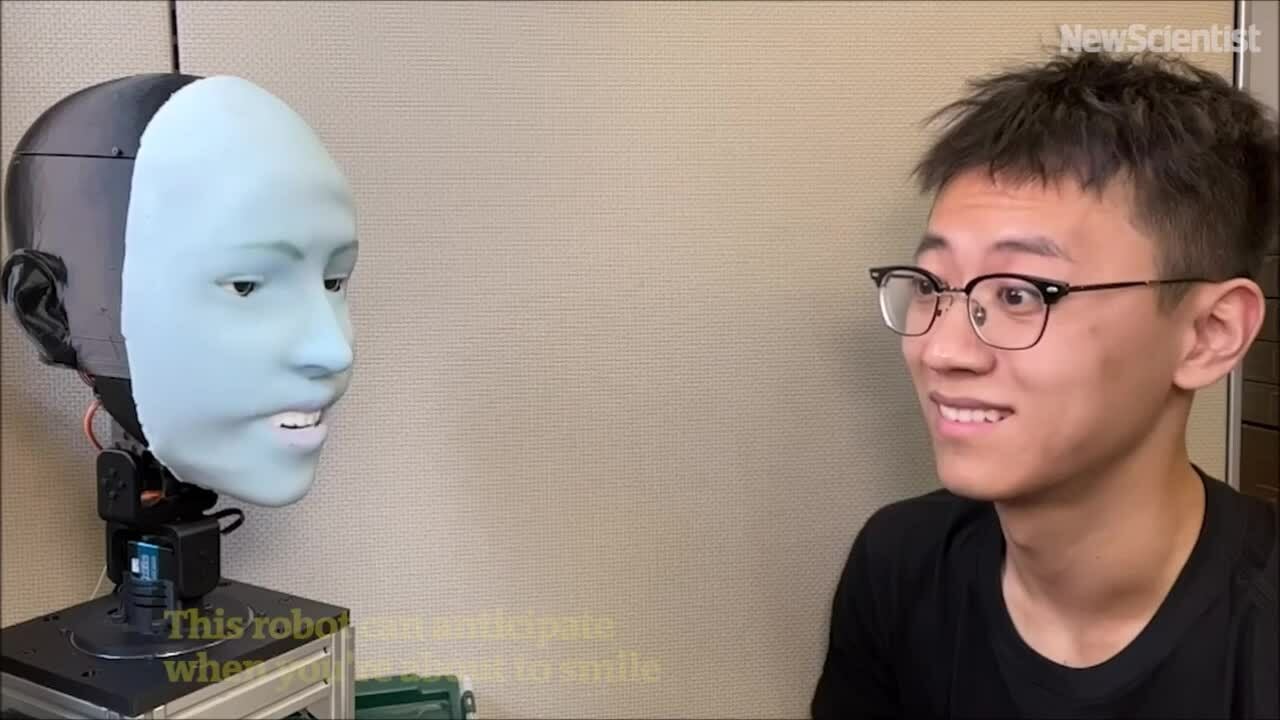

이모 로봇은 상대방의 표정을 예측하고 동시에 미소를 지을 수 있습니다. 영상 : New Scientist

ChatGPT와 같은 대규모 언어 모델의 발전 덕분에 인간은 유창하게 음성으로 소통할 수 있는 로봇에 점차 익숙해지고 있지만, 비언어적 의사소통 능력, 특히 얼굴 표정은 아직 크게 뒤처져 있습니다. 다양한 표정을 표현할 수 있을 뿐만 아니라 적절한 시기에 표정을 표현할 줄 아는 로봇을 설계하는 것은 매우 어렵습니다.

컬럼비아 대학교 공과대학의 크리에이티브 머신 랩(Creative Machines Lab)은 이 문제를 5년 넘게 연구해 왔습니다. 3월 27일 TechXplore 보도에 따르면, 사이언스 로보틱스(Science Robotics) 저널에 발표된 새로운 연구에서 연구팀은 사람의 얼굴 표정을 예측하고 실시간으로 표현할 수 있는 AI 로봇인 이모(Emo)를 선보였습니다. 이 로봇은 사람이 미소 짓기 약 840밀리초 전에 미소를 예측하고, 그 후에야 미소를 짓습니다.

에모는 얼굴에 26개의 액추에이터를 장착하여 다양한 표정을 표현할 수 있는 휴머노이드 로봇입니다. 로봇의 머리는 부드러운 실리콘 피부로 덮여 있으며, 자석 연결 시스템을 통해 빠른 조정과 유지 보수가 가능합니다. 더욱 몰입감 있는 상호작용을 위해 연구팀은 각 눈의 동공에 고해상도 카메라를 통합하여 에모가 눈과 상호작용할 수 있도록 했습니다. 이는 비언어적 의사소통에 중요한 요소입니다.

연구팀은 두 가지 AI 모델을 개발했습니다. 첫 번째 모델은 상대방 얼굴의 미묘한 변화를 분석하여 사람의 표정을 예측했고, 두 번째 모델은 해당 표정을 이용하여 운동 명령을 생성했습니다.

로봇이 감정을 표현하도록 훈련시키기 위해 연구팀은 에모를 카메라 앞에 두고 무작위로 움직이도록 했습니다. 몇 시간 후, 로봇은 얼굴 표정과 운동 명령 사이의 관계를 학습했습니다. 마치 인간이 거울을 보며 표정을 연습하는 것과 유사했습니다. 연구팀은 이를 "자기 모델링"이라고 부르는데, 이는 인간이 특정 표정을 짓는 자신의 모습을 상상하는 것과 유사합니다.

다음으로, 연구팀은 에모가 프레임 단위로 관찰할 수 있도록 사람의 얼굴 표정 영상을 재생했습니다. 몇 시간의 훈련 끝에, 에모는 사람이 미소를 짓기 시작할 때 얼굴의 미묘한 변화를 관찰하여 표정을 예측할 수 있었습니다.

"인간의 얼굴 표정을 정확하게 예측하는 것은 인간-로봇 상호작용 분야의 혁명이라고 생각합니다. 이전에는 로봇이 상호작용 중에 인간의 표정을 고려하도록 설계되지 않았습니다. 이제 로봇은 얼굴 표정을 통합하여 반응할 수 있습니다."라고 크리에이티브 머신 랩 박사 과정생이자 연구팀의 일원인 위항 후는 말했습니다.

"로봇이 사람과 동시에 실시간으로 표정을 지을 수 있게 되면 상호작용의 질이 향상될 뿐만 아니라 사람과 로봇 간의 신뢰도 구축하는 데에도 도움이 됩니다. 미래에는 로봇과 상호작용할 때 마치 실제 사람처럼 사람의 표정을 관찰하고 해석하게 될 것입니다."라고 후는 덧붙였습니다.

Thu Thao ( TechXplore 에 따르면)

[광고_2]

소스 링크

![[해양뉴스] 세계 컨테이너 운송량 80% 이상 MSC 및 주요 해운 동맹에 집중돼](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/7/16/6b4d586c984b4cbf8c5680352b9eaeb0)

댓글 (0)