ການພັດທະນາຢ່າງໄວວາຂອງປັນຍາປະດິດ (AI) ໄດ້ເຮັດໃຫ້ເກີດຄວາມກັງວົນວ່າມັນກໍາລັງພັດທະນາໄວກວ່າທີ່ມະນຸດສາມາດເຂົ້າໃຈຜົນກະທົບຂອງມັນ.

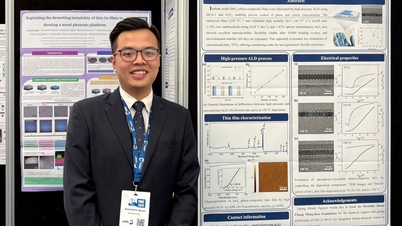

ຮູບພາບ: ST

ການນໍາໃຊ້ AI ທົ່ວໄປໄດ້ເພີ່ມຂຶ້ນຢ່າງຫຼວງຫຼາຍຫຼັງຈາກການປະກົດຕົວຂອງເຄື່ອງມືເຊັ່ນ ChatGPT. ໃນຂະນະທີ່ເຄື່ອງມືເຫຼົ່ານີ້ມີປະໂຫຍດຫຼາຍ, ພວກມັນຍັງສາມາດຖືກນໍາໃຊ້ໃນທາງທີ່ເປັນອັນຕະລາຍ.

ເພື່ອຄຸ້ມຄອງຄວາມສ່ຽງນີ້, ສະຫະລັດແລະປະເທດອື່ນໆຈໍານວນຫນຶ່ງໄດ້ຮັບປະກັນຂໍ້ຕົກລົງຈາກ 7 ບໍລິສັດ, ລວມທັງ Amazon, Anthropic, Google, Inflection, Meta, Microsoft, ແລະ OpenAI, ເພື່ອປະຕິບັດການປະຕິບັດທີ່ປອດໄພໃນການພັດທະນາເຕັກໂນໂລຢີ AI.

ການປະກາດຂອງ ທຳ ນຽບຂາວມາພ້ອມກັບ ຄຳ ສັບຂອງຕົນເອງທີ່ອາດຈະບໍ່ຄຸ້ນເຄີຍກັບຄົນທົ່ວໄປ, ໂດຍມີ ຄຳ ສັບຕ່າງໆເຊັ່ນ "ການເປັນທີມສີແດງ" ແລະ "ການໃສ່ນ້ ຳ". ນີ້ແມ່ນເຈັດເງື່ອນໄຂທີ່ກ່ຽວຂ້ອງກັບ AI ທີ່ຕ້ອງລະວັງ.

ການຮຽນຮູ້ເຄື່ອງຈັກ

ສາຂາຂອງ AI ນີ້ມີຈຸດປະສົງເພື່ອຝຶກອົບຮົມເຄື່ອງຈັກເພື່ອປະຕິບັດວຽກງານສະເພາະໃດຫນຶ່ງຢ່າງຖືກຕ້ອງໂດຍການກໍານົດຮູບແບບ. ຫຼັງຈາກນັ້ນເຄື່ອງຈັກສາມາດເຮັດໃຫ້ການຄາດຄະເນໂດຍອີງໃສ່ຂໍ້ມູນນັ້ນ.

ການຮຽນຮູ້ເລິກ

ວຽກງານ AI ສ້າງສັນມັກຈະອີງໃສ່ການຮຽນຮູ້ເລິກ, ວິທີການທີ່ກ່ຽວຂ້ອງກັບການຝຶກອົບຮົມຄອມພິວເຕີໂດຍໃຊ້ເຄືອຂ່າຍ neural, ຊຸດຂອງສູດການຄິດໄລ່ທີ່ອອກແບບມາເພື່ອ mimic neurons ໃນສະຫມອງຂອງມະນຸດ, ເພື່ອເຮັດໃຫ້ການເຊື່ອມຕໍ່ສະລັບສັບຊ້ອນລະຫວ່າງຮູບແບບເພື່ອສ້າງຂໍ້ຄວາມ, ຮູບພາບຫຼືເນື້ອຫາອື່ນໆ.

ເນື່ອງຈາກວ່າຕົວແບບການຮຽນຮູ້ເລິກມີຫຼາຍຊັ້ນຂອງ neurons, ພວກເຂົາສາມາດຮຽນຮູ້ຮູບແບບທີ່ສັບສົນຫຼາຍກ່ວາການຮຽນຮູ້ເຄື່ອງຈັກແບບດັ້ງເດີມ.

ຮູບແບບພາສາຂະຫນາດໃຫຍ່

ຮູບແບບພາສາຂະຫນາດໃຫຍ່, ຫຼື LLM, ແມ່ນການຝຶກອົບຮົມກ່ຽວກັບຂໍ້ມູນຈໍານວນຫລາຍແລະມີຈຸດປະສົງເພື່ອສ້າງແບບຈໍາລອງພາສາຫຼືຄາດຄະເນຄໍາຕໍ່ໄປໃນລໍາດັບ. ຮູບແບບພາສາຂະຫນາດໃຫຍ່, ເຊັ່ນ ChatGPT ແລະ Google Bard, ສາມາດຖືກນໍາໃຊ້ສໍາລັບວຽກງານລວມທັງການສະຫຼຸບ, ການແປພາສາ, ແລະການສົນທະນາ.

ສູດການຄິດໄລ່

ຊຸດຄໍາແນະນໍາຫຼືກົດລະບຽບທີ່ອະນຸຍາດໃຫ້ເຄື່ອງຈັກເຮັດການຄາດເດົາ, ແກ້ໄຂບັນຫາ, ຫຼືສໍາເລັດວຽກງານ. ສູດການຄິດໄລ່ສາມາດໃຫ້ຄໍາແນະນໍາການຊື້ເຄື່ອງແລະຊ່ວຍໃນການກວດສອບການສໍ້ໂກງແລະຫນ້າທີ່ສົນທະນາການບໍລິການລູກຄ້າ.

ອະຄະຕິ

ເນື່ອງຈາກວ່າ AI ໄດ້ຮັບການຝຶກອົບຮົມໂດຍໃຊ້ຊຸດຂໍ້ມູນຂະຫນາດໃຫຍ່, ມັນສາມາດລວມເອົາຂໍ້ມູນທີ່ເປັນອັນຕະລາຍເຂົ້າໄປໃນຂໍ້ມູນ, ເຊັ່ນຄໍາເວົ້າທີ່ກຽດຊັງ. ເຊື້ອຊາດແລະເພດສໍາພັນຍັງສາມາດປາກົດຢູ່ໃນຊຸດຂໍ້ມູນທີ່ໃຊ້ໃນການຝຶກອົບຮົມ AI, ນໍາໄປສູ່ເນື້ອຫາທີ່ເຂົ້າໃຈຜິດ.

ບໍລິສັດ AI ໄດ້ຕົກລົງທີ່ຈະເຈາະເລິກເຂົ້າໄປໃນວິທີການຫຼີກເວັ້ນຄວາມບໍ່ລໍາອຽງທີ່ເປັນອັນຕະລາຍແລະການຈໍາແນກໃນລະບົບ AI.

ທີມສີແດງ

ຫນຶ່ງໃນຄໍາຫມັ້ນສັນຍາທີ່ບໍລິສັດໄດ້ເຮັດກັບທໍານຽບຂາວແມ່ນເພື່ອດໍາເນີນການ "ທີມງານສີແດງ" ພາຍໃນແລະພາຍນອກກ່ຽວກັບຮູບແບບ AI ແລະລະບົບ.

"ທີມງານສີແດງ" ກ່ຽວຂ້ອງກັບການທົດສອບຕົວແບບເພື່ອເປີດເຜີຍຄວາມອ່ອນແອທີ່ເປັນໄປໄດ້. ຄຳສັບນີ້ແມ່ນມາຈາກການປະຕິບັດ ທາງທະຫານ ທີ່ທີມງານຈຳລອງການກະທຳຂອງຜູ້ໂຈມຕີເພື່ອມາສ້າງຍຸດທະສາດ.

ວິທີການນີ້ຖືກນໍາໃຊ້ຢ່າງກວ້າງຂວາງເພື່ອທົດສອບຄວາມອ່ອນແອດ້ານຄວາມປອດໄພໃນລະບົບເຊັ່ນ: ເວທີຄອມພິວເຕີ້ຟັງຈາກບໍລິສັດເຊັ່ນ Microsoft ແລະ Google.

Watermarking

watermark ເປັນວິທີທີ່ຈະບອກວ່າສຽງຫຼືຮູບພາບໄດ້ຖືກສ້າງຂື້ນໂດຍ AI. ຂໍ້ເທັດຈິງທີ່ກວດສອບການຢັ້ງຢືນສາມາດປະກອບມີຂໍ້ມູນກ່ຽວກັບຜູ້ທີ່ສ້າງມັນ, ເຊັ່ນດຽວກັນກັບວິທີການແລະເວລາທີ່ມັນຖືກສ້າງຫຼືດັດແກ້.

ສໍາລັບຕົວຢ່າງ, Microsoft ໄດ້ໃຫ້ຄໍາຫມັ້ນສັນຍາກັບຮູບພາບນ້ໍາທີ່ສ້າງຂຶ້ນໂດຍເຄື່ອງມື AI ຂອງຕົນ. ບັນດາບໍລິສັດຕ່າງໆຍັງໄດ້ໃຫ້ຄຳໝັ້ນສັນຍາກັບທຳນຽບຂາວວ່າ ຈະສ້າງຮູບລາຍນ້ຳ ຫຼືບັນທຶກແຫຼ່ງກຳເນີດຂອງພວກມັນເພື່ອລະບຸວ່າພວກມັນເປັນເຄື່ອງທີ່ສ້າງຂຶ້ນດ້ວຍ AI.

Watermarks ຍັງຖືກນໍາໃຊ້ໂດຍທົ່ວໄປເພື່ອຕິດຕາມການລະເມີດຊັບສິນທາງປັນຍາ. Watermarks ສໍາລັບຮູບພາບທີ່ສ້າງໂດຍ AI ສາມາດປາກົດເປັນສິ່ງລົບກວນທີ່ບໍ່ສາມາດຮັບຮູ້ໄດ້, ເຊັ່ນ: ການປ່ຽນແປງເລັກນ້ອຍໃນທຸກໆ pixels ເຈັດ.

ຢ່າງໃດກໍຕາມ, watermarking ຂໍ້ຄວາມທີ່ສ້າງໂດຍ AI ສາມາດສັບສົນຫຼາຍແລະອາດຈະກ່ຽວຂ້ອງກັບການປັບຕົວແບບຄໍາເພື່ອໃຫ້ມັນສາມາດຖືກກໍານົດວ່າເປັນເນື້ອຫາທີ່ສ້າງໂດຍ AI.

Hoang Ton (ຕາມທ່ານ Poynter)

ທີ່ມາ

![[ຮູບພາບ] ທ່ານເລຂາທິການໃຫຍ່ To Lam ເຮັດວຽກກັບບັນດາຄະນະປະຈຳກອງປະຊຸມໃຫຍ່ຄັ້ງທີ 14 ຂອງພັກ.](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F09%2F1765253019536_a1-bnd-0983-4829-jpg.webp&w=3840&q=75)

![[ຮູບພາບ] ເລັ່ງດ່ວນເພື່ອໃຫ້ປະຊາຊົນທັນທີມີທີ່ຢູ່ອາໄສແລະສະຖຽນລະພາບຂອງເຂົາເຈົ້າ](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F09%2F1765248230297_c-jpg.webp&w=3840&q=75)

(0)