Hvordan fungerer falske AI-bilder?

AI er overalt i disse dager – selv i krig. Kunstig intelligens-applikasjoner har blitt så mye bedre i år at nesten hvem som helst kan bruke AI-generatorer til å lage bilder som ser realistiske ut, i hvert fall ved første øyekast.

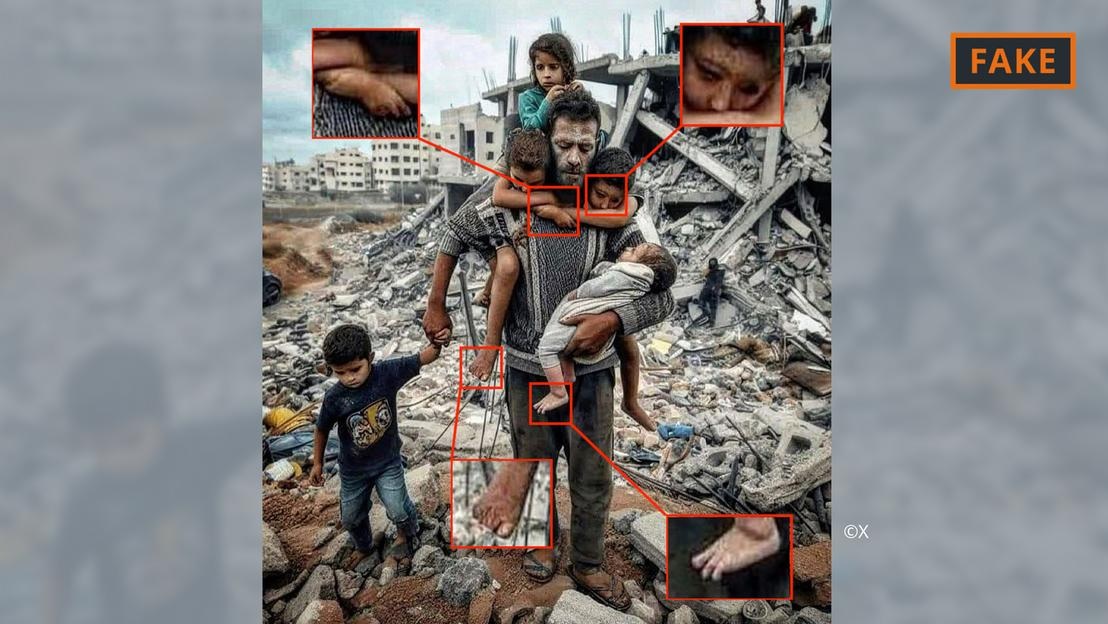

Et AI-generert falskt bilde av krigen i Gaza.

Brukere gir ganske enkelt verktøy som Midjourney eller Dall-E noen få ledetekster, inkludert spesifikasjoner og informasjon, for å gjøre dette. AI-verktøyene konverterer deretter tekst-, eller til og med tale-, ledetekstene til bilder.

Denne bildegenereringsprosessen er basert på det som kalles maskinlæring. Hvis en skaper for eksempel ber om å vise en 70 år gammel mann som sykler, vil de søke i databasen sin for å finne samsvarende søkeord med bilder.

Basert på tilgjengelig informasjon vil AI-algoritmen generere et bilde av den eldre syklisten. Med stadig mer innspill og tekniske oppdateringer har disse verktøyene blitt mye bedre, og de lærer stadig mer.

Alt dette brukes på bilder relatert til Midtøsten-konflikten. I en konflikt der «følelsene er så høye», har feilinformasjon, inkludert spredning gjennom AI-bilder, en enorm innvirkning, sier AI-ekspert Hany Farid.

Farid, professor i digital analyse ved University of California i Berkeley, sa at harde kamper er det perfekte grobunnet for å lage og spre falskt innhold, samt å gi næring til følelser.

Typer AI-bilder av Israel-Hamas-krigen

Bilder og videoer laget med hjelp av kunstig intelligens har gitt næring til desinformasjon knyttet til krigen i Ukraina, og det fortsetter å skje i Israel-Hamas-krigen.

Ifølge eksperter faller AI-bilder som sirkulerer på sosiale medier om krig ofte inn i to kategorier. Den ene fokuserer på menneskers lidelse og vekker sympati. Den andre er falsk AI som overdriver hendelser, og dermed oppfordrer til konflikt og eskalerer vold.

AI-generert falskt bilde av far og barn i ruinene i Gaza.

For eksempel inkluderer den første kategorien bildet ovenfor av en far og hans fem barn foran en haug med ruiner. Det ble delt flere ganger på X (tidligere Twitter) og Instagram, og sett hundretusenvis av ganger.

Dette bildet har blitt flagget av fellesskapet, i hvert fall på X, som en forfalskning. Det kan gjenkjennes ved diverse feil og inkonsekvenser som er vanlige for AI-bilder (se bildet ovenfor).

Lignende avvik kan også sees i det falske AI-bildet som gikk viralt på X nedenfor, som angivelig viser en palestinsk familie som spiser sammen på ruinene.

AI-generert falskt bilde av palestinsk parti.

I mellomtiden faller et annet bilde som viser tropper som vifter med israelske flagg mens de passerer gjennom en bosetning fylt med bombede hjem inn i den andre kategorien, som er utformet for å hisse opp til hat og vold.

Hvor kommer slike AI-bilder fra?

De fleste AI-genererte bilder av konflikter legges ut på sosiale medieplattformer, men de er også tilgjengelige på en rekke andre plattformer og organisasjoner, og til og med på noen nyhetssider.

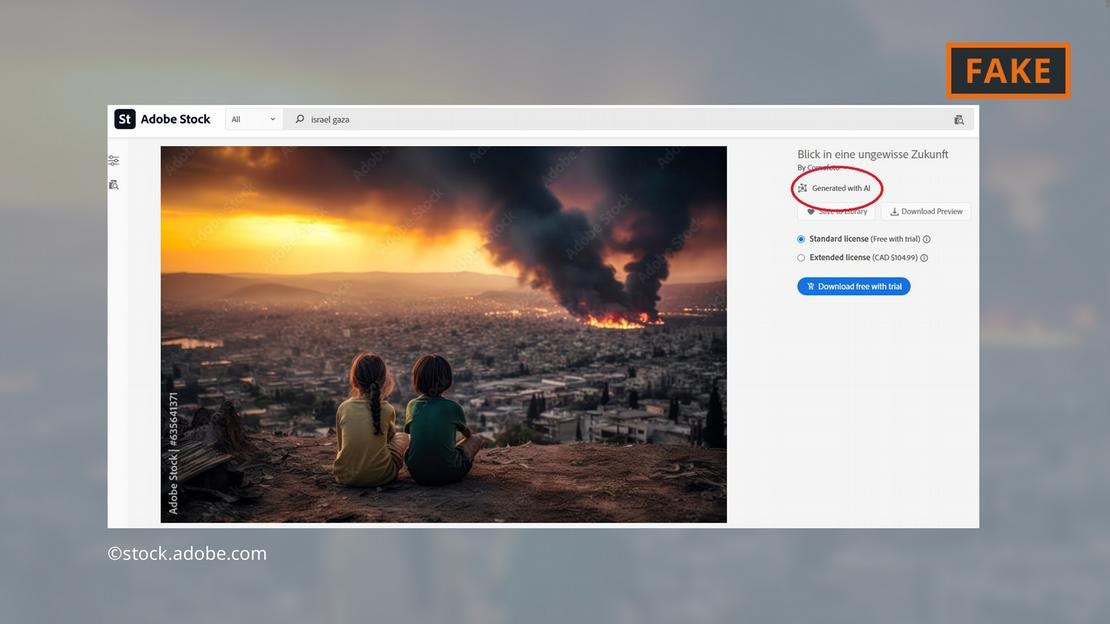

Programvareselskapet Adobe har skapt overskrifter ved å legge til AI-genererte bilder i sitt utvalg av stockbilder innen utgangen av 2022. De vil bli merket deretter i databasen.

Adobe tilbyr nå også AI-bilder av krigen i Midtøsten for salg – som eksplosjoner, folk som protesterer eller røyksøyler bak Al-Aqsa-moskeen.

Adobe tilbyr AI-genererte bilder av kampene i Gaza.

Kritikere har funnet dette bekymringsfullt, ettersom noen nettsteder har fortsatt å bruke bildene uten å merke dem som AI-genererte. Bildet det gjelder, for eksempel, dukket opp på «Newsbreak»-siden uten noen indikasjon på at det var AI-generert.

Selv European Parliamentary Research Service, den vitenskapelige grenen av Europaparlamentet, illustrerte en netttekst om Midtøsten-konflikten med et AI-bilde fra Adobes database – uten å merke det som AI-generert.

Det europeiske observatoriet for digitale medier oppfordrer journalister og mediefolk til å være ekstremt forsiktige når de bruker AI-bilder, og fraråder bruk av dem, spesielt når de dekker virkelige hendelser som krigen i Gaza.

Hvor farlige er AI-bilder?

Det virale AI-innholdet og bildene vil garantert gjøre brukerne urolige over alt de møter på nettet. «Hvis vi kommer inn i denne verdenen der bilder, lyd og video kan manipuleres , blir alt mistenkelig», forklarer UC Berkeley-forsker Farid. «Så mister du tilliten til alt, inkludert sannheten.»

Det var akkurat det som skjedde i følgende tilfelle: Et bilde av det som antas å være det forkullede liket av en israelsk baby ble delt på sosiale medier av den israelske statsministeren Benjamin Netanyahu og flere andre politikere.

En anti-israelsk influenser, Jackson Hinkle, hevdet senere at bildet ble laget ved hjelp av kunstig intelligens. Hinkles uttalelse ble sett mer enn 20 millioner ganger på sosiale medier og førte til opphetet debatt på plattformen.

Til slutt erklærte en rekke organisasjoner og verifiseringsverktøy at bildet var ekte, og at Hinkles påstand var falsk. Det er imidlertid tydelig at ingen verktøy kan hjelpe brukere med å gjenvinne den tapte tilliten!

Hoang Hai (ifølge DW)

[annonse_2]

Kilde

![[Foto] Superhøstmånen skinner sterkt på midthøstfestivalkvelden rundt om i verden](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/07/1759816565798_1759814567021-jpg.webp)

Kommentar (0)