Skurker kan bruke AI til å kombinere sensitive bilder og videoer for å ærekrenke og utpresse andre - Foto: AI-tegning

Før i tiden, når man snakket om teknikken med å klippe og lime en persons ansikt på en annen persons kropp, brukte man ofte Photoshop eller spesialisert bilderedigeringsprogramvare – som er arbeidskrevende og lett gjenkjennelig for det blotte øye.

Nå, med AI-verktøy, kan folk gjøre det veldig enkelt på «noen få notater», men det er ikke lett å oppdage med det blotte øye.

Ansiktsbytting sexvideo for utpressing

På grunn av arbeidsforbindelser samhandler herr H. (direktør for en bedrift i Ho Chi Minh-byen) ofte på sosiale nettverk.

En gang ble han venn med en ung jente som spurte om jobben hans. Etter en stund med spørsmål om hverandre, prat og samtaler om jobb og privatliv, virket de to ganske nære hverandre.

Det var også mange tekstmeldinger mellom de to med svært kjærlige ord, i tillegg til bilder sendt frem og tilbake, og videosamtaler for å se hverandre.

En dag mottok Mr. H. plutselig en telefon fra en mann som hevdet å være jentas ektemann. Etter en «forebyggende» handling mot Mr. H. krevde «ektemannen» at han overførte erstatningspenger, ellers ville han sende bilder av samtalene og sexvideoene deres til slektninger og forretningspartnere.

Så ble herr H. vist en sexvideo av seg selv og den andre jenta av sin «mann», sammen med en videosamtale mellom de to, og intime tekstmeldinger ble tatt opp ...

«Jeg har aldri møtt den jenta, så jeg er sikker på at sexvideoen er et photoshoppet bilde», bekreftet herr H. Imidlertid er bildet av jentas ansikt i sexvideoen og jenta i videosamtalen det samme, sammen med et bilde av den kjærlige tekstmeldingen, noe som tvinger herr H. til å overføre penger til «mannen» sin mange ganger for å bevare sitt rykte.

Gjennom Tuoi Tres etterforskning ble herr H. svindlet på en organisert måte etter et perfekt scenario. I denne svindelen ble herr H. lurt to ganger av deepfake. Første gang var det en videosamtale og andre gang en sexvideo.

Det er verdt å merke seg at ansiktet til Mr. H. i sexvideoen var så dyktig podet inn at seerne syntes det var vanskelig å tro at det var en video med ansiktstransplantasjon. En AI-ekspert bekreftet overfor Tuoi Tre at skurkene brukte et nytt AI-verktøy som kunne pode ansikter perfekt inn i videoer ... som ekte ansikter.

AI-verktøy for ansiktsbytte florerer

Det finnes for tiden mange AI-applikasjonsverktøy som har funksjoner som å lage en hvilken som helst person med det ønskede ansiktet, og slå sammen det ønskede ansiktet med en annen persons kropp.

Blant dem finnes det verktøy med funksjoner som tjener dårlige formål, som å gjøre vanlige bilder om til nakenbilder ved å «klæ av» personen på bildet, eller erstatte en persons ansikt i videoer med et ønsket ansikt ...

De fleste av disse AI-verktøyene er tilgjengelige for prøveperiode, men å betale for dem vil gi deg alle funksjonene med svært rask transformasjonstid.

Med ansikt-til-kropp-funksjonen trenger for eksempel brukerne bare å laste opp to tilsvarende bilder og vente noen sekunder på resultatene.

Eller med funksjonen til å lage nakenbilder fra vanlige bilder, kan AI-verktøyet gjøre det veldig raskt, på bare noen få dusin sekunder, noe som gjør seerne forskrekket.

Selv funksjonen med å erstatte ansikter i sexvideoer, gjør AI-verktøyet det veldig raskt, og tar mindre enn et minutt for videoer som er noen få sekunder lange.

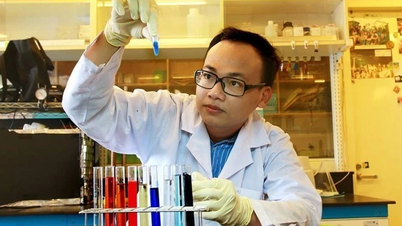

I en samtale med Tuoi Tre analyserte Nguyen Kim Tho, leder for forsknings- og utviklingsteamet til cybersikkerhetsselskapet VNetwork, begrepet deepfake, som refererer til falske videoer og bilder laget med kunstig intelligens for å få seerne til å tro at de er ekte.

Deepfake-teknologi bruker dyplæringsmodeller som nevrale nettverk for å analysere en persons ansikts- og stemmedata og lage falskt innhold som ser nøyaktig ut som den personen.

«Takket være kraftige algoritmer kan gjerningsmenn legge offerets ansikt inn i sensitive videoer (for eksempel «sengevideoer», porno) eller redigere bilder for å lage falske nakenbilder.»

«Deepfake-programvare og -applikasjoner er nå veldig populære på internett, selv med mobilapplikasjoner, åpen kildekode eller gratis nettjenester – noe som gjør det enkelt for alle å få tilgang til verktøy for å lage falske videoer og bilder, så folk må være årvåkne», sa Tho.

Hold deg unna «sexchat»

Mange svindelforsøk starter med at man får venner på nettet og deretter lurer offeret til «sexchat» eller sender sensitive bilder. Derfor bør brukere aldri sende private bilder eller videoer til folk de bare møter på nettet, uansett hvilke løfter eller trusler de kommer med.

Husk alltid at alt innhold som deles (selv via private meldinger) kan bli tatt opp (skjermbilde, video) og deretter redigert og brukt mot deg.

Hvis du har videosamtaler, vær forsiktig med fremmede som ber om sensitivt innhold – det kan være en falsk skjerm eller de tar opp.

Nettsikkerhetseksperter råder brukere til aldri å stole på noen bare gjennom nettkontakt, og å bekrefte den andre personens identitet og intensjoner før de deler noe sensitivt.

Dessuten, hvis du mottar en tekstmelding eller en telefonsamtale som truer med å publisere "hete" bilder for utpressing, trenger ikke brukerne å være redde eller forhaste seg med å overføre penger.

Å betale garanterer ikke at skurkene sletter videoen; de kan fortsette å kreve mer eller legge ut innholdet på nettet uansett, sier eksperter.

I stedet for å følge de kriminelles forespørsler, bør brukerne samle bevis (meldinger, telefonnumre, kontaktkontoer, truende innhold...) og umiddelbart rapportere til nærmeste politimyndighet eller rapportere hendelsen via VNeID-applikasjonen til Ministry of Public Security for rettidig støtte.

Hvordan identifisere?

Ifølge Nguyen Kim Tho blir det stadig vanskeligere å skille mellom ekte bilder og videoer og deepfakes, men det finnes fortsatt noen identifiserende tegn og støttende verktøy.

Brukere kan observere manuelt, fordi deepfake-innhold noen ganger har avvik i bilde og lyd.

For eksempel kan et sammensatt bilde vise støy eller fargeforskjeller mellom det sammensatte ansiktet og kroppen. En falsk video kan ha uoverensstemmelser mellom lyd og bilde (leppebevegelser som ikke samsvarer med tale) eller ansiktsuttrykk som virker stive og unaturlige.

Tidligere gjorde noen deepfake-videoer at karakterene ikke blunket, eller at lyset og skyggene i ansiktet ikke stemte overens med konteksten – noe som var tegn på at videoen var redigert.

Selv om teknologien forbedres (for eksempel har nye deepfakes lagt til realistiske øyeblinkebevegelser), kan observante seere fortsatt oppdage noen ulogiske detaljer i videoer og bilder.

Forskere utvikler nå mange algoritmer for automatisk å oppdage deepfake-spor.

AI-generert innhold etterlater ofte et særegent «digitalt fingeravtrykk» i hver piksel som maskiner kan gjenkjenne.

For eksempel har Intel introdusert den første sanntids deepfake-detektoren, som er i stand til å analysere videoer og avgjøre om karakterene i dem er ekte mennesker eller AI-genererte.

I tillegg lar noen nettsteder brukere laste opp videoer og bilder for å sjekke ektheten til bildene (for eksempel Deepware, Sensity AI-verktøy...). Disse systemene oppdateres kontinuerlig for å holde tritt med nye deepfake-teknikker.

Brukere kan spesielt sjekke kilden til innlegget og konteksten når de støter på en sensitiv video eller et sensitivt bilde, fordi mange deepfake-videoer spres gjennom falske kontoer eller roboter på sosiale nettverk.

«Hvis sensitivt innhold om en person kommer fra en uoffisiell kilde eller en anonym konto, vær skeptisk til autentisiteten. Du kan prøve å kontakte personen som er omtalt i innholdet direkte for å bekrefte at de faktisk gjorde det.»

I tillegg fremmer prosjekter som [navn på artikkelen] innebygging av autentiseringsinformasjon (digitale signaturer) i bilder og videoer helt fra opprettelsesøyeblikket, noe som bidrar til å skille originalt innhold fra redigert innhold. I fremtiden kan brukere bruke disse autentiseringstegnene til å identifisere troverdig innhold, sa Tho.

5 tips for å beskytte deg selv

1. Begrens deling av sensitive, private bilder og videoer (spesielt nakenbilder, familiebilder, barn).

2. Sett kontoene dine på sosiale medier til private (del kun med personer du stoler på).

3. Ikke oppgi for mye personlig informasjon (fullt navn, telefonnummer, adresse...) på offentlige sosiale nettverk.

4. Angi sterke passord og aktiver totrinnsverifisering for kontoene dine for å unngå å bli hacket.

5. Søk regelmessig etter navnet og bildet ditt på Google (eller bruk verktøy for omvendt bildesøk som Google Image og TinEye) for å se om noen av bildene dine har blitt lagt ut uten tillatelse, og be om at de fjernes umiddelbart.

Kilde: https://tuoitre.vn/dung-ai-ghep-hinh-anh-nhay-cam-de-tong-tien-20250317075948373.htm

![[Foto] Høytidelig åpning av den første partikongressen i Nasjonalforsamlingen, periode 2025–2030](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/9/25/e995fd3a6c724c6c8264b371fb20ab67)

![[Foto] Statsminister Pham Minh Chinh mottar generaldirektøren i Verdensorganisasjonen for immaterielle rettigheter (WIPO), Daren Tang](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/9/25/64a5925ecc2243e09bd7a5695b52e295)

Kommentar (0)