Gigant technologiczny jest pod coraz większą presją w USA i Europie z powodu oskarżeń, że jego aplikacje uzależniają i powodują problemy ze zdrowiem psychicznym u młodych ludzi.

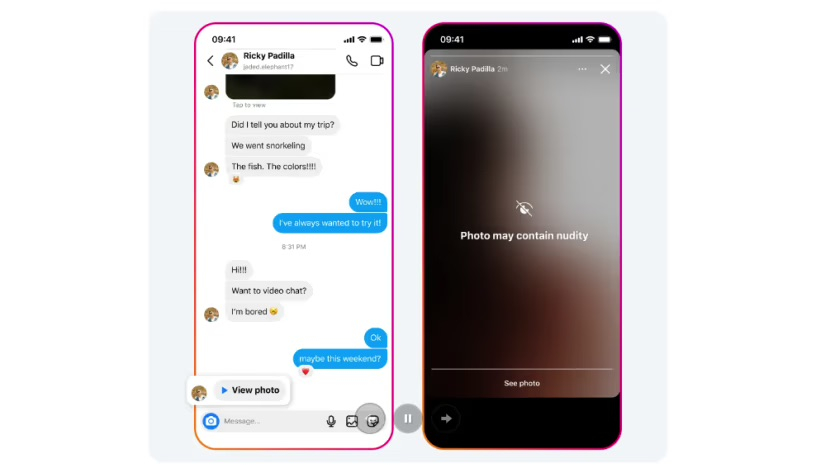

Gdy ktoś otrzyma wiadomość na Instagramie zawierającą nagie zdjęcie, obraz zostanie automatycznie rozmyty pod ekranem ostrzegawczym. Zdjęcie: Meta

Funkcja ochrony wiadomości bezpośrednich na Instagramie będzie wykorzystywać uczenie maszynowe na urządzeniu do analizy, czy obrazy przesyłane za pośrednictwem usługi zawierają nagość, poinformowała firma Meta.

Funkcja ta będzie domyślnie włączona dla użytkowników poniżej 18 roku życia, a Meta powiadomi osoby dorosłe, zachęcając je do jej włączenia.

„Ponieważ obrazy są analizowane na samym urządzeniu, ochrona przed nagością będzie działać również w przypadku szyfrowanych w pełni czatów, w których Meta nie będzie miała dostępu do tych obrazów – chyba że ktoś zdecyduje się je nam zgłosić” – poinformowała firma.

W przeciwieństwie do aplikacji Messenger i WhatsApp firmy Meta, wiadomości bezpośrednie na Instagramie nie są szyfrowane, ale firma zapowiada, że planuje wdrożyć szyfrowanie dla usługi udostępniania zdjęć.

Firma Meta poinformowała również, że opracowuje technologię, która ma pomóc w identyfikacji kont mogących być zaangażowanych w oszustwa związane z sekstorcją, i testuje możliwość włączania nowych powiadomień dla użytkowników, którzy mogli wchodzić w interakcje z tymi kontami.

W styczniu Meta ogłosiła, że będzie ukrywać przed nastolatkami więcej treści na Facebooku i Instagramie, dodając, że utrudni to młodym ludziom dostęp do drażliwych treści, takich jak te dotyczące samobójstw, samookaleczenia i zaburzeń odżywiania.

Trzydzieści trzy stany USA, w tym Kalifornia i Nowy Jork, pozwały Meta w październiku 2023 roku, twierdząc, że firma technologiczna wielokrotnie okłamywała opinię publiczną na temat zagrożeń związanych z jej platformą. Komisja Europejska nakazała również Meta ochronę dzieci przed nielegalnymi i szkodliwymi treściami.

Mai Anh (według CNA)

Źródło

![[Zdjęcie] Prezydent Luong Cuong przyjmuje sekretarza wojny USA Pete’a Hegsetha](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/02/1762089839868_ndo_br_1-jpg.webp)

Komentarz (0)