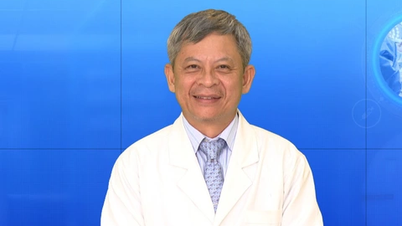

O que você acha da tendência de hackers "armarem" a IA para realizar ataques cibernéticos e fraudes?

Dr. Nguyen Tuan Khang: De acordo com o Índice de Inteligência de Ameaças X-Force da IBM de 2024, a região Ásia- Pacífico , incluindo o Vietnã, é a que sofrerá o maior número de ataques cibernéticos no mundo em 2023. Dentre eles, o setor manufatureiro é o mais afetado por esses ataques.

O principal método utilizado por criminosos cibernéticos ainda são os ataques de phishing, que visam pessoas vulneráveis e exploram essas vulnerabilidades para instalar malware. Além disso, a tendência emergente em 2024 são os ataques cibernéticos que envolvem inteligência artificial (IA).

A reportagem da Wired destaca que muitos criminosos estão usando IA generativa para orientar ataques cibernéticos, criar chatbots fraudulentos ou gerar imagens e vídeos deepfake que imitam rostos e vozes de outras pessoas.

No entanto, acompanhando essa tendência, os sistemas de segurança da informação também estão começando a integrar recursos de IA, como o WatsonX. A inteligência artificial pode ser explorada, mas também pode substituir humanos na análise, monitoramento, identificação de dados e previsão de cenários de ataque, melhorando assim as capacidades de defesa e minimizando os riscos à segurança da informação.

Golpes com deepfakes estão se tornando cada vez mais comuns. Com o rápido desenvolvimento da IA, quão perigosos esses ataques serão no futuro?

Dr. Nguyen Tuan Khang: Basicamente, deepfake é uma tecnologia que ajuda hackers a criar identidades digitais falsas, personificando outras pessoas. Deepfake será um problema perigoso porque essa tecnologia está se tornando cada vez mais sofisticada.

Para combater os deepfakes, o primeiro passo é determinar se a imagem ou a voz de uma pessoa foi gerada por inteligência artificial. Atualmente, não existe uma ferramenta universal capaz de detectar deepfakes imediatamente, pois os atacantes estão constantemente desenvolvendo novos modelos.

Além da detecção de deepfakes, existe outra técnica para lidar com o problema, que consiste em usar a tecnologia para analisar o comportamento. Do ponto de vista organizacional e empresarial, é necessário desenvolver um sistema que combine essas duas técnicas.

Nos últimos tempos, têm ocorrido ataques cibernéticos em que hackers instalam malware secretamente nos sistemas das empresas. O malware fica à espreita, analisando todas as atividades e criando identidades falsas para executar ações maliciosas. Com o desenvolvimento da tecnologia Deepfake, aliado à capacidade de criar vídeos com inteligência artificial, esses tipos de ataques serão muito mais perigosos no futuro.

Com o aumento dos ciberataques com deepfakes, como podemos proteger idosos, crianças e outros grupos vulneráveis de golpistas?

Dr. Nguyen Tuan Khang: Idosos e crianças são frequentemente alvos de golpistas que utilizam uma técnica chamada engenharia social. Este termo descreve ataques que se baseiam na manipulação do comportamento humano.

Os hackers agora podem usar IA em combinação com coleta, mineração e análise de dados para identificar pessoas com maior probabilidade de serem vítimas de golpes e, em seguida, encontrar maneiras de atacá-las. Além de conscientizar a comunidade, também devemos aceitar que situações em que usuários são enganados ocorrerão e devemos usar a tecnologia para detectá-las e preveni-las.

Recentemente, houve um caso em que um funcionário de um banco suspeitou que uma senhora idosa que foi transferir dinheiro apresentava sinais de estar sendo vítima de um golpe. Ele prontamente interrompeu a transação e denunciou o caso às autoridades. Os sistemas de TI dos bancos agora contam com tecnologia para substituir humanos em tarefas como essa.

O papel da tecnologia é que, mesmo que o remetente seja comprovadamente a pessoa real, o sistema ainda interromperá a transferência se houver suspeita de que a transação esteja sendo manipulada por outra pessoa. Essas ferramentas são chamadas de sistemas de prevenção de fraudes.

Será que chegou a hora de o Vietnã impor sanções para gerir a IA e estruturar a pesquisa, o desenvolvimento e a utilização da IA?

Dr. Nguyen Tuan Khang: A questão da gestão por IA tem sido discutida há muito tempo, porém, ainda existem muitas controvérsias. Por exemplo, o estacionamento na minha região possui um sistema de IA para reconhecimento de placas, mas mesmo assim ocorreram furtos. Na época, surgiu a controvérsia sobre de quem era a culpa. Do proprietário do apartamento, do segurança ou do desenvolvedor do sistema de IA?

Desde então, o prédio mudou suas regras, estabelecendo que os moradores podem optar por usar IA para reconhecimento de placas de veículos, por conveniência, mas precisam aceitar os riscos. Aqueles que concordarem poderão usar as portas automáticas; aqueles que não concordarem terão que estacionar seus carros da maneira antiga. Precisamos de sanções como essa.

De forma semelhante, a IBM desenvolveu um sistema de IA para ajudar na prevenção do câncer. Quando o sistema prescreveu um medicamento, mas o paciente o tomou e mesmo assim não pôde ser salvo, a culpa é do médico ou da IA?

Acredito que a regulamentação da IA precisa ser específica, definindo claramente o que pode e o que não pode ser feito no desenvolvimento de aplicações de IA. Para tornar o mundo mais seguro, a regulamentação mais básica que podemos implementar é exigir que grandes transferências de dinheiro sejam reconhecidas biometricamente. Dessa forma, pessoas que perderem seus dados de identidade podem evitar completamente a perda de dinheiro.

Obrigado.

Fonte

![[Foto] Arte única de pintura de máscaras Tuong](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/14/1763094089301_ndo_br_1-jpg.webp)

![[Foto] Arquitetura singular da estação de metrô mais profunda da França](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/14/1763107592365_ga-sau-nhat-nuoc-phap-duy-1-6403-jpg.webp)

![[Foto] Aula especial em Tra Linh](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/14/1763078485441_ndo_br_lop-hoc-7-jpg.webp)

Comentário (0)