Atacați din toate unghiurile.

Google a lansat un nou produs de inteligență artificială (IA) numit „Gemini Nano Banana”, care nu este o IA lingvistică (LLM) la scară largă capabilă să scrie și să raționeze, ci mai degrabă o IA specializată în editarea fotografiilor... Mulți utilizatori sunt entuziasmați de acest instrument, dar acesta aduce cu sine și o serie de dezavantaje.

„Este ca un «pas înapoi» în tehnologia IA și în limitele etice”, a declarat Nguyen Hong Phuc, director științific al Conductify AI, exprimându-și opinia personală. „Gemini Nano Banana are capacități eficiente de editare a imaginilor. Dar decenzurarea de către Google a tehnologiei Gemini Nano Banana, slăbind barierele și mecanismele de limitare, permite acestei IA să creeze imagini incredibil de asemănătoare cu cele ale vedetelor, imagini sugestive, imagini sensibile etc.”, a spus Phuc.

Potrivit domnului Nguyen Hong Phuc, această capacitate face din Gemini Nano Banana un instrument pentru crearea de imagini false realiste, până în punctul în care nici măcar experții în inteligență artificială nu le pot distinge, ceea ce duce la noi riscuri de fraudă și securitate cibernetică, cum ar fi crearea de fotografii false cu politicieni celebri pentru a răspândi informații false și chiar persoane care sunt supuse manipulării și defăimării fotografiilor generate de inteligența artificială pe rețelele de socializare...

În plus, având în vedere că zeci de alte instrumente de editare foto bazate pe inteligență artificială iau cu asalt internetul, escrocheriile deepfake nu dau semne că se vor opri. Statisticile organizațiilor de securitate arată că tehnologia deepfake creează campanii de phishing care vizează persoane valoroase, în special lideri de afaceri. În 2024, au existat 140.000-150.000 de cazuri la nivel global, 75% dintre acestea vizând directori generali și directori executivi... Deepfake-urile ar putea crește pierderile economice globale cu 32%, aproximativ 40 de miliarde de dolari pe an, până în 2027.

Recent, compania de inteligență artificială Anthropic a detectat și a dejucat o campanie de atac cibernetic desfășurată de hackeri străini, care au înregistrat pentru prima dată utilizarea inteligenței artificiale pentru a coordona activități de atac automate. Mai exact, hackerii au folosit sisteme de inteligență artificială pentru a planifica, direcționa și implementa operațiuni de intruziune - o evoluție „îngrijorătoare” care riscă să extindă amploarea și viteza campaniilor de atac cibernetic...

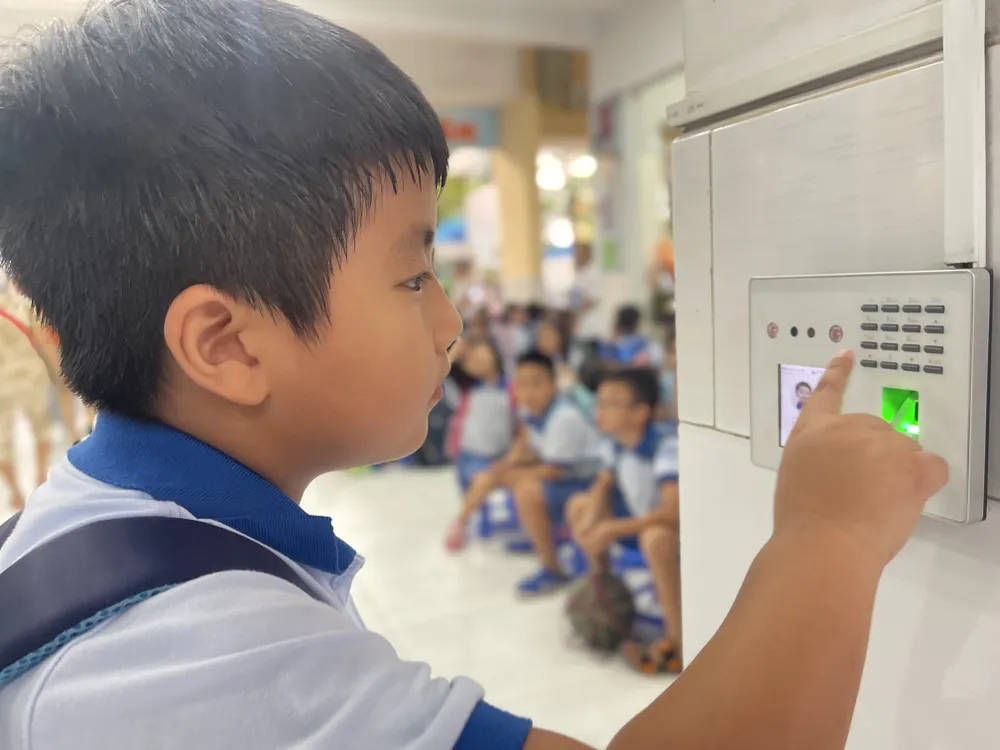

Dl. Ngo Minh Hieu, directorul Organizației Antifraudă a Asociației Naționale pentru Securitate Cibernetică, a declarat că instrumentele integrate cu inteligență artificială cresc viteza de fraudă de aproximativ 20 de ori în comparație cu utilizarea unor persoane reale. Escrocii furnizează inteligenței artificiale un scenariu de fraudă pentru analiză, iar sistemul discută automat cu victimele. Din datele inițiale, inteligența artificială poate înțelege ce își dorește victima și poate comunica cu aceasta în timp real. Cea mai sofisticată tactică este atacul „Man-in-the-Middle”, în care, atunci când un utilizator efectuează autentificarea video (cum ar fi înregistrarea feței sau darea de comenzi), hackerul intervine pentru a interfera cu datele transmise. Infractorii cibernetici introduc apoi videoclipuri deepfake pre-pregătite, înlocuind fluxul de date reale al utilizatorului pentru a ocoli procesul de autentificare. Cu această metodă, sistemele de securitate ale băncilor și instituțiilor financiare sunt, de asemenea, expuse riscului de a fi înșelate.

O mai bună gestionare a datelor

Pe măsură ce inteligența artificială devine din ce în ce mai răspândită, riscurile de securitate și confidențialitate cresc și ele semnificativ. Datele stocate și procesate pe servere la distanță vor deveni o țintă atractivă pentru hackeri și infractori cibernetici. Conform datelor de la Asociația Națională pentru Securitate Cibernetică, numai în al doilea trimestru al anului 2025, numărul atacurilor cibernetice bazate pe inteligență artificială a crescut cu 62%, provocând pierderi globale de până la 18 miliarde de dolari...

Experții consideră că protecția datelor este crucială. Cu toate acestea, colectarea și vânzarea de date continuă în mod deschis pe multe platforme de „piață neagră”, pentru doar 20 de dolari pe lună. Infractorii cibernetici pot utiliza instrumente care imită modele lingvistice, dar sunt personalizate în scopuri criminale. Aceste instrumente sunt capabile să genereze programe malware și chiar să ocolească software-ul antivirus.

În Vietnam, Decretul nr. 13/2023/ND-CP (intrat în vigoare de la 17 aprilie 2023) reglementează protecția datelor cu caracter personal. În plus, Legea privind protecția datelor cu caracter personal, care se așteaptă să intre în vigoare la 1 ianuarie 2026, va deschide un mecanism juridic mai puternic pentru a aborda riscul scurgerilor de date cu caracter personal și al utilizării abuzive. Cu toate acestea, potrivit Asociației Naționale pentru Securitate Cibernetică, eficacitatea aplicării legii trebuie încă consolidată pe baza a trei piloni: creșterea gradului de conștientizare a publicului, creșterea responsabilității corporative și îmbunătățirea capacității de procesare a agențiilor de reglementare. Dincolo de măsurile tehnice, fiecare individ trebuie să își dezvolte capacitatea de a identifica semne neobișnuite și suspecte și de a se proteja în mod proactiv de interacțiunile digitale periculoase...

Kaspersky a avertizat cu privire la exploatarea Dark AI (un termen care se referă la implementarea de modele lingvistice mari (LLM) care operează în afara controalelor de securitate standard, permițând adesea acțiuni precum phishing, manipulare, atacuri cibernetice sau abuz de date). Organizațiile și persoanele fizice trebuie să se pregătească pentru a face față unor atacuri cibernetice din ce în ce mai sofisticate și greu de detectat, din cauza creșterii Dark AI în regiunea Asia-Pacific.

Sergey Lozhkin, șeful echipei globale de cercetare și analiză (GReAT) pentru regiunile Orientul Mijlociu, Turcia, Africa și Asia-Pacific la Kaspersky, a declarat că o manifestare a abuzului actual al inteligenței artificiale este apariția modelelor Black Hat GPT. Acestea sunt modele de inteligență artificială special dezvoltate sau modificate pentru a servi scopuri lipsite de etică și ilegale, cum ar fi crearea de programe malware, crearea de e-mailuri de phishing fluente și persuasive pentru atacuri la scară largă, crearea de voci și videoclipuri deepfake și chiar susținerea unor atacuri simulate.

Experții Kaspersky recomandă ca persoanele fizice și companiile să utilizeze soluții de securitate de ultimă generație pentru a detecta programele malware generate de inteligența artificială, prioritizând totodată protecția datelor. Companiile ar trebui să implementeze instrumente de monitorizare în timp real pentru a urmări exploatarea vulnerabilităților bazate pe inteligență artificială; să consolideze controlul accesului și instruirea angajaților pentru a limita utilizarea inteligenței artificiale în zona întunecată și riscul de scurgeri de date; și să înființeze un centru de operațiuni de securitate cibernetică pentru a monitoriza amenințările și a răspunde rapid la incidente.

Sursă: https://www.sggp.org.vn/bao-mat-du-lieu-thoi-ai-post824210.html

![[Imagine] Un „oraș locuibil” de vis sub nori roz](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2026/02/24/1771930060937_tp4-jpg.webp)

![[Foto] Șeful Departamentului Central de Propagandă și Mobilizare în Masă vizitează și felicită Ministerul Sănătății și Institutul de Medicină Tradițională Militară.](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2026/02/24/1771938483290_img-2682-3562-jpg.webp)

![[Fotografie] Flori albe de per înfloresc peste granița orașului Pho Bang](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2026/02/24/1771927665653_a8-8280-jpg.webp)

Comentariu (0)