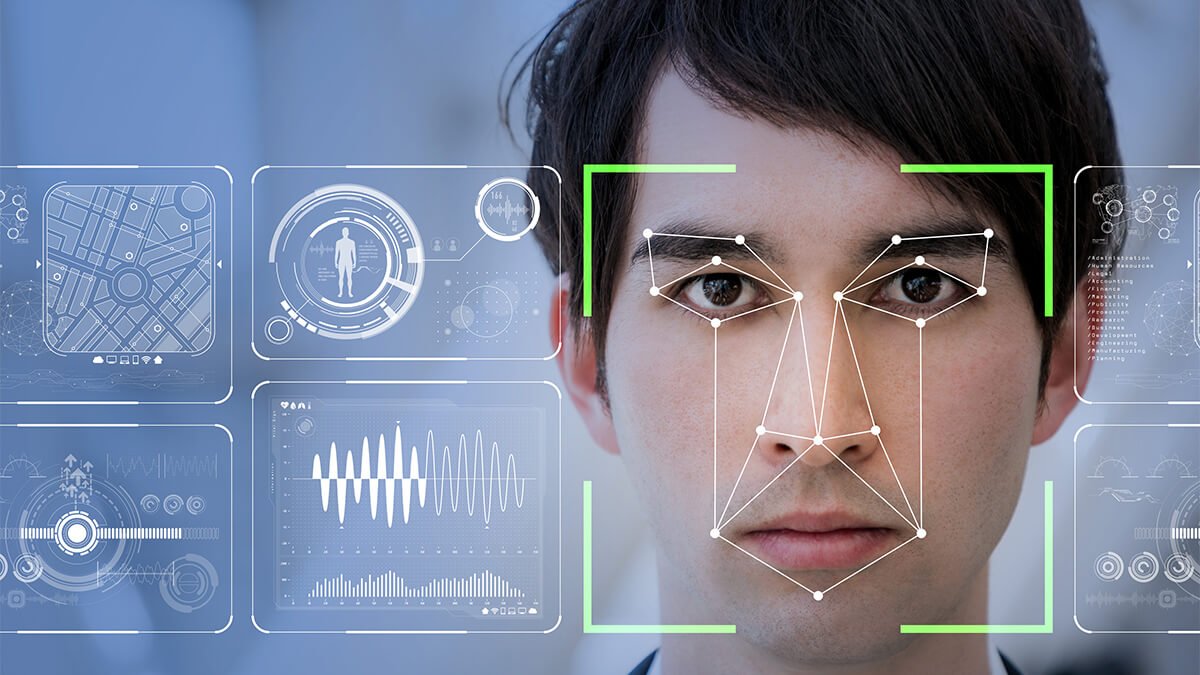

Поскольку технологический прогресс продолжает оказывать влияние на социальные сети и средства массовой информации, дипфейки становятся серьезной проблемой, поскольку количество подобных мошенничеств продолжает расти.

Дипфейки могут быть использованы в плохих целях

После исследования форумов даркнета, где часто действуют киберпреступники, Касперский пришел к выводу, что многие преступники используют дипфейки в мошеннических целях, причем спрос на них значительно превышает предложение программного обеспечения для дипфейков, представленного в настоящее время на рынке.

По прогнозам экспертов «Лаборатории Касперского», поскольку спрос превышает предложение, дипфейковые мошенничества станут более разнообразными и изощренными: от предложения высококачественного видео с имитацией другого человека и полного комплекса услуг по его производству до использования изображений знаменитостей в поддельных прямых трансляциях в социальных сетях с обещанием удвоить сумму, отправленную жертвой.

«Дипфейки стали кошмаром для женщин и общества. Киберпреступники теперь используют искусственный интеллект (ИИ), чтобы вставлять лица жертв в порнографические фотографии и видео, а также в пропагандистские кампании. Эти формы направлены на манипулирование общественным мнением, распространяя ложную информацию или даже нанося ущерб репутации организаций или отдельных лиц. Мы призываем общественность быть более бдительными в отношении этой угрозы», — заявила г-жа Во Дуонг Ту Дьем, директор представительства Kaspersky во Вьетнаме.

По данным информационно-справочной системы Regula, до 37% компаний по всему миру сталкивались с мошенничеством с использованием дипфейков, а 29% — с использованием дипфейков в видео. Дипфейки стали угрозой кибербезопасности во Вьетнаме, где киберпреступники часто используют дипфейковые видеозвонки, чтобы выдавать себя за других людей и занимать крупные суммы денег у родственников и друзей на неотложные нужды. Более того, дипфейковый видеозвонок может длиться всего одну минуту, что затрудняет для жертвы различение настоящих звонков от поддельных.

В то время как преступники используют искусственный интеллект в вредоносных целях, частные лица и компании по-прежнему могут использовать его для выявления дипфейков и снижения вероятности успеха мошенничества.

«Лаборатория Касперского» делится решениями, которые помогут пользователям защититься от мошенничества с использованием дипфейков:

Инструменты обнаружения контента с использованием ИИ : Программное обеспечение для обнаружения контента, созданное с помощью ИИ, использует передовые алгоритмы ИИ для анализа и определения степени манипуляции изображениями, видео- и аудиофайлами. В случае с дипфейковыми видео некоторые инструменты помогают выявлять несоответствие движений рта и речи. Другие инструменты обнаруживают аномальный кровоток под кожей, анализируя разрешение видео, поскольку при перекачивании крови сердце меняет цвет вен.

Контент, созданный с помощью ИИ, помечен водяными знаками : водяные знаки служат идентификационными знаками на изображениях, видео и т. д., помогая авторам защищать авторские права на работы с ИИ. Однако этот инструмент может стать оружием против дипфейков, поскольку позволяет отследить происхождение платформы, создавшей ИИ.

Происхождение контента : поскольку ИИ собирает большие объемы данных из различных источников для создания нового контента, этот подход направлен на отслеживание происхождения этого контента.

Аутентификация видео : это процесс проверки того, что видеоконтент не был изменён с момента его создания. Именно этот процесс больше всего беспокоит создателей видео. Некоторые новые технологии используют криптографические алгоритмы для вставки хеш-значений в видео через заданные интервалы. Если видео было отредактировано, хеш-значение будет изменено.

Ссылка на источник

![[Фото] Подписание соглашения о сотрудничестве между министерствами, ведомствами и местными органами власти Вьетнама и Сенегала](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/7/24/6147c654b0ae4f2793188e982e272651)

Комментарий (0)